Apple a annoncé une flopée de nouvelles fonctionnalités d’accessibilité à venir dans iOS, watchOS et iPadOS plus tard cette année. Ces fonctionnalités sont conçues pour les utilisateurs souffrant de handicaps de mobilité, de vision, d’audition et de cognition.

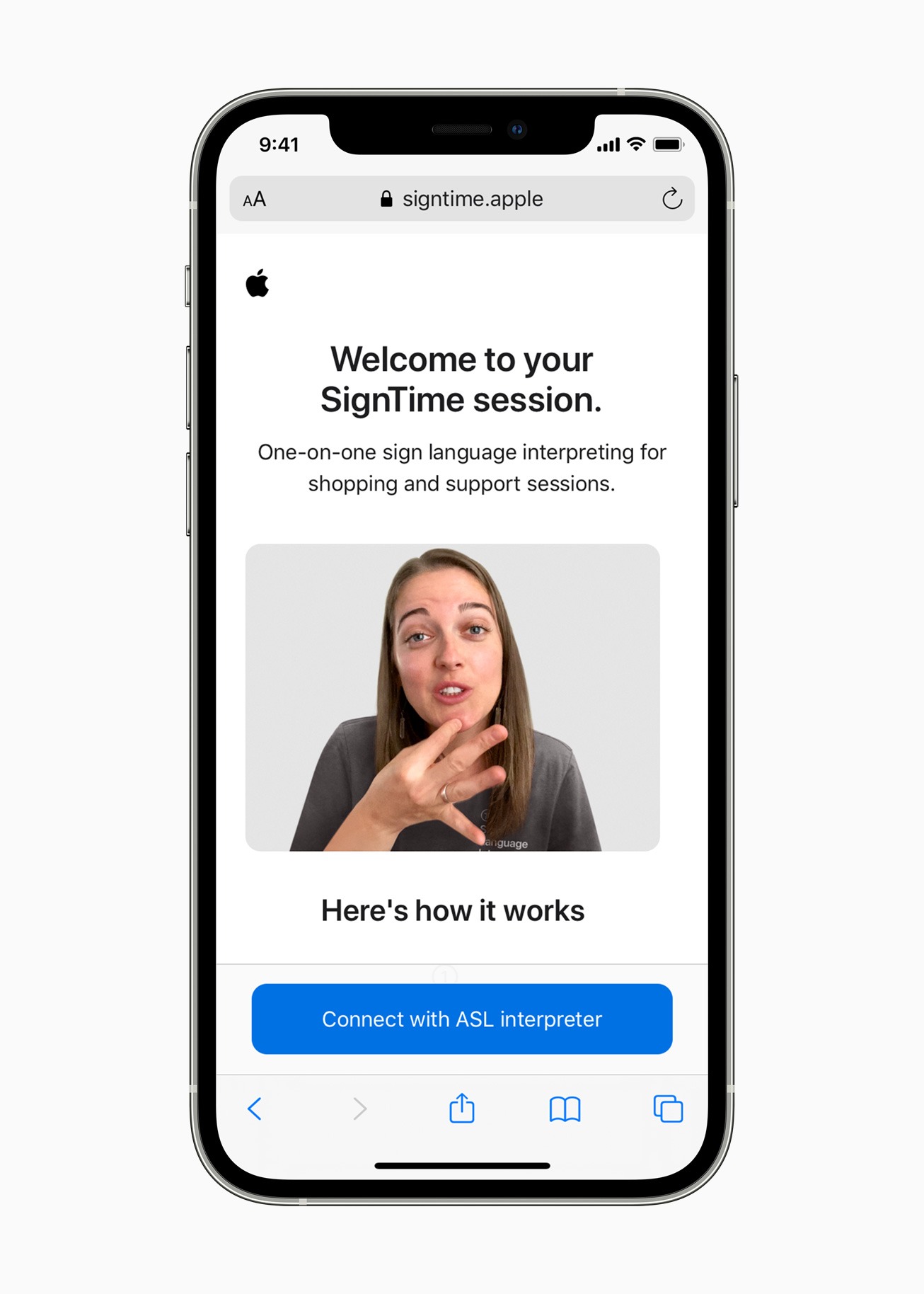

Lancé aujourd’hui, le premier service s’appelle SignTime et permet aux clients de communiquer avec le langage des signes avec AppleCare et le service clientèle de la société. Les clients peuvent utiliser la langue des signes américaine (ASL) aux États-Unis, la langue des signes britannique (BSL) au Royaume-Uni et la langue des signes française (LSF) en France pour que les responsables d’Apple Care répondent à leurs questions.

De plus, Apple ajoute AssistiveTouch sur watchOS pour aider les utilisateurs présentant des différences au niveau des membres supérieurs du corps de profiter des atouts de l’Apple Watch sans jamais avoir à toucher l’écran ou les commandes.

La fonctionnalité peut détecter des différences subtiles dans les mouvements musculaires et permet aux utilisateurs de faire naviguer un curseur sur l’écran grâce à des gestes de la main tels pincer avec deux doigts ou serrer le poing. Ainsi, les utilisateurs peuvent facilement répondre aux appels entrants, contrôler un pointeur à l’écran, et plus encore, directement sur l’Apple Watch.

C’est l’une des meilleures fonctions d’accessibilité que j’ai jamais vues sur une montre connectée. Si vous souhaitez utiliser de telles fonctionnalités, consultez ce guide sur l’utilisation des raccourcis d’accessibilité sur l’Apple Watch.

Suivi du regard pour l’iPad

iPadOS permettra aux utilisateurs de contrôler leur iPad à l’aide de leurs yeux, grâce à la prise en charge des dispositifs de suivi oculaire tiers. Ainsi, les appareils MFi compatibles suivront désormais les mouvements des yeux de la personne et déplaceront le pointeur en conséquence. Dans le même temps, un contact visuel prolongé entraînera des actions telles qu’un tapotement.

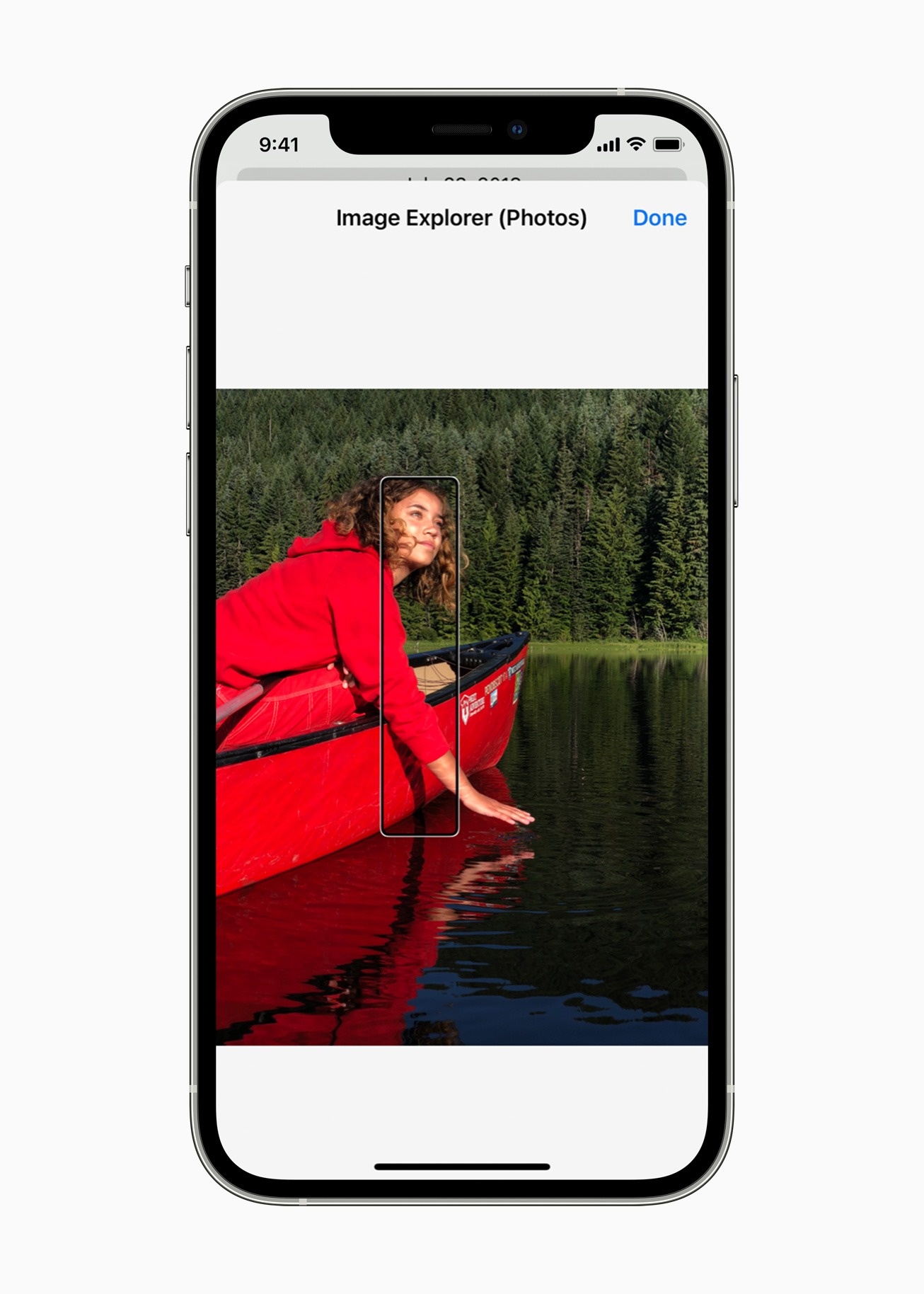

Amélioration de VoiceOver et prise en charge des audiogrammes

Apple rafraîchit son lecteur d’écran VoiceOver avec de plus grandes capacités. Cela inclut davantage de détails sur les personnes, le texte, les données de tableau et d’autres objets dans les images. Les utilisateurs peuvent naviguer dans les images par ligne et par colonne comme dans un tableau, et la fonctionnalité décrira même la position d’une personne par rapport à d’autres objets dans l’image.

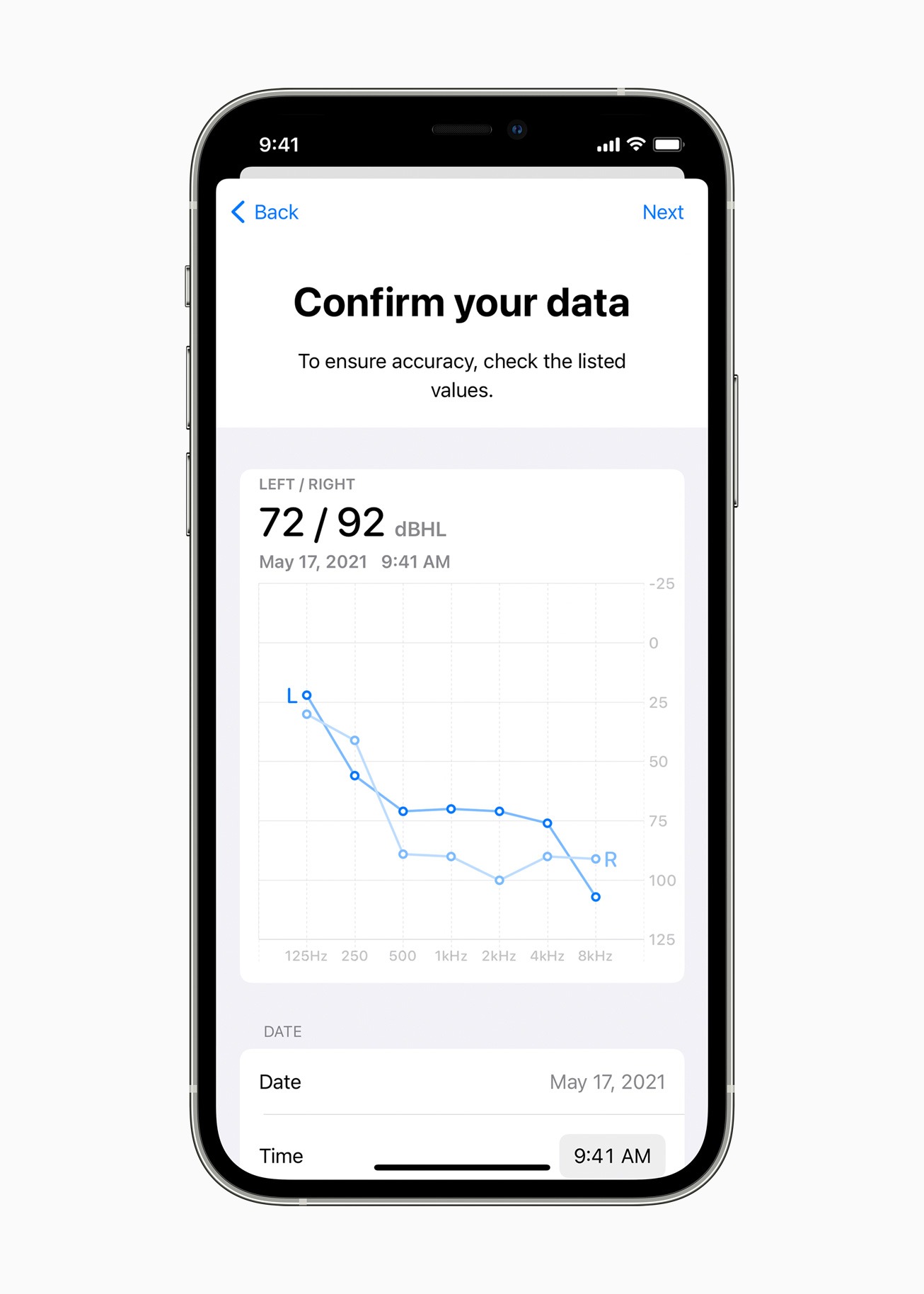

Le géant de Cupertino apporte également un support pour la reconnaissance des audiogrammes dans la fonction Adaptation des écouteurs. Apple indique que les utilisateurs peuvent importer des audiogrammes papier ou PDF pour afficher les résultats de leurs derniers tests auditifs.

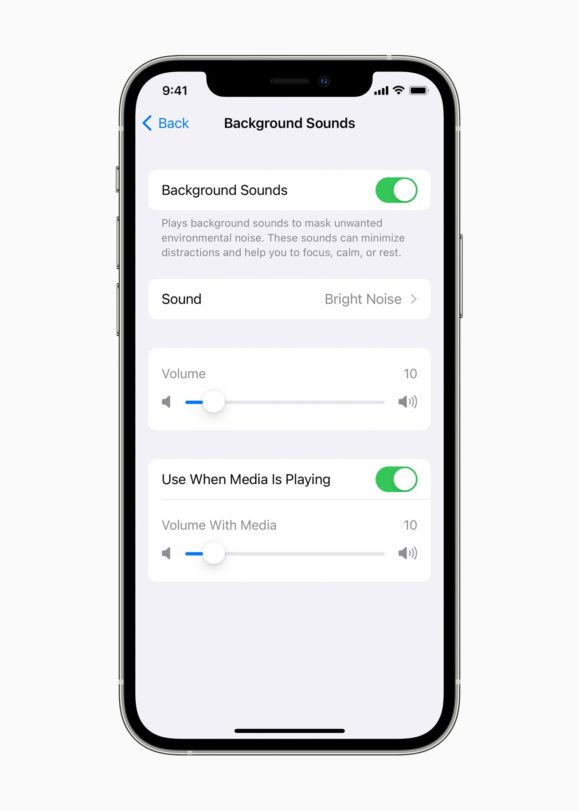

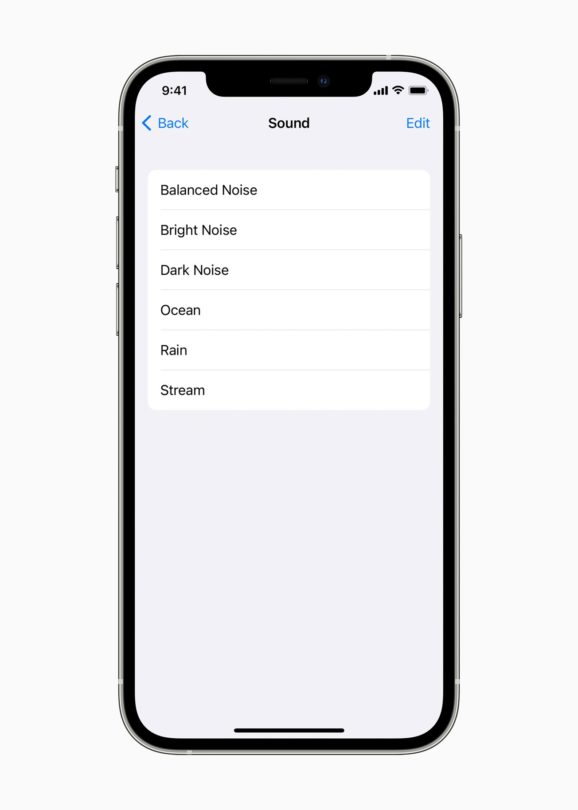

Parmi les autres fonctionnalités à venir sur les appareils Apple, citons de nouveaux sons d’arrière-plan, des actions sonores pour le contrôle de sélection, des réglages de la taille de l’affichage et du texte, ainsi que des personnalisations Memoji inclusives pour les utilisateurs ayant des dispositifs d’assistance respiratoire, des implants cochléaires et un casque de protection.