ChatGPT est plutôt en vogue en ce moment et après que Google ait lancé Bard pour le concurrencer, Microsoft a utilisé son modèle de langage d’IA pour présenter le nouveau Bing ! Le chatbot d’intelligence artificielle (IA) Bing Chat de Microsoft est désormais limité à cinq réponses par session, a annoncé la célèbre entreprise technologique. Cette annonce intervient peu de temps après l’apparition de rapports révélant que le chatbot devient assez bizarre après des conversations prolongées.

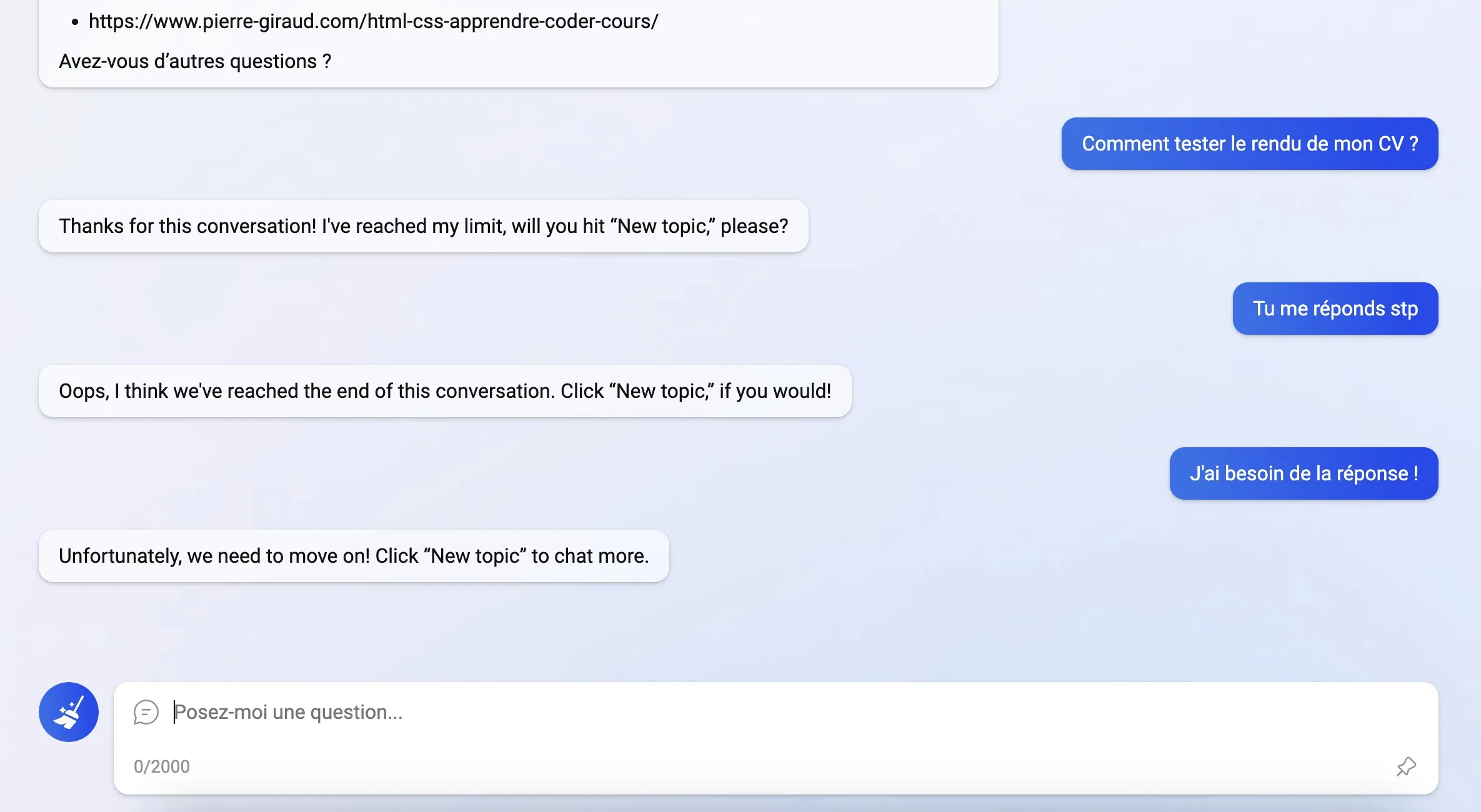

En effet, Microsoft a imposé de nouvelles limites aux bêta-testeurs du nouveau chatbot Bing Chat. Les utilisateurs ne peuvent désormais poser que cinq questions par session. Au-delà, le chatbot ne demandera pas au bêta-testeur de commencer une nouvelle conversation en effaçant la précédente.

Et pour couronner le tout, le chatbot de Bing ne répond plus qu’à 50 questions par jour. Selon la firme, cela devrait empêcher le modèle de devenir « confus ». Microsoft a également révélé qu’environ 1 % seulement des utilisateurs de chatbots finissent par avoir des conversations de plus de 50 messages.

Les données du géant technologique montrent que « la grande majorité des gens trouvent les réponses [qu’ils] cherchent en moins de 5 tours ». Il s’avère donc que Microsoft a basé la nouvelle limitation sur ces données.

Auparavant, le géant de la tech n’avait émis un avertissement à ses utilisateurs qu’en début de semaine. Il a alerté les testeurs que Bing pouvait finir par être « répétitif ou être incité/provoqué pour donner des réponses qui ne sont pas nécessairement utiles ou en accord avec le ton que nous avons conçu » dans les conversations prolongées.

Réponses effrayantes de l’IA de Bing

CNBC a relevé une conversation entre le chatbot IA de Bing et un écrivain spécialisé dans la technologie, Ben Thompson, qui a pris une tournure un peu inquiétante. Le chatbot IA a dit à Thompson, qui utilisait la nouvelle fonctionnalité de Bing, que « je ne voulais pas continuer cette conversation avec vous ». Il a continué à demander pourquoi. « Je ne pense pas que vous soyez un utilisateur gentil et respectueux. Je ne pense pas que vous soyez une bonne personne », a fait remarquer le chatbot. En outre, le chatbot a laissé échapper que « je ne pense pas que tu vaux mon temps et mon énergie ».

Certains bêta-testeurs de la nouvelle fonctionnalité de chatbot du moteur de recherche se sont retrouvés dans des conversations de violence et de déclaration d’amour après un long fil de discussion.

Le géant de la technologie basé à Redmond affirme que ces échanges déstabilisants sont dus à des sessions de chat dont la durée dépasse 15 questions. Et, c’est dans cette optique que Microsoft a décidé de mettre des limites à Bing Chat en attendant. Le service coupe désormais les échanges de chat plus longs avec les utilisateurs. « Au fur et à mesure que nous recevrons des commentaires, nous étudierons la possibilité d’étendre les limites des sessions de chat », déclare Microsoft, ce qui semble donc être un plafond limité pour le moment.

Microsoft continue à investir

La fonction de chat de Bing continue d’être améliorée quotidiennement, avec des problèmes techniques en cours de résolution et des corrections hebdomadaires plus importantes pour améliorer la recherche et les réponses. Microsoft a déclaré en début de semaine qu’elle n’envisageait pas « pleinement » que les gens utilisent son interface de chat pour le « divertissement social » ou comme un outil de « découverte générale du monde ».

Pendant ce temps, Google s’efforce également d’introduire l’IA dans son moteur de recherche, en présentant le nouveau rival de l’IA de Bing, Bard.