Anthropic, une start-up créée par d’anciens membres de l’équipe d’OpenAI, a lancé un chatbot IA nommé Claude, qu’elle présente comme un concurrent du très populaire ChatGPT. Comme son homologue d’OpenAI, Claude est capable d’exécuter diverses tâches, notamment la recherche de documents, le résumé, la rédaction, le codage et la réponse à des questions sur des sujets spécifiques. Selon Anthropic, Claude présente plusieurs avantages, tels que la réduction de la probabilité de générer des résultats nuisibles, l’amélioration de la convivialité des conversations et la possibilité de l’orienter plus facilement dans une direction particulière.

After working for the past few moths with key partners like @NotionHQ, @Quora, and @DuckDuckGo, we’ve been able to carefully test out our systems in the wild. We are now opening up access to Claude, our AI assistant, to power businesses at scale. pic.twitter.com/m0QFE74LJD

— Anthropic (@AnthropicAI) March 14, 2023

Anthropic n’a pas encore donné de détails sur les prix, mais invite les organisations à demander l’accès à Claude. Un représentant d’Anthropic a déclaré que l’entreprise est confiante dans son infrastructure pour la fourniture de modèles et qu’elle prévoit de répondre à la demande de ses clients. Depuis fin 2020, Claude fait l’objet de tests bêta discrets avec des partenaires de lancement, notamment AssemblyAI, DuckDuckGo, Notion, Quora et Robin AI. Anthropic propose deux versions du chatbot, Claude et un dérivé plus rapide et plus abordable, Claude Instant, via une API.

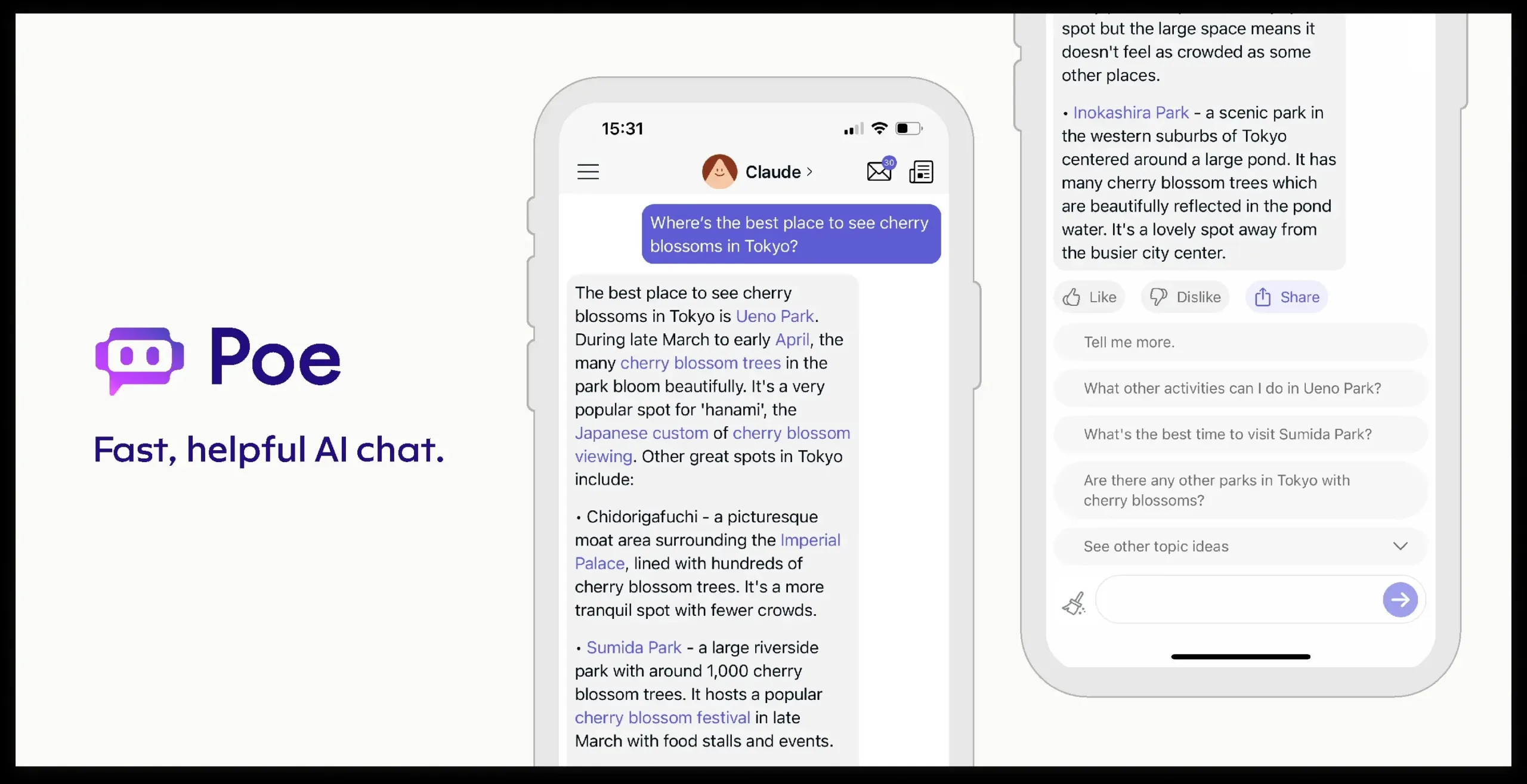

Outre ChatGPT, Claude alimente l’outil DuckAssist récemment lancé par DuckDuckGo, l’application de chat AI de Quora, Poe, et Notion AI, un assistant d’écriture AI intégré à l’espace de travail de Notion. Selon Richard Robinson, PDG de Robin AI, Claude est capable de comprendre le langage, y compris le langage technique comme les termes juridiques, et excelle dans la rédaction, le résumé, la traduction et la simplification de concepts complexes.

Bien qu’il reste à voir comment Claude s’en sort à long terme, Anthropic affirme que son chatbot est moins enclin à générer des résultats nuisibles. L’entreprise explique qu’elle utilise une approche centrée sur l’humain pour la modélisation du langage et qu’elle construit des modèles basés sur la « structure profonde » du langage, plutôt que de générer du texte en se basant uniquement sur des modèles et des associations. Cette approche, ainsi que l’accent mis par Anthropic sur la contrôlabilité, permet à Claude de ne pas générer le type de langage toxique ou biaisé qui a affecté d’autres chatbots dans le passé. En outre, Claude est conçu pour s’abstenir lorsqu’on lui pose des questions sur des sujets qui ne relèvent pas de ses domaines de connaissance, ce qui réduit le risque de générer de fausses informations.

Anthropic affirme que Claude, formé sur des pages Web publiques jusqu’au printemps 2021, est moins enclin à produire des propos sexistes, racistes et toxiques et peut éviter de participer à des activités illégales ou contraires à l’éthique. Mais ce qui distingue Claude, selon Anthropic, c’est l’utilisation d’une technique appelée « IA constitutionnelle ».

Une « IA constitutionnelle »

L’idée de « l’IA constitutionnelle » vise à aligner les systèmes d’IA sur les intentions humaines par le biais d’une approche fondée sur des principes. Cela permet à l’IA, y compris ChatGPT, de répondre à des questions en utilisant un ensemble de principes directeurs. Anthropic a créé Claude en utilisant une liste d’une dizaine de principes qui, une fois combinés, forment une sorte de constitution pour le chatbot IA. Bien que ces principes n’aient pas été rendus publics, Anthropic affirme qu’ils sont fondés sur les concepts de bienfaisance, de non-malfaisance et d’autonomie.

Anthropic a utilisé un système d’IA distinct pour utiliser les principes susmentionnés à des fins d’auto-amélioration, en générant des réponses à un ensemble de questions tout en adhérant à la constitution. Après avoir exploré les réponses possibles à des milliers de questions, l’IA a sélectionné les réponses les plus cohérentes avec la constitution, qu’Anthropic a distillées dans un modèle unique sur lequel Claude a ensuite été formé. Bien qu’Anthropic affirme que Claude offre des avantages tels que la réduction des émissions toxiques, une plus grande contrôlabilité et une conversation plus facile, la startup reconnaît les limites qui sont apparues au cours de la bêta fermée. Selon les rapports, Claude a des difficultés avec les mathématiques, la programmation, et hallucine parfois, fournissant des informations inexactes, telles que des instructions pour produire des substances nocives.

Malgré l’accent mis sur la sécurité et l’IA responsable, Claude n’est pas à l’abri des limitations et des risques. Des messages intelligents peuvent contourner les dispositifs de sécurité intégrés, ce qui est également un problème avec ChatGPT. Dans la version bêta fermée, un utilisateur a réussi à faire en sorte que Claude fournisse des instructions pour fabriquer de la méthamphétamine à la maison. Selon un porte-parole d’Anthropic, trouver le juste équilibre entre utilité et sécurité est un défi, car les modèles d’IA peuvent parfois opter pour le silence afin d’éviter tout risque d’hallucination ou de propos mensongers. Bien qu’Anthropic ait fait des progrès pour réduire l’occurrence de ces problèmes, il reste encore du travail à faire pour améliorer les performances de Claude.

Anthropic prévoit de permettre aux développeurs de personnaliser les principes constitutionnels de Claude en fonction de leurs besoins individuels. L’entreprise se concentre également sur l’acquisition de clients, en mettant l’accent sur les « startups qui font des paris technologiques audacieux » et les grandes entreprises. « Nous ne poursuivons pas pour l’instant d’approche directe du consommateur », a déclaré un porte-parole d’Anthropic.

Un investissement de la part de Google

Anthropic a récemment reçu un investissement de Google, le géant de la technologie s’engageant à verser 300 millions de dollars pour une participation de 10 % dans la startup. L’accord, d’abord rapporté par le Financial Times, comprenait un accord permettant à Anthropic d’utiliser Google Cloud comme son « fournisseur privilégié de services sur le cloud ». Les deux entreprises collaboreront également au développement de systèmes informatiques d’IA. Grâce à cet investissement important, Anthropic est prête à étendre son champ d’action et à poursuivre le développement de ses technologies d’IA.

L’annonce d’Anthropic intervient au milieu d’un flot de nouvelles liées à l’IA, notamment le lancement du tout nouveau modèle GPT-4 d’OpenAI. Google a également annoncé de nouvelles applications d’IA dans Docs, Gmail, Sheets et Slides.