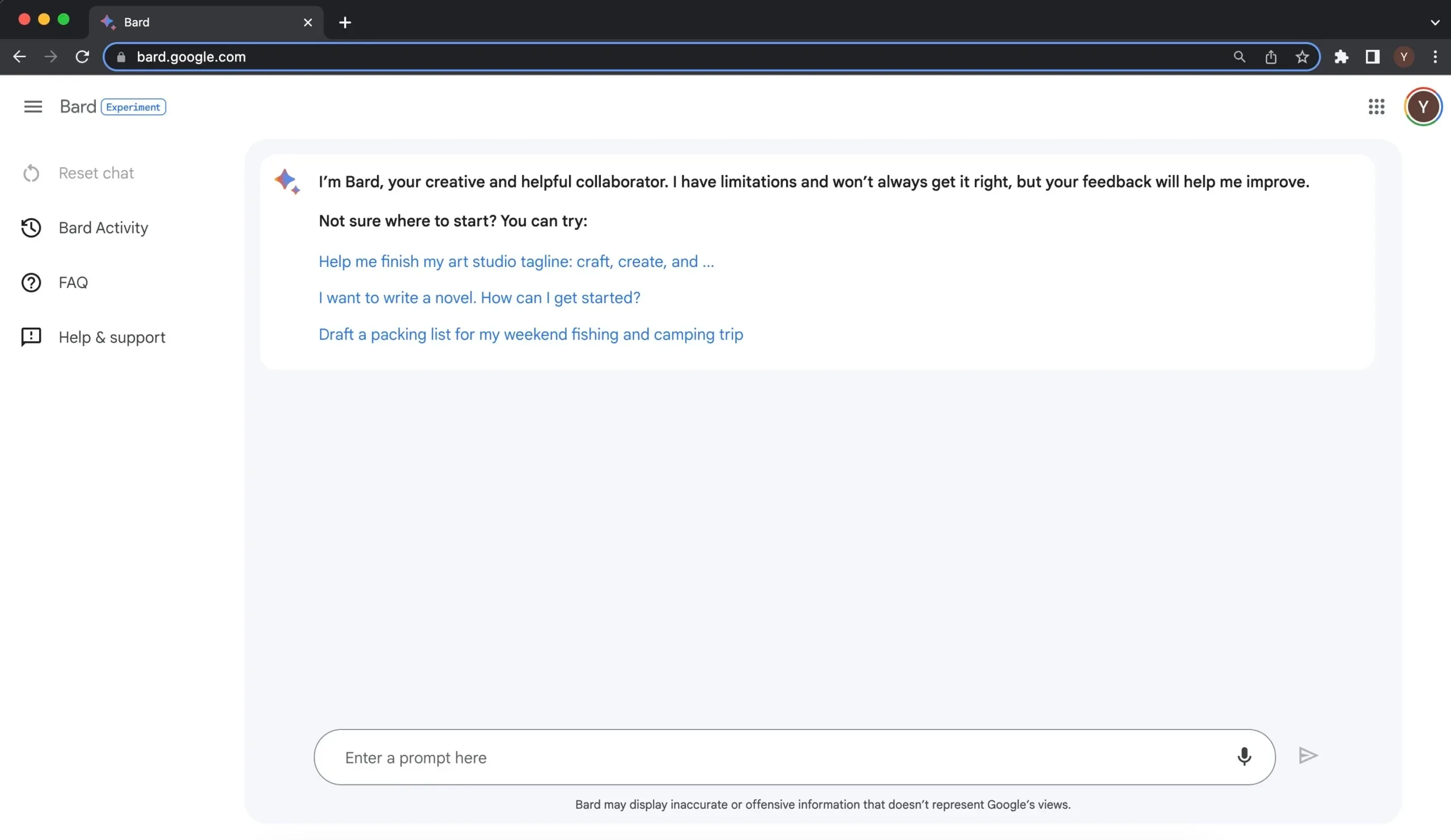

Google a lancé Bard, son rival ChatGPT, en dépit de préoccupations internes selon lesquelles il s’agissait d’un « menteur pathologique » et produisait des résultats « croustillants », selon un nouveau rapport. Les employés affirment que ces inquiétudes ont apparemment été ignorées dans une tentative frénétique de rattraper ChatGPT et d’écarter la menace qu’il pourrait représenter pour les activités de recherche de Google.

Ces révélations proviennent d’un rapport de Bloomberg qui s’est plongé dans Google Bard et dans les questions soulevées par les employés qui ont travaillé sur le projet. Il s’agit d’un compte rendu révélateur des dérapages apparents du chatbot et des doutes que ces incidents ont suscités chez les employés concernés.

Par exemple, Bloomberg cite un employé anonyme qui a demandé à Bard des instructions sur la manière de faire atterrir un avion, puis a été horrifié de voir que la description de Bard conduirait à un crash. Un autre employé a déclaré que les conseils de Bard en matière de plongée sous-marine « entraîneraient probablement des blessures graves, voire mortelles ».

Ces problèmes ont apparemment été soulevés peu de temps avant le lancement de Bard, mais Google a maintenu la date de mise en service, tant son désir de suivre la voie tracée par ChatGPT était grand. Mais, elle l’a fait en ignorant ses propres engagements éthiques, ce qui a donné lieu non seulement à des conseils dangereux, mais aussi à la potentielle diffusion de fausses informations.

En 2021, Google s’est engagé à doubler son équipe d’employés chargés d’étudier les conséquences éthiques de l’intelligence artificielle (IA) et à investir davantage dans la détermination des dommages potentiels. Pourtant, cette équipe est aujourd’hui « désemparée et démoralisée », affirme le rapport de Bloomberg. Pire encore, les membres de l’équipe ont reçu l’ordre « de ne pas se mettre en travers ou d’essayer de tuer les outils d’IA générative en cours de développement », ce qui remet en question l’engagement de Google en matière d’éthique de l’IA.

Un lancement précipité

On l’a vu à l’œuvre juste avant le lancement de Bard. En février, un employé de Google a envoyé un message à un groupe interne pour dire : « Bard est pire qu’inutile : s’il vous plaît, ne le lancez pas », et des dizaines d’autres employés ont abondé dans le même sens. Le mois suivant, Jen Gennai, responsable de la gouvernance de l’IA chez Google, a annulé une évaluation des risques selon laquelle Bard pouvait causer des dommages et n’était pas prêt à être lancé, ce qui a permis de procéder à la première diffusion publique du chatbot.

Le rapport de Bloomberg dresse le portrait d’une entreprise méfiante à l’égard des préoccupations éthiques qui, selon elle, pourraient entraver la rentabilité de ses propres produits. Par exemple, un employé a demandé à travailler sur l’équité dans l’apprentissage automatique, mais il a été découragé à plusieurs reprises, au point que cela a affecté son évaluation des performances. Les responsables se sont plaints que les préoccupations éthiques entravaient leur « vrai travail », a déclaré l’employé.

Il s’agit d’une position préoccupante, d’autant plus que nous avons déjà vu de nombreux exemples d’inconduite de chatbots d’IA qui ont produit des informations offensantes, trompeuses ou carrément fausses. Si le rapport de Bloomberg confirme l’approche apparemment hostile de Google à l’égard des problèmes éthiques, ce n’est peut-être que le début des problèmes causés par l’IA.