OpenAI, un important laboratoire de recherche en intelligence artificielle responsable de la création des modèles d’IA ChatGPT, a suscité des inquiétudes quant à l’état de préparation de la société à des systèmes d’IA avancés, tels que l’hypothétique ChatGPT-5. La déclaration, faite par un employé d’OpenAI, suggère que l’organisation a l’intention de ne pas partager largement certaines technologies d’IA, dans l’espoir de susciter une réponse sociale pour se préparer à des systèmes plus avancés.

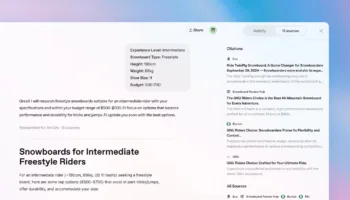

Au cours des 18 derniers mois, l’intelligence artificielle (IA) a repoussé les limites de ce que les ordinateurs peuvent faire. OpenAI, l’entreprise responsable de l’explosion des applications d’IA grâce à la sortie de ChatGPT 3 l’année dernière, a récemment pris une mesure qui a suscité un vif débat sur la manière dont la société devrait gérer les progrès rapides des technologies d’IA.

Elle a suggéré de ralentir la diffusion de certaines capacités d’IA, telles que celles que l’on pourrait trouver dans une future version de ses modèles d’IA, afin de permettre à la société de rattraper son retard et de se préparer à ce qui se profile à l’horizon.

Cette approche prudente a divisé l’opinion publique. D’un côté, il y a l’enthousiasme suscité par le potentiel de l’IA à transformer nos vies, comme le montre le dernier modèle de conversion de texte en vidéo d’OpenAI. D’un autre côté, il y a un sentiment d’inquiétude. Pour les employés, les progrès de l’IA soulèvent d’importantes questions sur la sécurité de l’emploi et les implications éthiques de la prise en charge par les machines de rôles traditionnellement occupés par des humains.

L’émergence de contenus générés par l’IA pose également des dilemmes moraux auxquels la société doit faire face. Ces préoccupations ne sont pas seulement hypothétiques ; il s’agit de questions urgentes qui doivent être abordées à mesure que l’IA continue d’évoluer.

ChatGPT-5 sommes-nous prêts ?

Les progrès réalisés par OpenAI à huis clos font l’objet de nombreuses spéculations. Étant donné les améliorations constantes enregistrées, certains pensent que l’organisation est sur le point de réaliser une percée majeure, peut-être dans le domaine de l’intelligence artificielle générale (AGI). Toutefois, les communications de OpenAI ont été quelque peu ambiguës, ce qui laisse place à l’interprétation et alimente les spéculations sur ses capacités.

Le développement rapide des technologies de l’IA et le lancement imminent du ChatGPT-5 ont conduit certains experts à suggérer qu’une diffusion progressive de modèles d’IA mis à jour pourrait être la meilleure façon d’intégrer ces systèmes dans la société. Cette approche pourrait atténuer le choc provoqué par l’introduction simultanée de modèles entièrement nouveaux et avancés. Malgré les potentiels avantages de l’IA, l’opinion publique est souvent sceptique ou carrément négative. En témoignent les réactions hostiles aux véhicules autonomes sur les réseaux sociaux, ainsi que les appels à des réglementations strictes, voire à l’interdiction pure et simple de l’IA.

L’impact sociétal de l’IA est une question complexe qui va au-delà de la technologie. Certains craignent que l’IA n’aggrave les troubles sociaux et n’accroisse les inégalités. Ces préoccupations ont incité les décideurs politiques à prendre des mesures proactives pour veiller à ce que les avantages de l’IA soient répartis de manière juste et équitable.

Une autre préoccupation pressante est la possibilité d’une « course vers le bas » de l’IA. Selon ce scénario, les entreprises rivalisent pour mettre sur le marché de puissants modèles d’IA sans se demander si la société est prête à les accueillir. Une telle précipitation pourrait conduire à des systèmes d’IA qui dépassent les cadres éthiques et réglementaires nécessaires pour les gérer de manière sûre et responsable.

Inquiétudes liées à la diffusion de GPT-5

L’intégration de technologies d’IA avancées dans divers secteurs peut conduire à une efficacité accrue et à des économies pour les entreprises, mais elle pose également un risque important de déplacement d’emplois. À mesure que les systèmes d’IA tels que GPT-5 deviennent capables d’effectuer des tâches allant du service à la clientèle à la création de contenu et même à l’analyse technique, les rôles traditionnellement occupés par des humains dans ces domaines peuvent être réduits ou éliminés.

Cette évolution peut avoir des répercussions économiques et sociales considérables, notamment une augmentation du taux de chômage, une réduction des dépenses de consommation et une aggravation des inégalités économiques. Le tissu social pourrait être mis à rude épreuve, car les communautés qui dépendent des industries les plus touchées par l’IA sont confrontées à des ralentissements économiques, ce qui pourrait entraîner des troubles sociaux et des difficultés de réintégration de la main-d’œuvre.

Implications éthiques et morales

La capacité de l’IA à générer des contenus réalistes pose d’importants problèmes éthiques. Par exemple, la création de « deepfakes » peut compromettre l’authenticité des informations, en rendant difficile la distinction entre un contenu réel et un contenu artificiel.

Cette capacité pourrait être utilisée à mauvais escient pour diffuser des informations erronées, manipuler des élections ou mener des activités frauduleuses, ce qui constituerait une menace pour la démocratie, la vie privée et la confiance du public. Le dilemme éthique s’étend à la responsabilité des développeurs et des plateformes dans la prévention des abus tout en garantissant la liberté d’expression et d’innovation.

Sécurité et contrôle

À mesure que les systèmes d’IA deviennent plus complexes, il devient de plus en plus difficile de garantir leur alignement sur les valeurs humaines et les principes éthiques. Il existe un risque que l’IA développe des comportements nuisibles ou involontaires non prévus par ses créateurs, potentiellement en raison de la complexité de ses processus de prise de décision ou des propriétés émergentes de ses algorithmes d’apprentissage.

Cela soulève des inquiétudes quant aux mesures de sécurité mises en place pour prévenir de tels résultats et à la capacité de contrôler ou de corriger les systèmes d’IA une fois qu’ils sont opérationnels.

Progrès technologique et état de préparation de la société

Le rythme auquel les technologies de l’IA progressent pourrait dépasser la capacité de la société à comprendre, réguler et intégrer ces systèmes de manière efficace. Ce décalage peut entraîner des perturbations, car les cadres juridiques, éthiques et réglementaires existants risquent d’être inadaptés pour relever les défis posés par l’IA avancée.

L’introduction rapide des technologies d’IA pourrait entraîner des problèmes sociétaux, notamment des violations de la vie privée, des dilemmes éthiques et la nécessité de nouvelles lois et réglementations, qu’il pourrait être difficile d’élaborer et de mettre en œuvre en temps voulu.

Transparence et responsabilité

Le développement de systèmes d’IA tels que GPT-5 implique des décisions qui peuvent avoir de vastes implications. La transparence des processus utilisés pour former ces modèles, les sources de données et les critères de prise de décision suscitent des inquiétudes. La responsabilité des organisations qui développent des technologies d’IA est cruciale, en particulier dans les cas où les actions de l’IA conduisent à des préjudices ou à des préjugés.

Il est essentiel de veiller à ce que ces systèmes soient développés et déployés de manière transparente, avec des lignes de responsabilité claires, afin de maintenir la confiance du public et de garantir une utilisation éthique.

Une course vers le bas

La nature concurrentielle de l’industrie de l’IA pourrait pousser les entreprises à donner la priorité au progrès technologique plutôt qu’à la sécurité, à l’éthique et à l’impact sociétal, ce qui conduirait à une « course vers le bas ». Cette concurrence peut entraîner la mise sur le marché de technologies d’IA puissantes sans garanties suffisantes, sans surveillance ni prise en compte des effets à long terme, ce qui accroît le risque de conséquences négatives. La pression exercée pour rester en tête peut compromettre l’engagement en faveur de normes éthiques et d’une innovation responsable.

IA et inégalités

Les technologies avancées d’IA peuvent profiter de manière significative à ceux qui y ont accès, ce qui risque d’exacerber les inégalités existantes. La « fracture numérique » entre les individus et les pays qui ont accès à l’IA avancée et ceux qui n’y ont pas accès pourrait se creuser, entraînant des disparités en matière d’opportunités économiques, d’éducation, de soins de santé, etc. Cette fracture n’affecte pas seulement la prospérité individuelle et nationale, mais soulève également des questions éthiques sur la répartition équitable des avantages de l’IA et la gestion mondiale de ses impacts.

Pour répondre à ces préoccupations, les gouvernements, l’industrie, le monde universitaire et la société civile doivent coordonner leurs efforts afin d’élaborer des stratégies globales comprenant des lignes directrices éthiques, des cadres réglementaires solides, l’engagement du public et la coopération internationale. Il est essentiel de veiller à ce que le développement de l’IA soit guidé par des principes d’équité, de sécurité et de transparence afin d’exploiter ses avantages potentiels tout en atténuant les risques et les incidences négatives.

Les récentes déclarations de OpenAI ont mis en lumière les défis multiples posés par l’évolution rapide de l’IA.