Après presque 9 mois, Meta a introduit une nouvelle famille de modèles Llama 3. Et ils sont open source, comme auparavant, sous l’accord de licence communautaire de Meta. Actuellement, Meta a annoncé des modèles Llama 3 en deux tailles : Llama 3 avec des paramètres de 8B et Llama 3 avec des paramètres de 70B.

Ces modèles, dotés respectivement de 8 milliards et 70 milliards de paramètres, marquent une avancée significative par rapport aux précédentes versions, Llama 2 8B et Llama 2 70B. Les performances accrues des nouveaux modèles sont attribuées à leur entraînement sur deux clusters GPU personnalisés de 24 000 unités.

Meta est également en train de former son plus grand modèle multimodal avec 400 milliards de paramètres, qui sera disponible dans un proche avenir. Cependant, nous ne savons pas si Meta choisira de mettre en open source son plus grand modèle lorsqu’il le rendra public.

Un déploiement de Meta AI basé sur Llama 3 en cours

Dès à présent, Meta intègre ses modèles Llama 3 dans toutes ses applications de réseaux sociaux, y compris Facebook, Instagram, WhatsApp, Messenger, et sur le Web également. Oui, tout comme ChatGPT, vous pouvez maintenant discuter gratuitement avec des modèles de lama 3 via meta.ai. Et sur les apps, vous pouvez trouver Meta AI à l’œuvre dans votre flux, vos chats et vos recherches.

Vous pouvez utiliser Meta AI pour générer des images et des GIF instantanés, trouver des informations actuelles sur n’importe quel sujet (en utilisant à la fois Google et Bing), poser des questions à partir de votre flux, et bien plus encore.

Meta déploie des expériences d’IA dans ses applications de réseaux sociaux et lance le portail Web en anglais dans plusieurs régions : Afrique du Sud, Australie, Canada, Ghana, Jamaïque, Malawi, Nigéria, Nouvelle-Zélande, Ouganda, Pakistan, Singapour, Zambie et Zimbabwe. L’entreprise précise que d’autres pays seront ajoutés dans les prochains jours.

Meilleur que la concurrence selon Meta

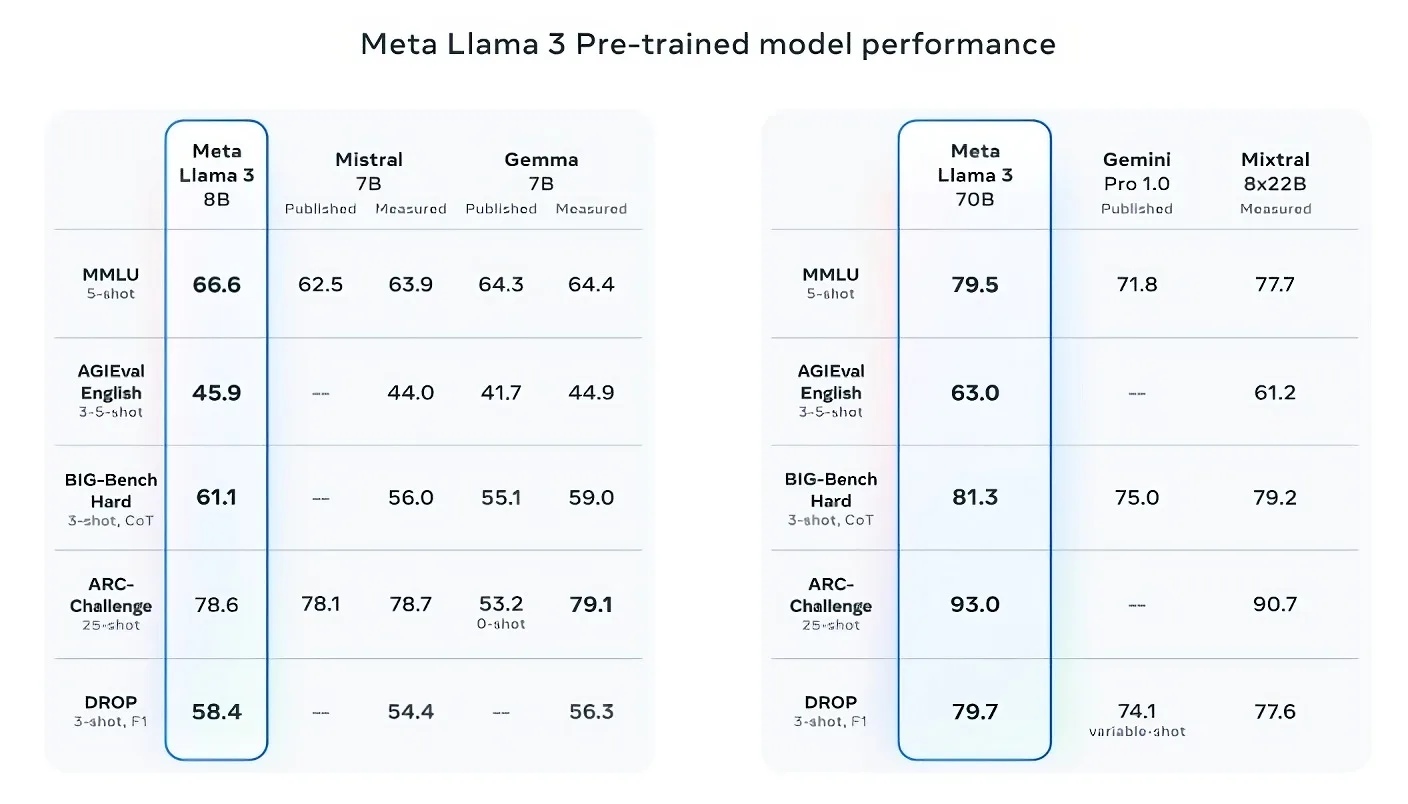

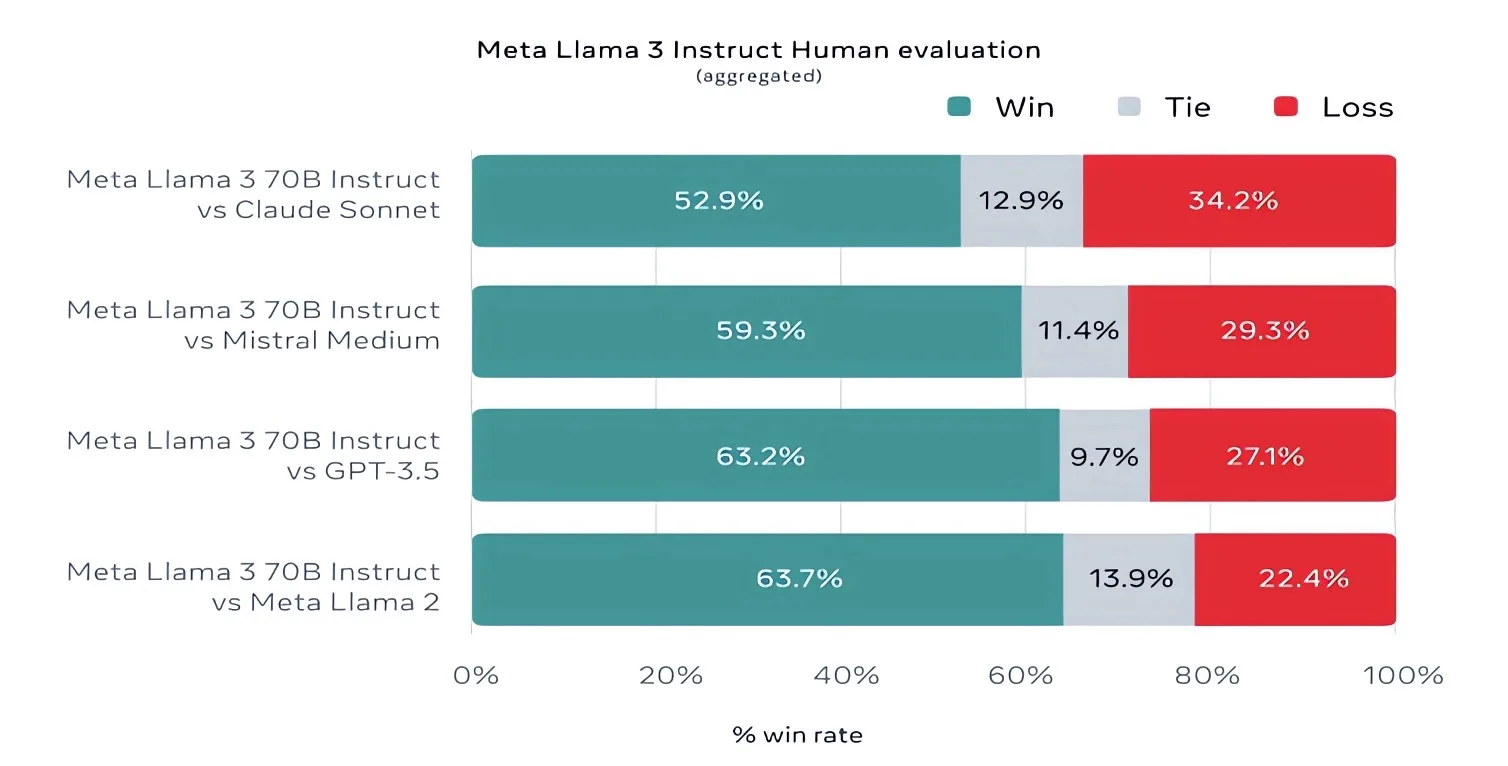

En ce qui concerne les modèles de Llama 3, Meta affirme que son modèle 8B est meilleur que les modèles Gemma 7B et Mistral 7B de Google. Quant au modèle Llama 3 70B, il dépasse de peu le Gemini 1.5 Pro et obtient également de meilleurs résultats que le Claude 3 Sonnet dans le test de benchmark MMLU.

Outre les benchmarks, Meta a également développé son propre ensemble de tests pour évaluer les performances des Llama 3 dans des domaines variés allant de la programmation à la rédaction créative. Malgré le développement interne de ces tests, Meta assure avoir maintenu l’objectivité en isolant les équipes de modélisation.

En termes de contenu, les Llama 3 bénéficient d’un ensemble de données nettement plus vaste, 7x plus grand que celui utilisé pour les Llama 2, et intégrant une proportion significative de données non anglophones pour améliorer la performance dans diverses langues. Cependant, ce choix pourrait susciter des controverses, notamment en raison de l’utilisation présumée de données protégées par le droit d’auteur dans des formations précédentes.

Meta a également pris des mesures pour améliorer la gestion des problèmes de biais et de toxicité souvent associés aux modèles d’IA générative, en développant de nouvelles méthodes de filtrage des données et en mettant à jour ses outils de sécurité IA, tels que Llama Guard et CybersecEval.

Certaines restrictions imposées à Llama 3

Enfin, bien que les modèles Llama 3 soient décrits comme « ouverts », Meta impose certaines restrictions, notamment l’interdiction d’utiliser ces modèles pour entraîner d’autres modèles génératifs et des exigences de licence spéciales pour les développeurs d’applications à grand échelle.

Évidemment, il faudra tester ces modèles de manière approfondie pour évaluer sa position par rapport aux modèles concurrents. Mais pour l’instant, il semble que Meta ait lancé des modèles performants avec la famille Llama 3.