Hier soir, lors de son événement Spring Updates, Mira Murati, Chief Technology Officer de OpenAI, a annoncé un nouveau Large Language Model (LLM) multimodal, GPT-4o (abréviation de GPT-4 Omni), qui sera mis à la disposition de tous les utilisateurs gratuits de ChatGPT dans les semaines à venir, ainsi qu’une application de bureau ChatGPT pour macOS (plus tard pour Windows) qui permettra aux utilisateurs d’accéder à d’autres applications que le Web et les applications mobiles.

« GPT-4o raisonne sur la voix, le texte et la vision », a déclaré Murati. Cela inclut l’acceptation et l’analyse de vidéos en temps réel capturées par les utilisateurs sur leurs applications smartphone ChatGPT, bien que cette capacité ne soit pas encore accessible au public.

« Cela semble tellement magique, et c’est merveilleux, mais nous voulons éliminer une partie du mysticisme et vous permettre de l’essayer par vous-même », a ajouté le directeur technique d’OpenAI.

Le nouveau modèle réagit en temps réel, même en cas d’audio, détecte les émotions et peut adapter sa voix pour transmettre différentes émotions, à l’instar de la startup d’IA rivale Hume.

Lors d’une démonstration, un présentateur a demandé à ChatGPT sur son téléphone, alimenté par GPT-4o, de raconter une histoire avec une voix de plus en plus dramatique et théâtrale, ce qu’il a fait correctement et rapidement.

OpenAI a publié des vidéos de démonstration et des exemples des capacités de GPT-4o sur son site Web : « Il peut répondre à des entrées audio en seulement 232 millisecondes, avec une moyenne de 320 millisecondes, ce qui est similaire au temps de réponse d’un être humain dans une conversation ».

GPT-4o diffère de ses précédents modèles

L’entreprise a expliqué en quoi le GPT-4o diffère de ses précédents modèles et comment il permet de nouvelles expériences :

Avant le GPT-4o, vous pouviez utiliser le mode vocal pour parler à ChatGPT avec des temps de latence de 2,8 secondes (GPT-3.5) et de 5,4 secondes (GPT-4) en moyenne. Pour ce faire, le mode vocal est un pipeline composé de trois modèles distincts : un modèle simple transcrit l’audio en texte, GPT-3.5 ou GPT-4 prend du texte et en produit, et un troisième modèle simple reconvertit le texte en audio. Ce processus signifie que la principale source d’intelligence, GPT-4, perd beaucoup d’informations : elle ne peut pas observer directement le ton, les locuteurs multiples ou les bruits de fond, et elle ne peut pas restituer les rires, les chants ou exprimer des émotions.

Avec GPT-4o, nous avons formé un nouveau modèle unique de bout en bout pour le texte, la vision et l’audio, ce qui signifie que toutes les entrées et sorties sont traitées par le même réseau neuronal. GPT-4o étant notre premier modèle combinant toutes ces modalités, nous n’en sommes encore qu’au stade de l’exploration des possibilités du modèle et de ses limites.

Il peut même être utilisé pour générer des vues multiples d’une seule image qui peuvent, à leur tour, être transformées en objets 3D :

variable binding is pretty much solved

“An image depicting three cubes stacked on a table. The top cube is red and has a G on it. The middle cube is blue and has a P on it. The bottom cube is green and has a T on it. The cubes are stacked on top of each other. pic.twitter.com/T0LsNIZ9P2—will depue (@willdepue) May 13, 2024

Cependant, OpenAI n’a pas déclaré qu’elle ouvrirait GPT-4o ni aucun de ses modèles d’IA plus récents — ce qui signifie que, bien que les utilisateurs puissent essayer le nouveau modèle de base et ses capacités sur le site Web d’OpenAI et par le biais de ses applications et de son API, ils n’auront pas un accès complet aux poids sous-jacents pour personnaliser le modèle à leur guise, ce que les critiques, y compris le cofondateur devenu rival Elon Musk, ont souligné comme un exemple de l’éloignement d’OpenAI de sa mission fondamentale.

Un nouveau modèle apporte plus de puissance et de capacités aux utilisateurs gratuits de ChatGPT

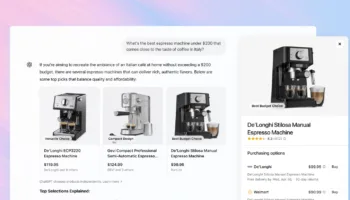

Les fonctionnalités offertes par GPT-4o représentent une amélioration significative de l’expérience actuelle pour les utilisateurs gratuits de ChatGPT, qui étaient jusqu’à présent bloqués sur le modèle GPT-3.5 uniquement textuel, sans les puissantes capacités de GPT-4 pour analyser les images et les documents téléchargés par les utilisateurs.

Désormais, les utilisateurs gratuits de ChatGPT auront accès à un modèle nettement plus intelligent, à la navigation sur le Web, à l’analyse de données et à la création de graphiques, au GPT Store, et même à une mémoire permettant à l’application de stocker les informations que l’utilisateur souhaite sur lui et ses préférences, simplement en les tapant ou en les lui demandant de manière audible.

Lors d’une démonstration, les présentateurs de OpenAI ont montré comment ChatGPT powered by GPT-4o pouvait être utilisé comme une application de traduction en temps réel, écoutant et traduisant automatiquement les mots d’un locuteur de l’italien à l’anglais et vice-versa.

OpenAI has just demonstrated its new GPT-4o model doing real-time translations 🤯 pic.twitter.com/Cl0gp9v3kN

—Tom Warren (@tomwarren) May 13, 2024

Dans un article de blog annonçant GPT-4o, OpenAI a noté que : « ChatGPT prend désormais en charge plus de 50 langues (s’ouvre dans une nouvelle fenêtre) pour l’inscription et la connexion, les paramètres de l’utilisateur, etc ». En outre, OpenAI a écrit : « GPT-4o est bien meilleur que n’importe quel modèle existant pour comprendre et discuter des images que vous partagez ».

En outre, il peut être utilisé pour créer des personnages d’art IA cohérents, ce qui a échappé à la plupart des générateurs d’art IA à ce jour.

GPT-4o serait déployé pour les utilisateurs gratuits

OpenAI a également indiqué que, bien qu’il soit éventuellement disponible pour les utilisateurs gratuits de ChatGPT, GPT-4o serait d’abord déployé pour les abonnés payants :

Nous commençons à déployer GPT-4o pour les utilisateurs de ChatGPT Plus et Team, avec une disponibilité prochaine pour les utilisateurs Enterprise. Nous commençons également à déployer ChatGPT Free avec des limites d’utilisation dès aujourd’hui. Les utilisateurs Plus auront une limite de messages jusqu’à 5 fois supérieure à celle des utilisateurs gratuits, et les utilisateurs Team et Enterprise auront des limites encore plus élevées.

Sur X, le compte de l’entreprise OpenAI a indiqué que si « la saisie de texte et d’images » est déployée aujourd’hui dans l’API d’OpenAI, les capacités vocales et vidéo seront disponibles « dans les semaines à venir ».

Say hello to GPT-4o, our new flagship model which can reason across audio, vision, and text in real time: https://t.co/MYHZB79UqN

Text and image input rolling out today in API and ChatGPT with voice and video in the coming weeks. pic.twitter.com/uuthKZyzYx

—OpenAI (@OpenAI) May 13, 2024

Sur son blog personnel, le PDG et cofondateur d’OpenAI, Sam Altman, a écrit que l’état d’esprit d’OpenAI concernant la construction de l’IA avait changé : « Notre conception initiale, lorsque nous avons lancé OpenAI, était que nous allions créer l’IA et l’utiliser pour créer toutes sortes d’avantages pour le monde. Aujourd’hui, nous pensons plutôt que nous allons créer l’IA et que d’autres personnes l’utiliseront pour créer toutes sortes de choses étonnantes dont nous bénéficierons tous ».

Avant le lancement de GPT-4o aujourd’hui, des rapports contradictoires prédisaient que OpenAI annonçait un moteur de recherche IA pour rivaliser avec Google et Perplexity, un assistant vocal intégré à GPT-4, ou un modèle totalement nouveau et amélioré, GPT-5. Bien entendu, OpenAI a veillé à ce que ce lancement ait lieu juste avant la Google I/O, la conférence phare du géant de la technologie, où nous nous attendons à voir le lancement de divers produits d’IA de l’équipe Gemini.