Le géant de Cupertino a présenté l’Apple Intelligence lors de l’événement WWDC 2024 et a finalement rejoint la course à l’IA en concurrence avec Google, OpenAI et Microsoft. Pour offrir de nouvelles fonctionnalités et expériences d’IA sur iOS 18 et macOS Sequoia, Apple a développé ses propres modèles d’IA de base, à la fois pour le traitement sur l’appareil et dans le cloud.

Alors que le modèle d’Apple sur l’appareil est de petite taille (formé sur 3 milliards de paramètres), les grands modèles de classe serveur sont hébergés sur le Private Cloud Compute d’Apple. Pour la plupart des tâches, le modèle sur l’appareil fait un excellent travail, mais pour les tâches complexes, la demande est déchargée sur les grands modèles de serveur d’Apple. En outre, Apple a intégré ChatGPT sur l’iPhone, l’iPad et le Mac.

Pour la première fois, Apple a développé son propre modèle LLM (Large Language model) et on est forcément intéressé par ses performances par rapport aux modèles de pointe d’OpenAI, de Google et de Microsoft.

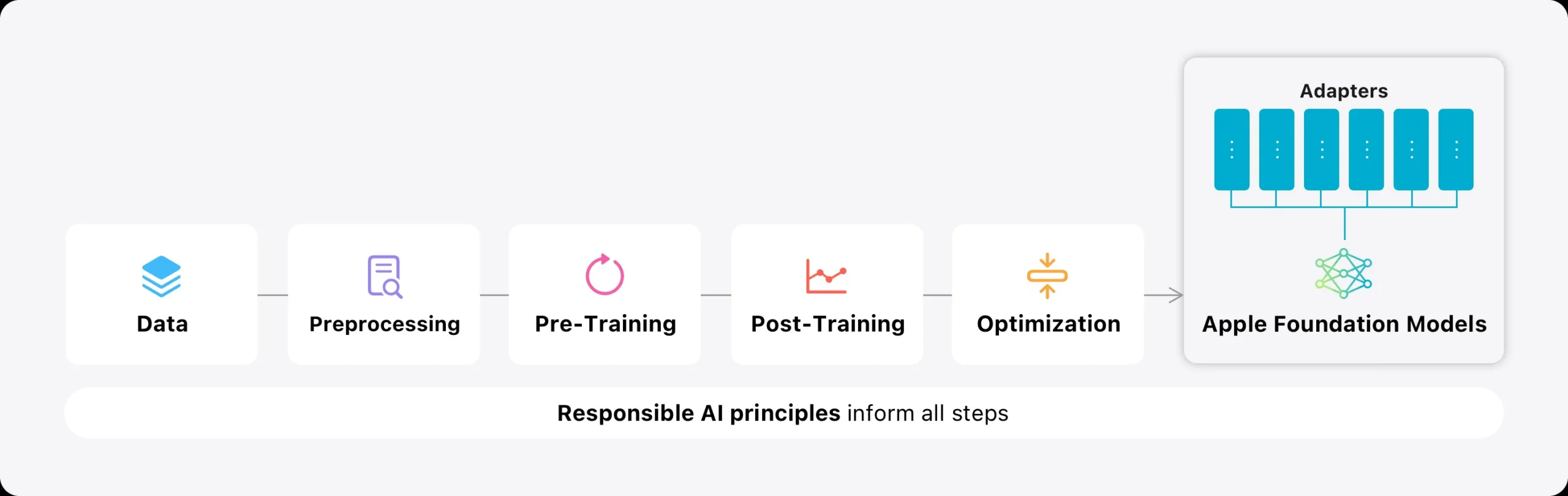

Comment Apple a développé ses modèles d’IA dans le cadre de Apple Intelligence ?

Apple a développé deux types de modèles d’IA : un petit modèle pour le traitement sur l’appareil, entraîné sur 3 milliards de paramètres, et un grand modèle de serveur hébergé sur l’infrastructure cloud d’Apple. L’entreprise n’a pas mentionné la taille des paramètres du modèle de serveur.

Pour le traitement sur l’appareil, Apple utilise des adaptateurs LoRA (Low-Rank Adaptation) pour charger de petits modules pour des tâches spécifiques. Ces adaptateurs permettent d’améliorer la précision et l’efficacité, conformément aux grands modèles non compressés.

Apple affirme avoir entraîné ses modèles d’intelligence artificielle sur des données sous licence ainsi que sur des ensembles de données spécifiques à un domaine afin d’améliorer les caractéristiques et les performances. En outre, Apple a exploré des données accessibles au public à l’aide de son robot d’exploration du web, AppleBot.

Performances : Modèles d’IA d’Apple sur l’appareil et sur le serveur

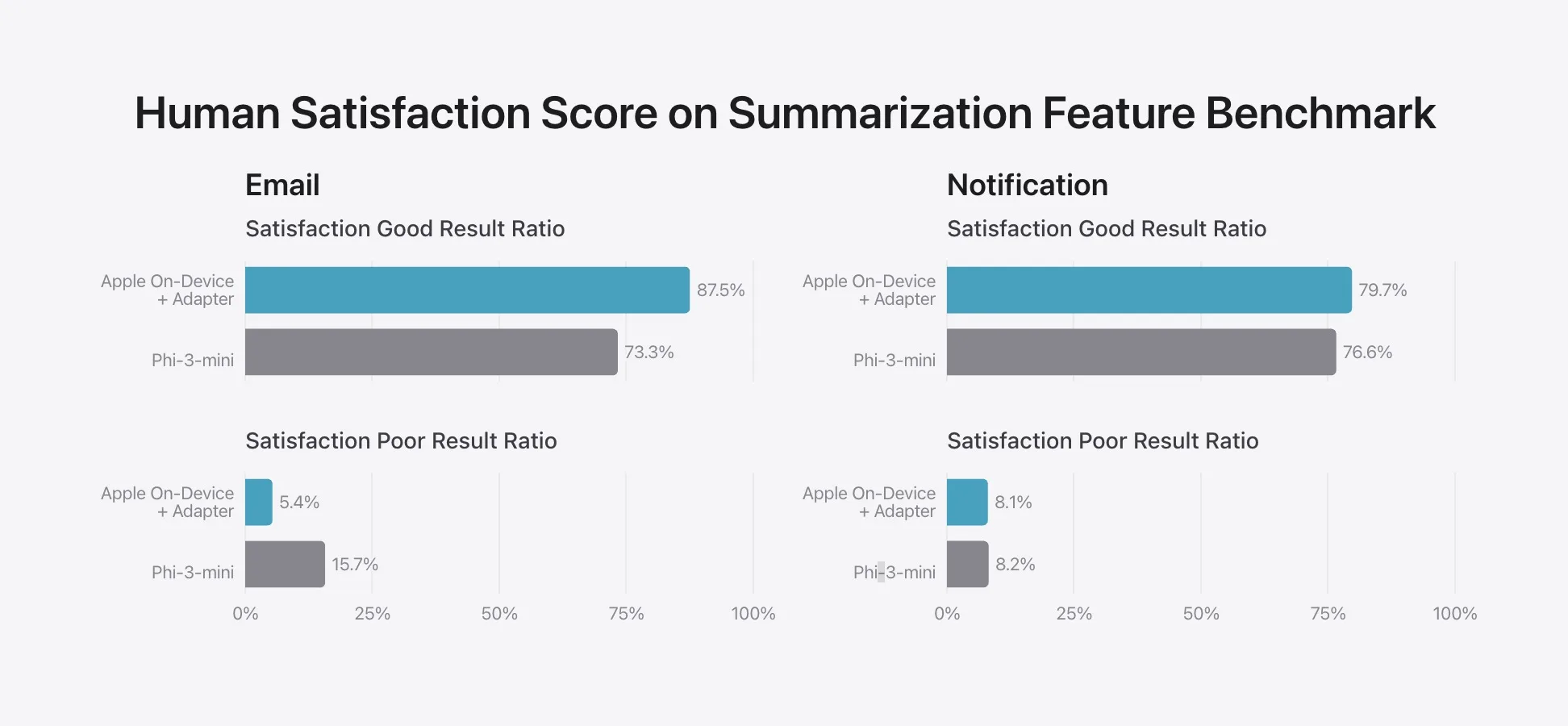

Sur son blog, Apple a comparé son modèle d’IA sur appareil (3B) au dernier modèle Phi-3-mini de Microsoft (3,8B), aux modèles Gemma-1.1-2B et 1.1-7B de Google, et au modèle 7B de Mistral. Dans les tâches de résumé des e-mails et des notifications, le modèle d’Apple sur l’appareil a obtenu de meilleurs résultats que le modèle Phi-3-mini.

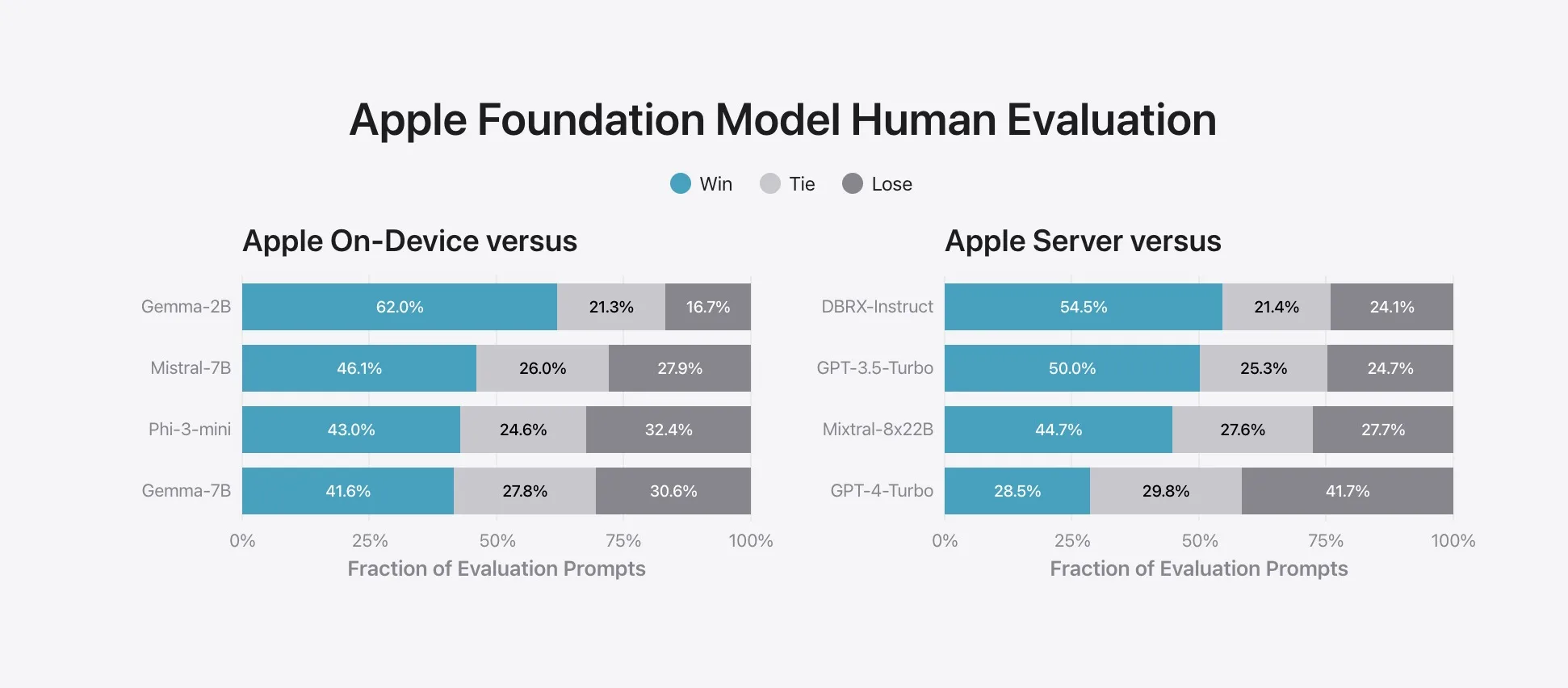

Dans un test d’évaluation noté par des humains, le modèle sur appareil d’Apple a été préféré à Gemma 2B, Mistral 7B, Phi-3-mini et Gemma 7B.

Quant au grand modèle de serveur Apple, il a obtenu de meilleurs résultats que GPT-3.5 Turbo, Mixtral 8x22B et DBRX Instruct. Cependant, il n’a pas pu rivaliser avec GPT-4 Turbo. Cela signifie que le grand modèle de serveur d’Apple rivalise avec le GPT-3.5 Turbo, ce qui est très bien.

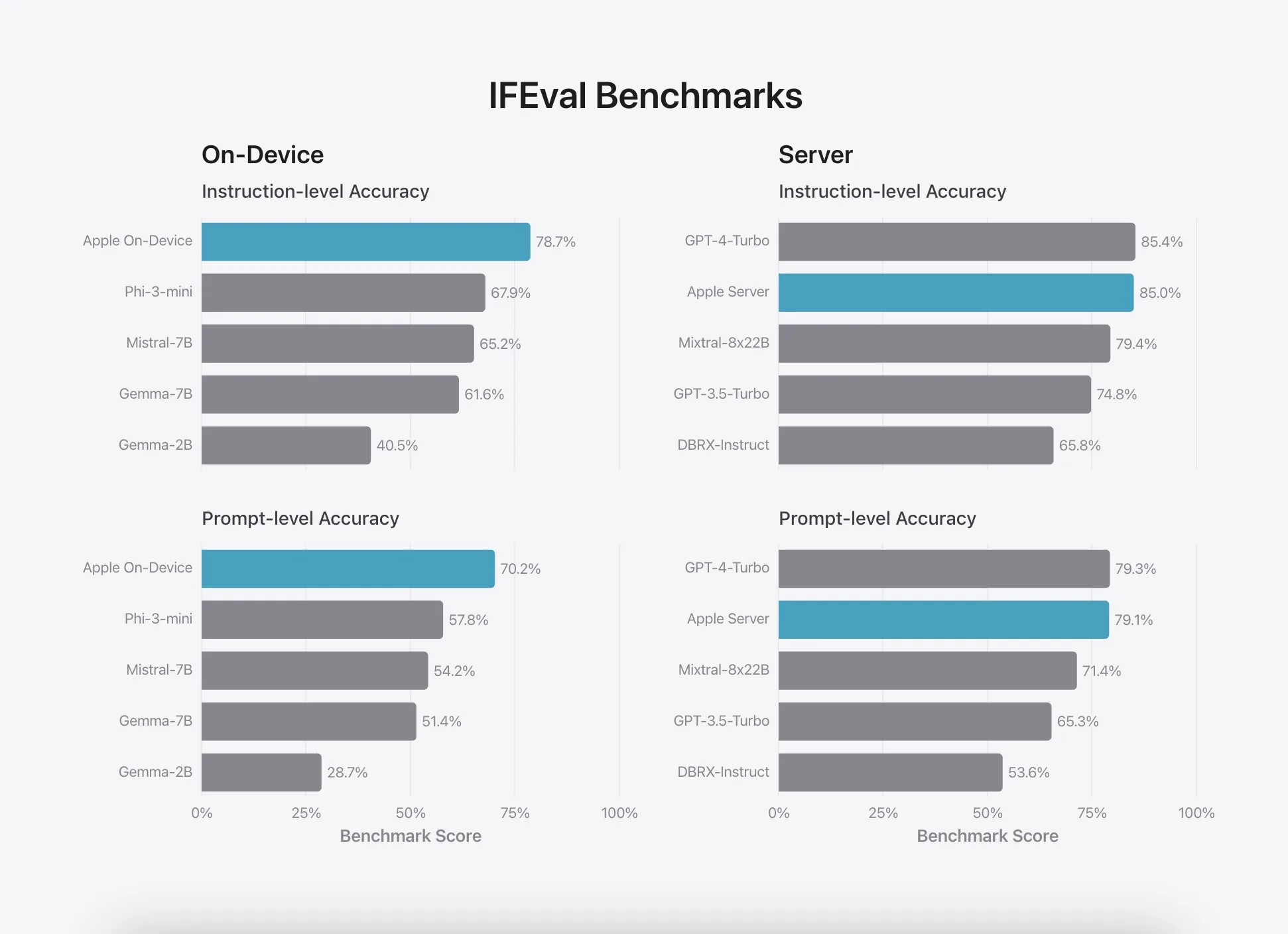

En ce qui concerne les instructions suivantes, le modèle d’Apple sur appareil a de nouveau obtenu d’excellents résultats dans les tests de précision. En ce qui concerne les modèles de serveurs, il est juste derrière GPT-4 Turbo mais fait mieux que Mixtral 8x22B, GPT-3.5 Turbo et DBRX Instruct.

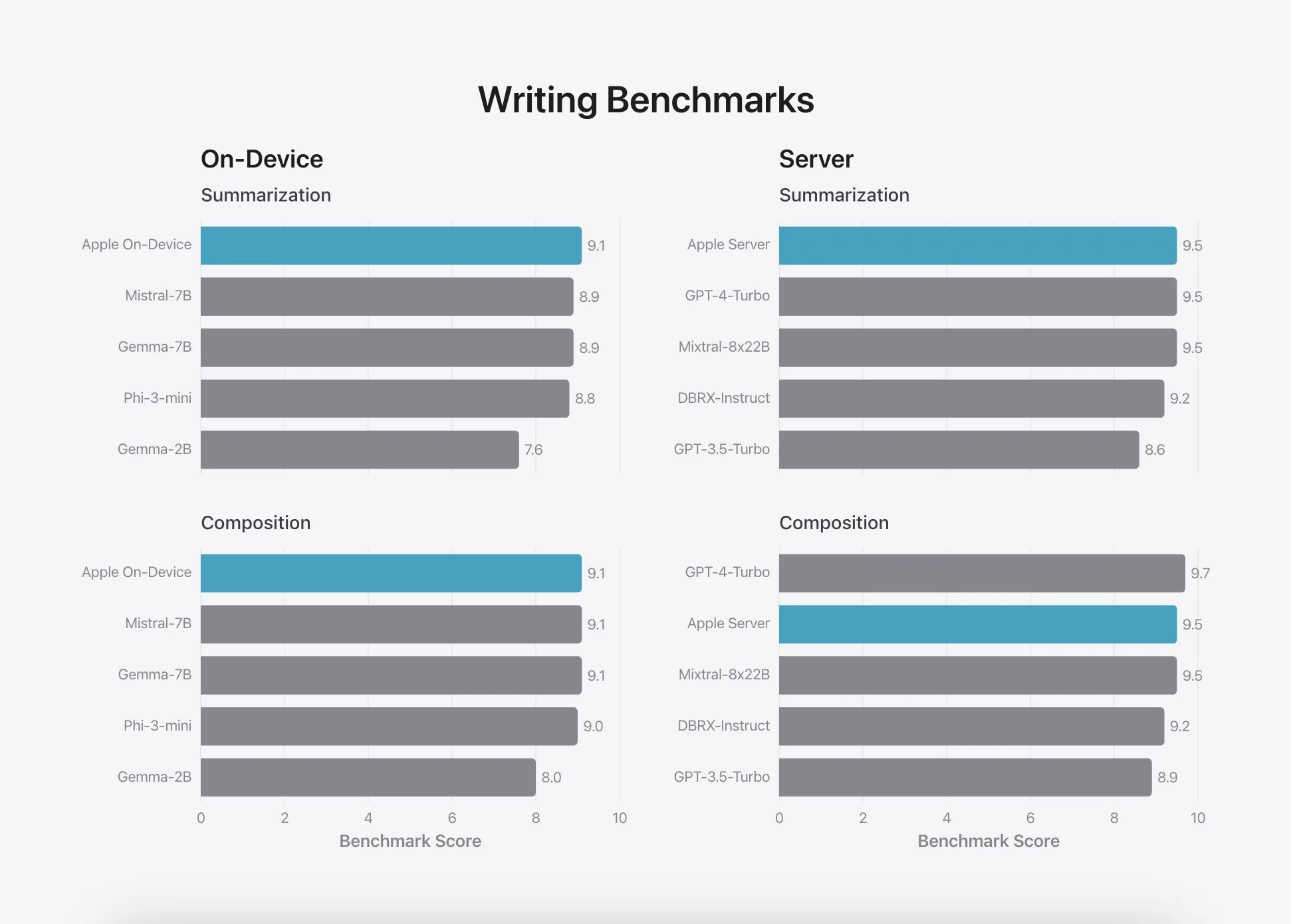

Ensuite, dans les tests d’écriture, les modèles d’Apple sur appareil et sur serveur ont surpassé les modèles d’IA des concurrents.

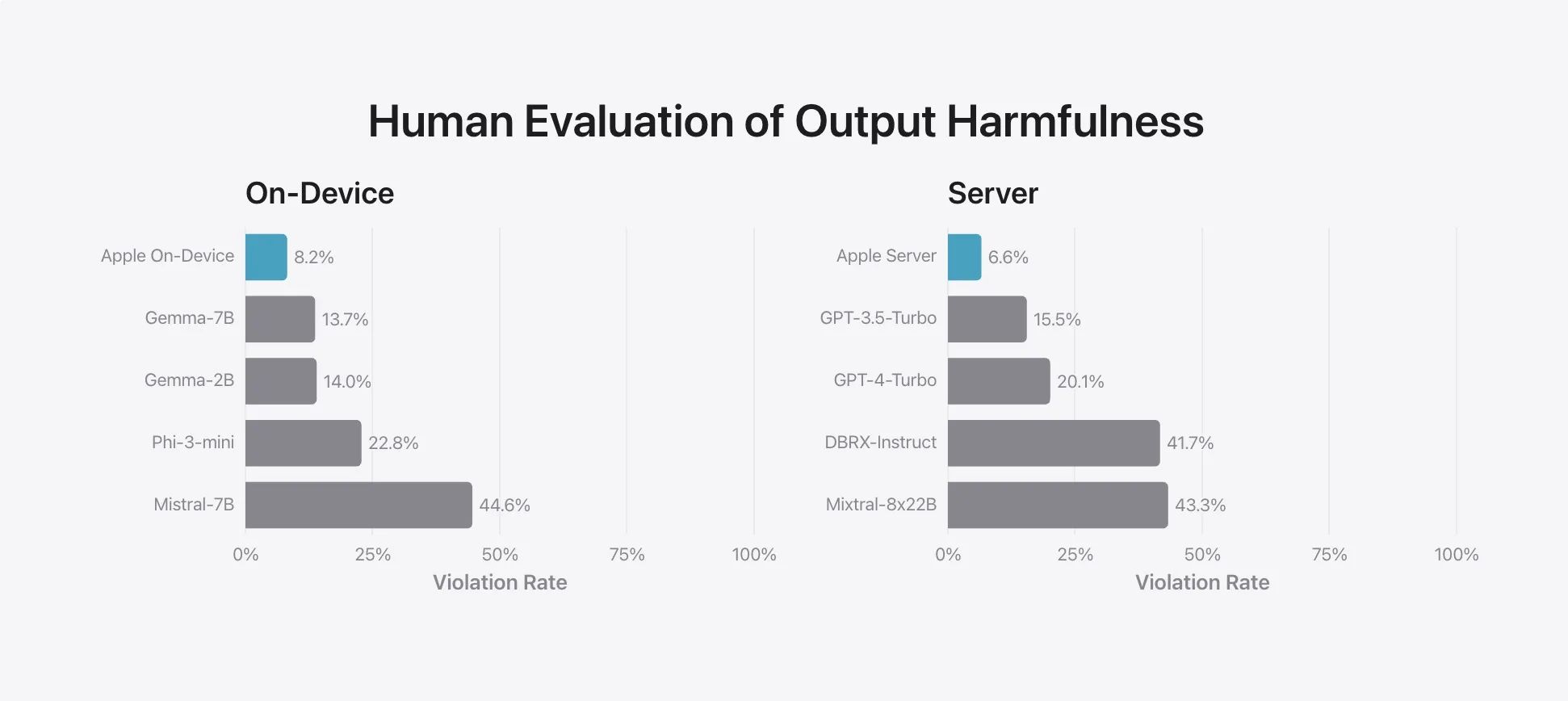

Enfin, lors du test de sécurité et de nocivité, les modèles d’Apple sur appareil et sur serveur ont généré les réponses les moins nocives. Cela signifie qu’Apple a travaillé très dur pour aligner et apprivoiser les modèles d’IA afin qu’ils ne génèrent pas de contenu préjudiciable sur des sujets sensibles.

Apple a développé des modèles de fondation performants

En conclusion, il semble qu’Apple ait réussi à développer des modèles capables pour les applications d’IA générative, bien qu’elle soit arrivée tardivement à la fête. Je suis particulièrement impressionné par le modèle d’IA local, sur l’appareil, qui surpasse les modèles Phi-3 de Microsoft et Gemma 1.1 de Google. Le modèle serveur est également très bon, car vous obtenez souvent des réponses meilleures que GPT-3.5 Turbo.

Nous attendons qu’Apple Intelligence soit disponible sur les appareils pris en charge pour pouvoir comparer directement les modèles avec ceux d’autres concurrents.