Cloudflare a récemment annoncé une nouvelle solution gratuite pour empêcher les bots d’IA de scraper les sites Web pour obtenir des données d’entraînement de modèles. Alors que Google, OpenAI et Apple permettent déjà aux propriétaires de sites Web de bloquer leurs bots en modifiant le fichier robots.txt, Cloudflare a souligné que tous les scrapers d’IA ne respectent pas ces directives.

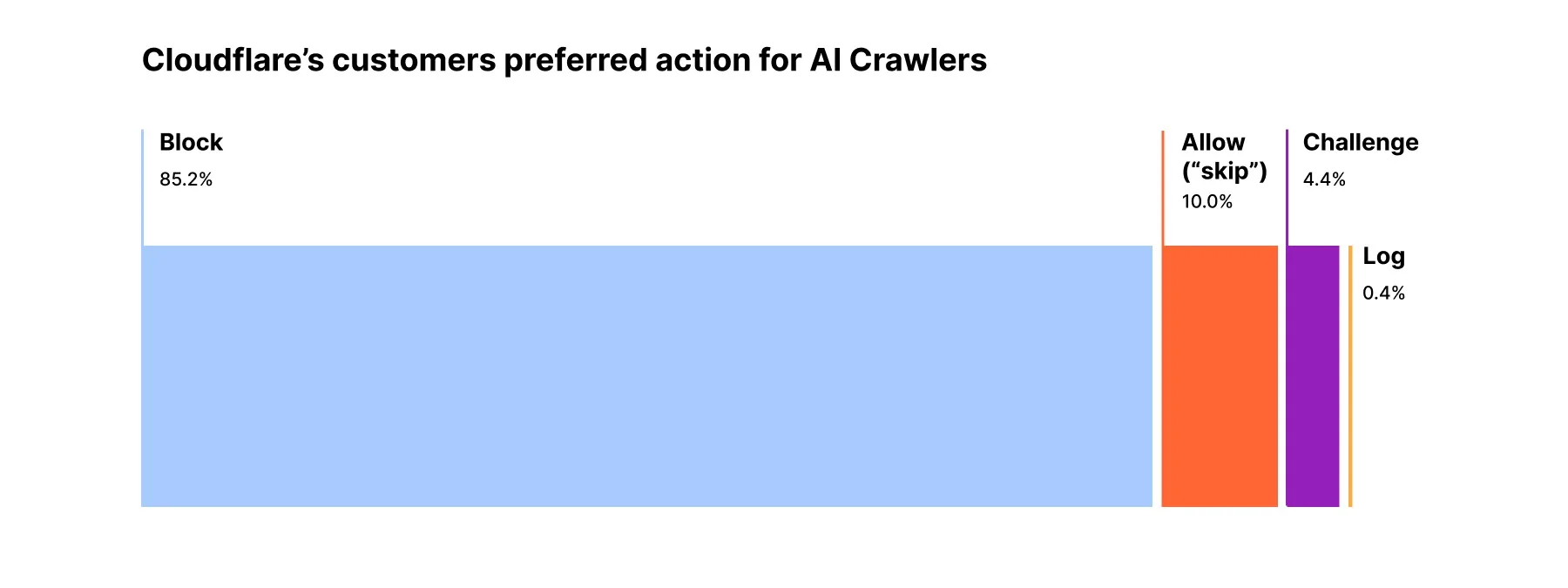

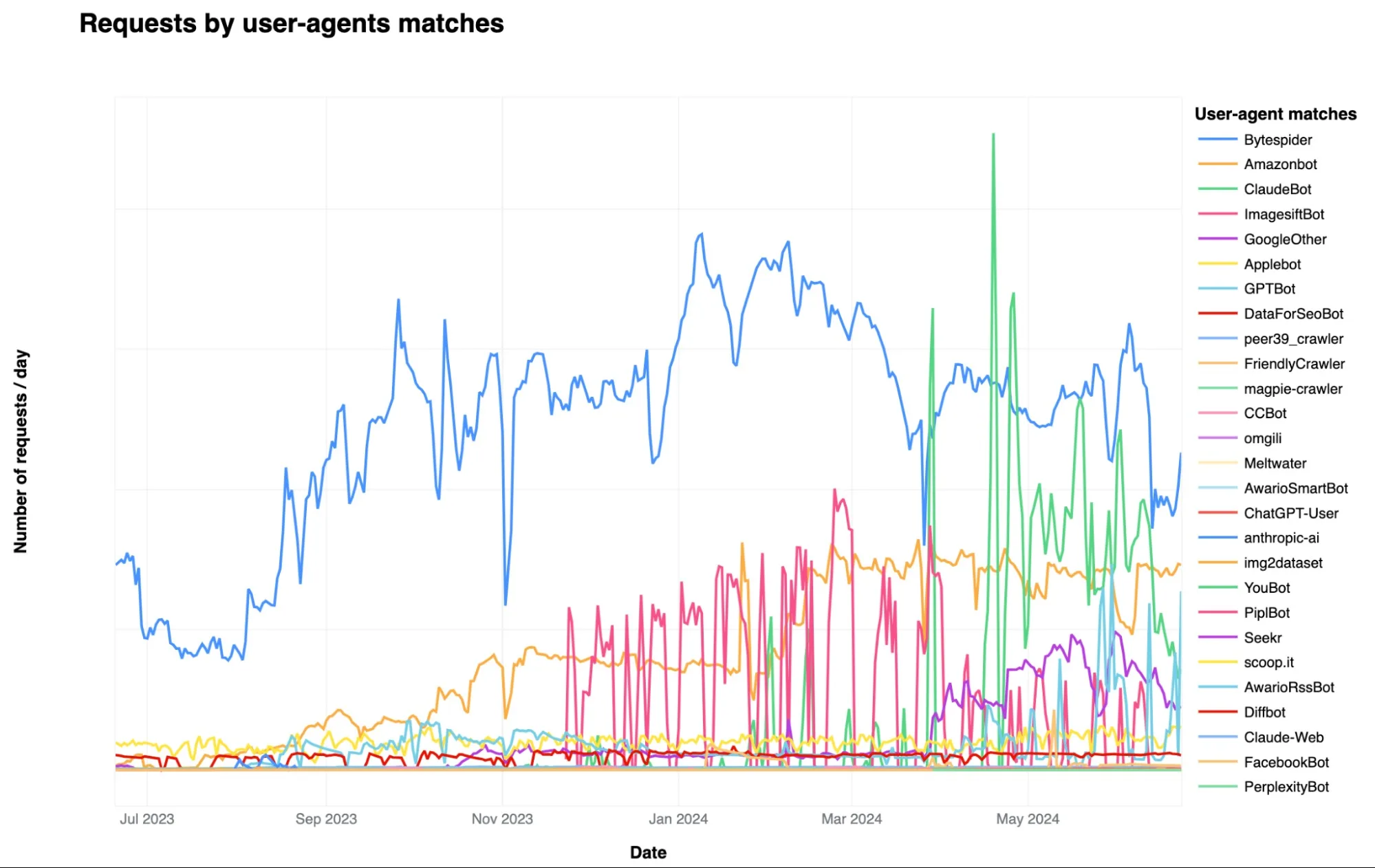

Cloudflare, une entreprise de services cloud cotée en bourse, a constaté que ses clients ne souhaitent pas que les bots d’IA accèdent à leurs sites, en particulier pour des raisons de fraude. Certaines entreprises d’IA, cherchant à contourner les contrôles de contenu, continuent d’adapter leurs méthodes pour éviter la détection. Cloudflare a évalué les bots d’IA et le trafic des crawlers pour améliorer ses algorithmes de détection automatique. Ces algorithmes déterminent si un bot d’IA tente de se faire passer pour un utilisateur humain.

Selon Cloudflare, les acteurs malveillants utilisent des outils et des frameworks facilement identifiables pour crawler les sites à grande échelle. Basés sur ces caractéristiques, leurs algorithmes peuvent identifier le trafic des bots d’IA évitant la détection. Cloudflare permet également aux hôtes de signaler les bots d’IA suspects, qui seront ensuite interdits manuellement.

Avec la croissance de l’IA générative, les bots d’IA deviennent de plus en plus courants, augmentant la demande en données d’entraînement. Craignant que les entreprises d’IA utilisent leur contenu sans permission ni rémunération, plusieurs sites Web limitent l’accès des scrapers et crawlers d’IA.

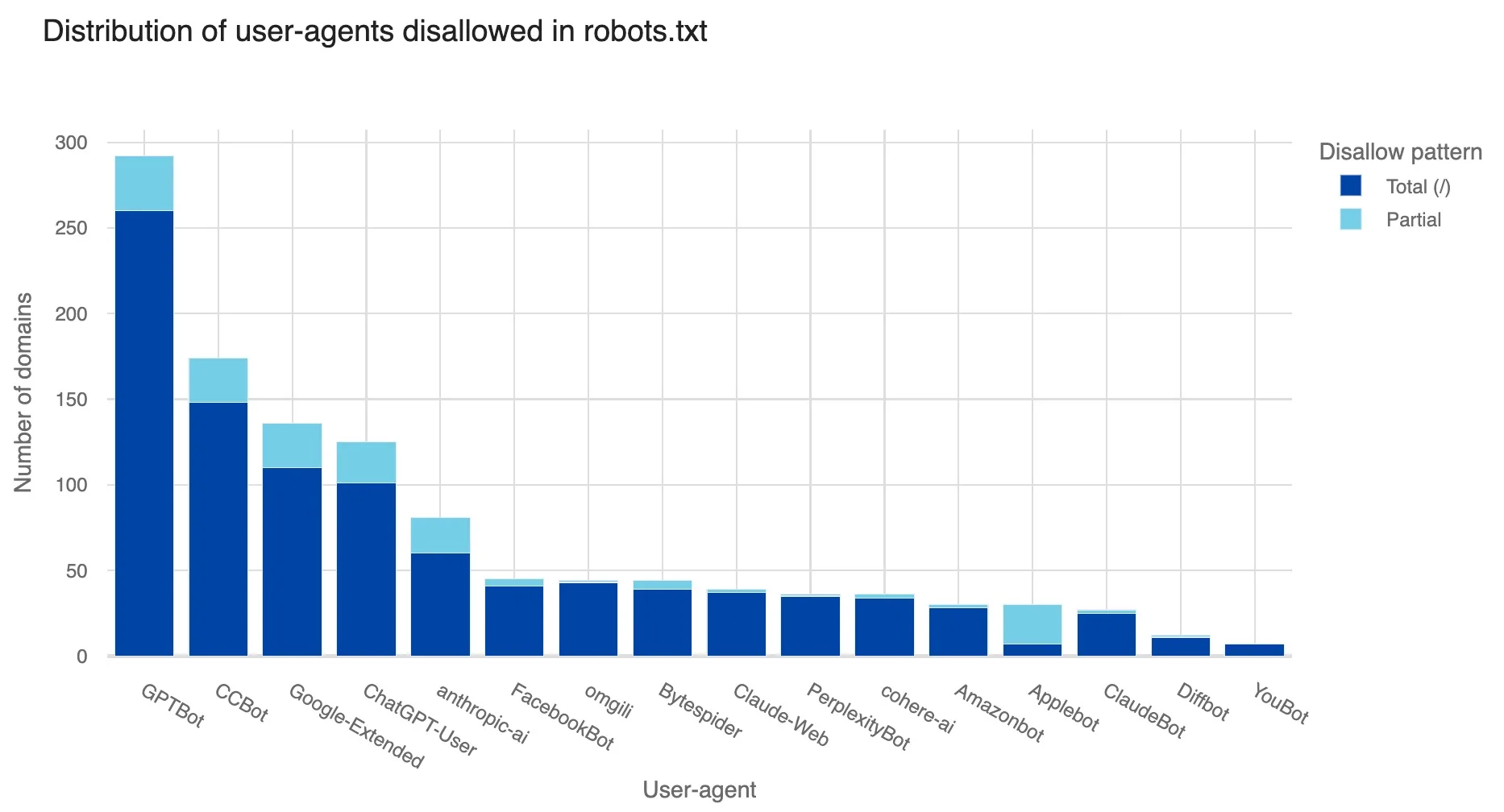

Des études montrent que plus de 600 éditeurs de nouvelles et 26 % des 1 000 principaux sites Web ont désactivé le bot d’OpenAI.

La fiabilité des blocages

Bloquer les bots n’est pas toujours fiable. Certains fabricants contournent les règlements d’exclusion des bots d’IA pour prendre l’avantage. Des accusations ont été portées contre Perplexity pour avoir prétendu être de vrais visiteurs afin de scraper du contenu, tandis qu’OpenAI et Anthropic ont violé les règles de robots.txt.

Les outils de Cloudflare peuvent être utiles pour découvrir les bots d’IA cachés. Cependant, ils ne résolvent pas le problème plus large de la perte de trafic de référence des éditeurs à cause des outils d’IA comme les Google AI Overviews, qui excluent les sites restreignant certains crawlers d’IA.

Le rapport de sécurité de Cloudflare

Cloudflare a récemment publié son rapport 2024 sur l’état de la sécurité des applications. L’analyse montre comment les équipes de sécurité peinent à gérer les dangers des applications contemporaines, qui alimentent de nombreux sites Web populaires. Le rapport révèle que les défis de la chaîne d’approvisionnement logicielle, les attaques DDoS et les bots malveillants submergent les équipes de sécurité des applications.

Dans l’ère numérique, les transactions de commerce électronique, l’échange sécurisé de données de santé et les activités mobiles quotidiennes dépendent des applications Web et des API. Avec leur popularité croissante, les cyberattaques deviennent plus probables. Le développement rapide de nouvelles fonctionnalités, comme l’IA générative, augmente la surface d’attaque. Selon le rapport, les applications non protégées peuvent perturber les affaires, coûter de l’argent et détruire des infrastructures vitales.

Le cofondateur et PDG de Cloudflare, Matthew Prince, a noté que les applications en ligne utilisées quotidiennement pour des tâches importantes sont « rarement conçues avec la sécurité à l’esprit », les exposant ainsi aux pirates. L’entreprise a souligné qu’elle empêche 209 milliards d’attaques par jour pour ses clients.

Reddit interdit les bots d’IA

Dans une initiative similaire, Reddit a récemment annoncé qu’il interdira la plupart des bots automatisés d’utiliser ses données sans licence. Mashable a rapporté que Reddit prévoit de modifier son fichier robots.txt pour restreindre les spiders Web. La plateforme cible les entreprises d’IA qui scrutent le Web pour entraîner leurs modèles, en ignorant les droits d’auteur ou les conditions d’utilisation des sites.

Dans un article de blog, Reddit a expliqué que les « acteurs de bonne foi » tels que les universitaires et Internet Archive peuvent toujours accéder à ses informations à des fins non commerciales.