Le Meta Connect 2024 marque une avancée significative dans l’univers de l’intelligence artificielle avec l’introduction de Llama 3.2, le premier modèle multimodal open-source de Meta capable de comprendre à la fois le texte et les images.

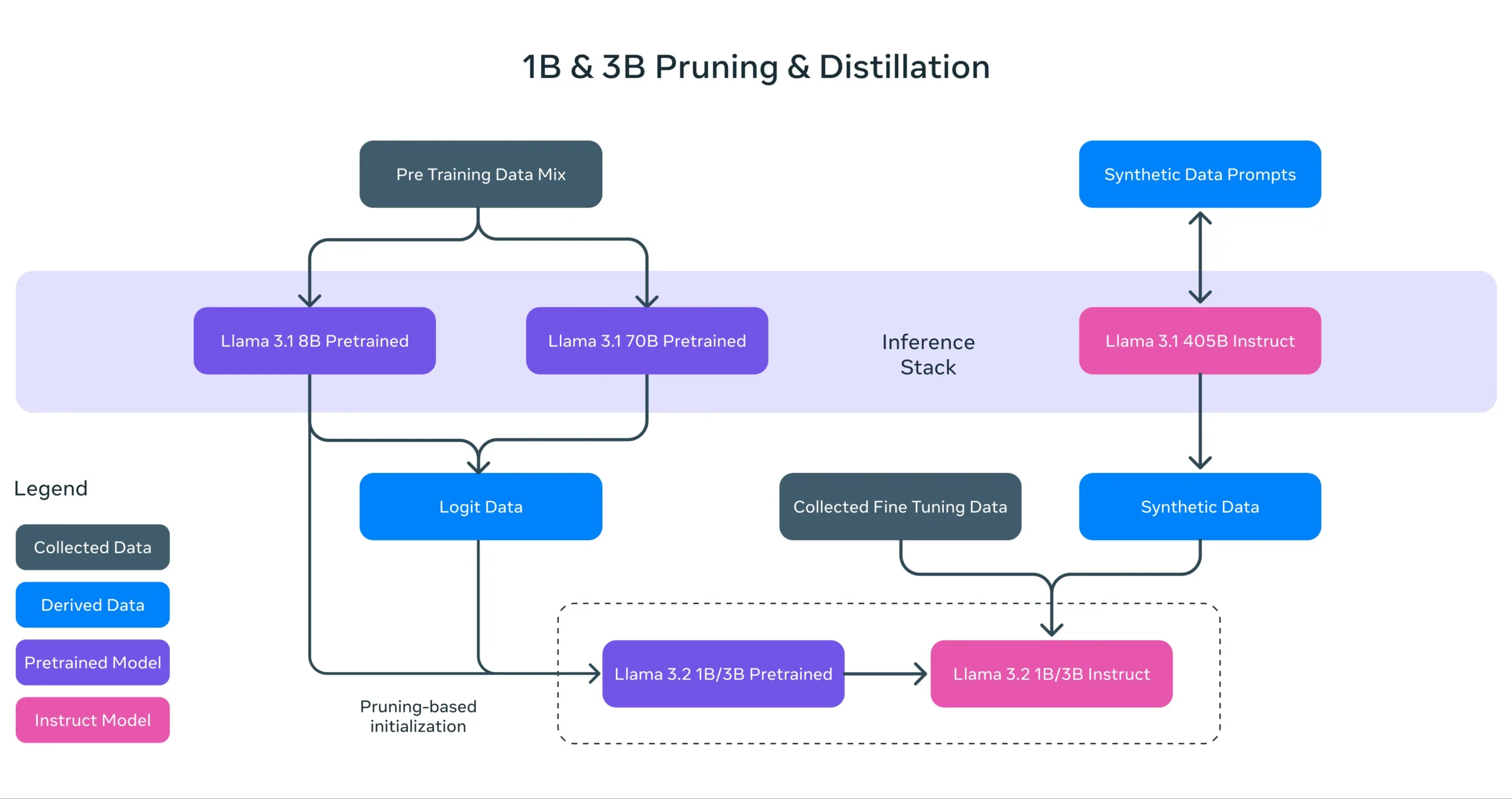

Llama 3.2 se décline en plusieurs versions : des modèles de taille petite et moyenne (11B et 90B paramètres) ainsi que des modèles légers textuels (1B et 3B paramètres) optimisés pour les appareils mobiles et périphériques. Mark Zuckerberg, PDG de Meta, a souligné l’importance de ce lancement lors de son discours d’ouverture : « C’est notre premier modèle multimodal open source. Il va ouvrir la voie à de nombreuses applications nécessitant une compréhension visuelle ».

À l’instar de son prédécesseur, Llama 3.2 dispose d’une longueur de contexte de 128 000 tokens, permettant aux utilisateurs de saisir de grandes quantités de texte (équivalentes à des centaines de pages). De plus, un nombre de paramètres élevé garantit une meilleure précision et la capacité de gérer des tâches plus complexes.

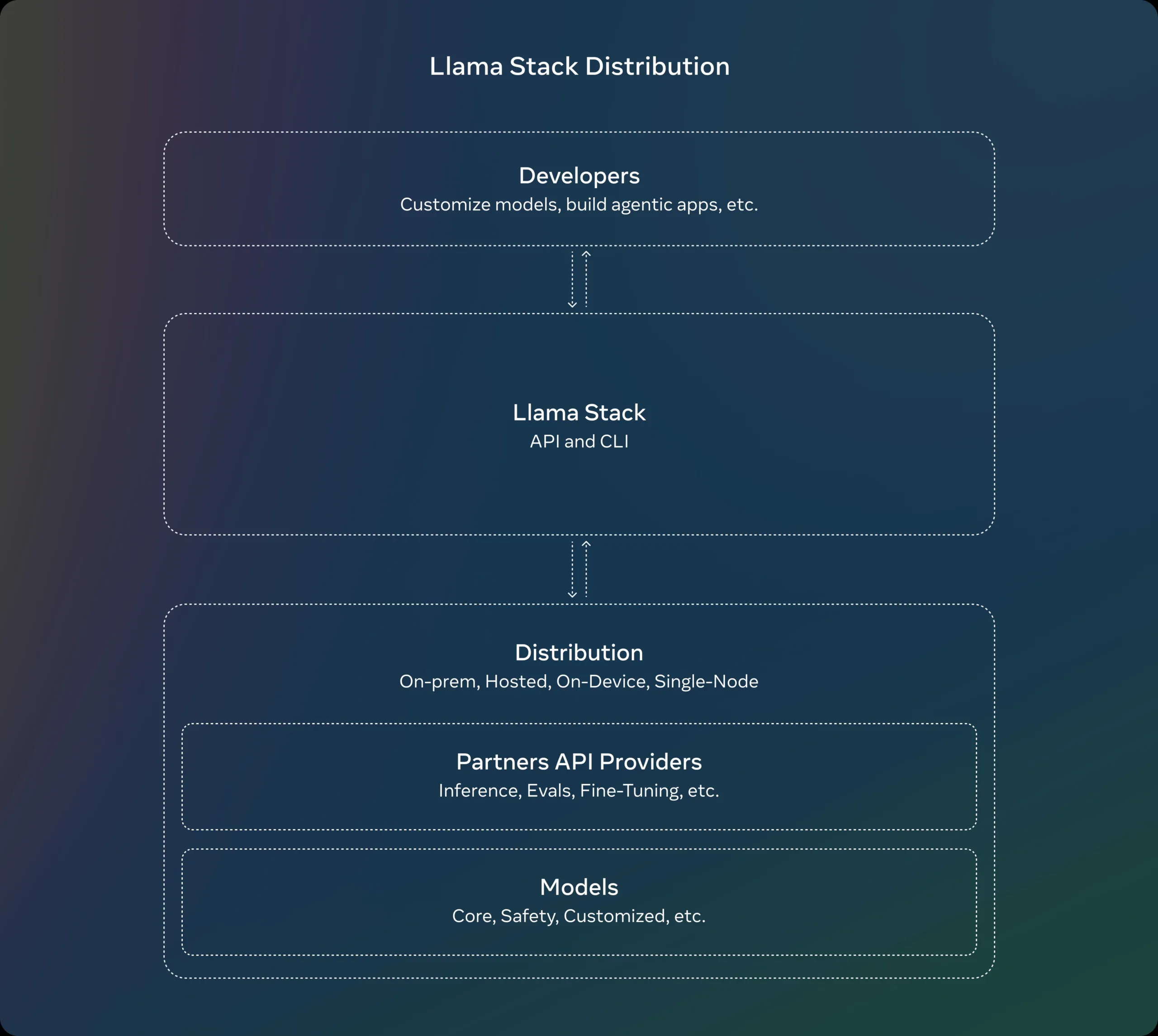

Meta publie également pour la première fois des distributions officielles de la pile Llama, offrant aux développeurs la flexibilité de travailler avec les modèles dans divers environnements : sur site, sur appareil, dans le cloud ou sur un nœud unique.

Mark Zuckerberg a réaffirmé l’importance de l’open source : « L’open source est en train de devenir, et est déjà, l’option la plus rentable, personnalisable, fiable et performante. Nous avons atteint un point d’inflexion dans l’industrie. C’est en train de devenir un standard, le Linux de l’IA ».

Llama 3.2, des performances rivalisant avec les modèles fermés

Llama 3.1, lancé il y a un peu plus de 2 mois, a connu une croissance impressionnante, multipliant par 10 son utilisation. Mark Zuckerberg a déclaré : « Llama continue de s’améliorer rapidement. Il permet de plus en plus de fonctionnalités ».

Les deux plus grands modèles Llama 3.2 (11B et 90B) prennent en charge les cas d’utilisation d’images, avec la capacité de comprendre des graphiques, de légender des images et d’identifier des objets à partir de descriptions en langage naturel. Par exemple, un utilisateur peut demander à quel mois son entreprise a réalisé les meilleures ventes, et le modèle fournira une réponse basée sur les graphiques disponibles. Les modèles plus grands peuvent également extraire des détails d’images pour créer des légendes.

Les modèles légers, quant à eux, aident les développeurs à créer des applications personnalisées dans un environnement privé, comme résumer des messages récents ou envoyer des invitations à des réunions de suivi.

Meta affirme que Llama 3.2 est compétitif avec Claude 3 Haiku d’Anthropic et GPT4o-mini d’OpenAI en matière de reconnaissance d’images et d’autres tâches de compréhension visuelle. Il surpasse également Gemma et Phi 3.5-mini dans des domaines tels que le suivi des instructions, le résumé, l’utilisation d’outils et la réécriture de prompts.

Les modèles Llama 3.2 sont disponibles en téléchargement sur llama.com et Hugging Face, ainsi que sur les plateformes partenaires de Meta.

Meta rattrape son retard

Si d’autres acteurs de l’IA, comme OpenAI et Google, ont déjà lancé des modèles multimodaux l’année dernière, Meta était jusqu’à présent à la traîne. L’ajout de la prise en charge des images jouera un rôle clé dans le développement des capacités d’IA sur les équipements Meta, tels que les lunettes Ray-Ban Meta.

Malgré l’arrivée de Llama 3.2, le modèle Llama 3.1, sorti en juillet, reste pertinent. Il inclut une version avec 405 milliards de paramètres, théoriquement plus performante pour la génération de texte.