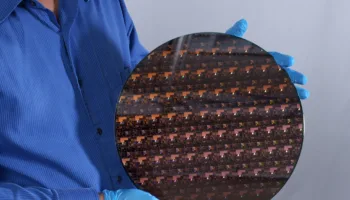

OpenAI intensifie ses efforts pour développer une puce d’IA interne en partenariat avec TSMC et Broadcom, tout en intégrant progressivement des puces AMD en complément de celles de Nvidia pour entraîner ses modèles d’intelligence artificielle.

OpenAI, après avoir envisagé de créer un réseau d’usines de fabrication de puces, aurait finalement abandonné cette idée, selon un rapport de Reuters.

Désormais, l’accent est mis sur la conception de puces en interne, en étroite collaboration avec Broadcom. Cette puce personnalisée, dédiée aux charges de travail des modèles d’IA, pourrait voir le jour dès 2026, apportant à OpenAI une plus grande autonomie face à la demande croissante de calcul pour l’intelligence artificielle.

En parallèle, OpenAI élargit ses capacités en intégrant des puces AMD via la plateforme cloud Azure de Microsoft pour l’entraînement de ses modèles. Jusqu’ici, l’entreprise dépendait presque exclusivement des GPU de Nvidia, mais des pénuries et des retards dans la disponibilité de ces puces, ainsi que les coûts élevés de l’entraînement de ses modèles, ont incité OpenAI à explorer des alternatives.

Optimisation des coûts et indépendance technologique pour OpenAI

Cette stratégie de diversification des puces, combinée au développement d’une puce d’IA maison, s’inscrit dans la lignée des efforts de réduction des coûts et d’optimisation des performances des serveurs pour les charges d’IA. OpenAI suit ainsi la tendance observée chez des géants de la tech comme Google et Microsoft, qui investissent dans la conception de solutions matérielles personnalisées pour répondre aux besoins croissants d’infrastructure dans le domaine de l’IA.

En diversifiant ses partenaires technologiques et en s’engageant dans la voie des puces personnalisées, OpenAI vise à mieux contrôler ses ressources matérielles et à se prémunir contre les fluctuations du marché des semi-conducteurs.