Le mode vocal avancé de ChatGPT, qui permet des conversations en temps réel avec le chatbot, pourrait bientôt s’enrichir d’une nouvelle fonctionnalité : la reconnaissance visuelle en direct.

Cette évolution, découverte dans le code de la dernière version bêta de la plateforme, laisse entrevoir une capacité de caméra en direct imminente, selon des informations rapportées par Android Authority. Bien que OpenAI n’ait pas encore officiellement confirmé cette mise à jour, le code repéré dans la version bêta v1.2024.317 de ChatGPT indique une avancée technologique majeure.

ChatGPT : Des débuts prometteurs pour la vision en mode vocal avancé

Lors de son lancement en mai dernier, OpenAI avait présenté une démonstration de la capacité visuelle du mode vocal avancé. Le chatbot, en utilisant la caméra d’un smartphone, pouvait identifier un chien, reconnaître sa balle, et même comprendre leur relation (comme le fait de jouer à la balle). Cette démonstration a immédiatement captivé les testeurs alpha, qui ont découvert le potentiel de cette fonctionnalité dans des scénarios réels.

L’un des cas d’usage marquants a été partagé par un utilisateur sur X (anciennement Twitter). Grâce à la vision de la caméra, ChatGPT a pu répondre à des questions verbales précises sur un chaton, en analysant le flux vidéo en direct.

Une version bêta encore limitée

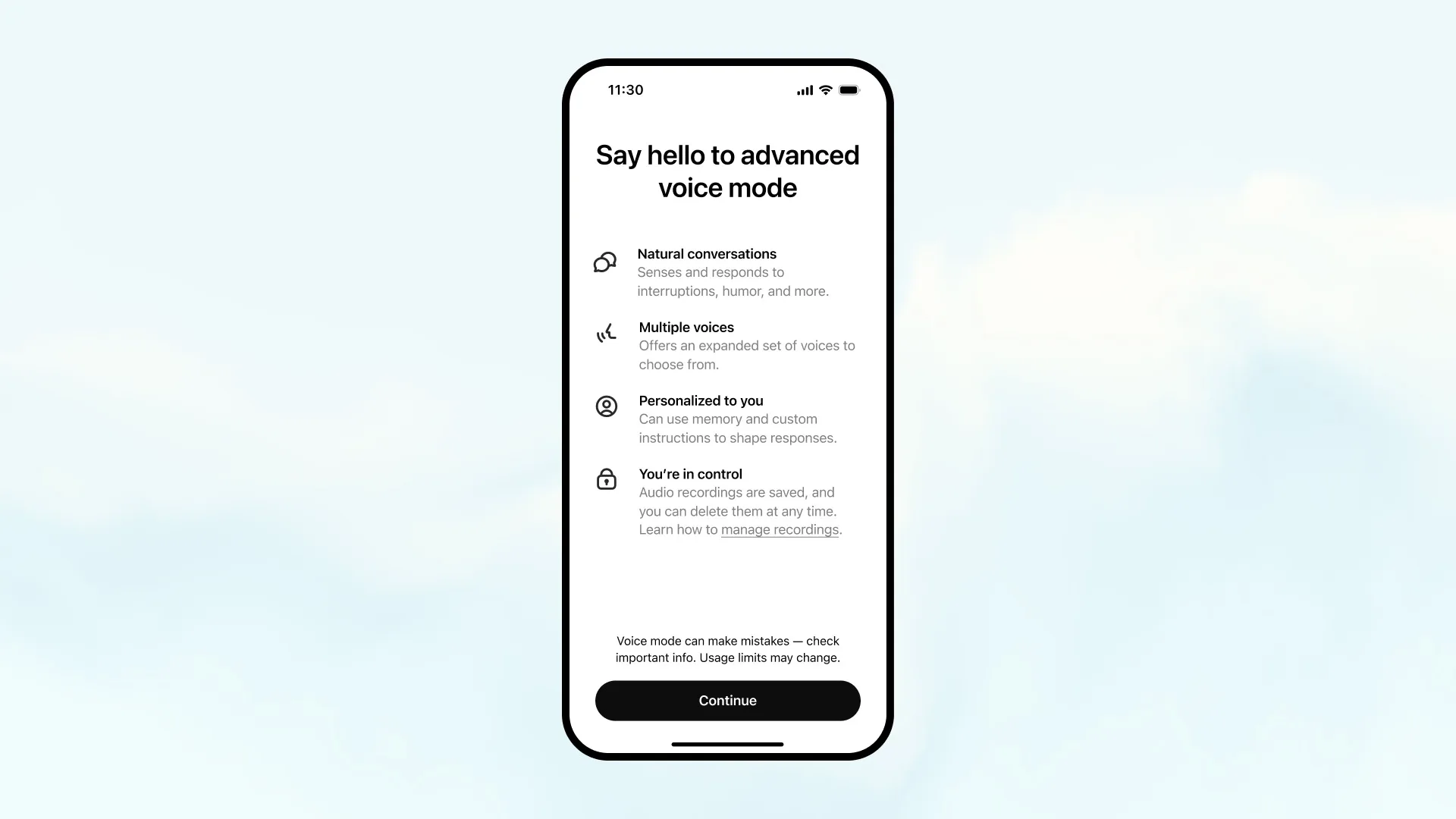

Lorsque le mode vocal avancé a été lancé en version bêta en septembre pour les abonnés Plus et Entreprise, la capacité visuelle n’était pas encore incluse. Malgré cela, la fonctionnalité a rencontré un succès immédiat grâce à des interactions plus naturelles, rapides, et sensibles aux émotions des utilisateurs.

Selon OpenAI, ce mode permet non seulement de répondre en temps réel, mais aussi d’interrompre les réponses et de capter les nuances émotionnelles dans la voix des utilisateurs, rendant les conversations encore plus immersives.

Une innovation qui pourrait devancer la concurrence

L’ajout d’une capacité visuelle viendrait renforcer le positionnement de ChatGPT face à ses principaux concurrents, notamment Google et Meta.

- Google Gemini Live, bien qu’impressionnant avec sa prise en charge de plus de 40 langues, reste limité à des interactions conversationnelles et n’intègre pas encore de fonctionnalités visuelles. Son projet ambitieux, Project Astra, pourrait changer cela à l’avenir, mais il est encore en développement.

- De son côté, les Natural Voice Interactions de Meta, présentées lors de l’événement Connect 2024 en septembre, ne proposent pas non plus d’entrée par caméra.

Avec cette nouvelle fonctionnalité, ChatGPT se positionnerait donc en leader de l’innovation en matière d’interactions vocales et visuelles.

Que pouvons-nous attendre de cette évolution ?

Si cette mise à jour est lancée, le mode vocal avancé de ChatGPT ne se contentera plus de répondre à la voix. Il pourrait identifier des objets, analyser des scènes, ou encore associer des concepts visuels à des interactions vocales en temps réel.

Imaginez pouvoir demander à ChatGPT d’identifier des produits dans une boutique, d’expliquer des éléments d’un paysage, ou même d’analyser des documents physiques simplement en les montrant à votre caméra.

Avec la concurrence acharnée dans le domaine de l’intelligence artificielle conversationnelle, OpenAI semble déterminée à repousser les limites de ce que l’IA peut offrir. Si cette fonctionnalité voit le jour, elle pourrait bien redéfinir la manière dont les utilisateurs interagissent avec leurs assistants numériques, combinant vue, voix, et émotions pour une expérience toujours plus immersive.