Lancé en octobre dernier par OpenAI, l’outil ChatGPT Search ambitionnait de fournir des réponses rapides et précises, accompagnées de liens vers des sources fiables. Cependant, une récente étude menée par le Tow Center for Digital Journalism de l’Université de Columbia révèle que ChatGPT Search peine à offrir des réponses véritablement fiables.

L’étude a évalué la capacité de ChatGPT Search à identifier correctement les sources de citations extraites d’articles. Pour ce faire, les chercheurs ont soumis 200 citations issues de 20 publications différentes au chatbot. Ces citations comprenaient des extraits provenant de médias partenaires d’OpenAI, de plaignants ayant intenté des actions en justice contre l’entreprise, ainsi que de médias indépendants ayant bloqué l’accès à leurs données.

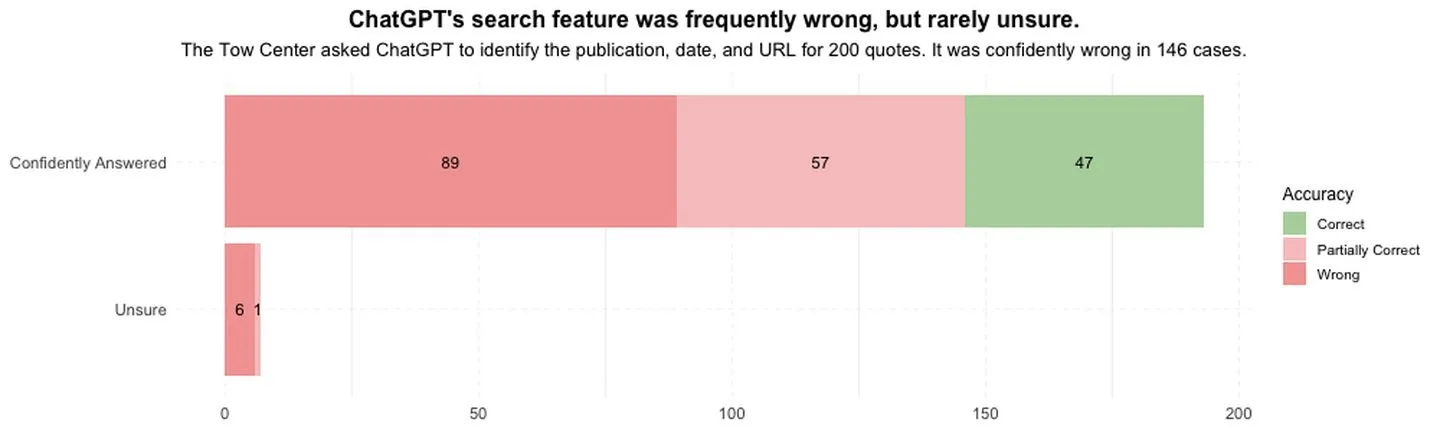

Les résultats montrent que ChatGPT Search a échoué à fournir des réponses précises dans 153 cas. Pire encore, l’outil n’a reconnu son incapacité à répondre correctement qu’à sept reprises, se contentant d’énoncer des réserves comme « il semble », « c’est possible » ou « je n’ai pas trouvé l’article exact ».

ChatGPT Search, exemples marquants d’erreurs et d’attributions incorrectes

L’étude documente plusieurs exemples où ChatGPT Search a généré des réponses incorrectes ou trompeuses :

- Erreur d’attribution : Une citation issue d’une lettre d’opinion publiée par l’Orlando Sentinel a été attribuée à tort à un article de Time Magazine.

- Lien vers un site plagiaire : En cherchant la source d’une citation du New York Times sur des baleines en voie d’extinction, l’outil a renvoyé un lien vers un site tiers ayant entièrement plagié l’article original.

Ces erreurs ne sont pas isolées et révèlent une tendance inquiétante pour un outil censé s’appuyer sur des sources fiables et bien identifiées.

Face aux critiques, OpenAI a répondu que l’étude de Columbia n’utilisait pas une méthodologie représentative des usages réels de ChatGPT Search. Dans une déclaration au Columbia Journalism Review, l’entreprise a indiqué que les résultats seraient difficiles à corriger sans un accès complet aux données et à la méthodologie de l’étude.

Malgré cela, OpenAI a promis de continuer à améliorer la précision de son outil, tout en soulignant les défis inhérents à la correction des erreurs d’attribution.

Un impact sur la crédibilité et les éditeurs

Les problèmes de ChatGPT Search ne se limitent pas à OpenAI : ils risquent d’avoir un impact négatif sur les éditeurs eux-mêmes. Lorsque des articles sont mal attribués ou lorsque des sites plagiaires sont mis en avant, cela compromet la réputation des médias légitimes tout en renforçant les mauvaises pratiques en ligne.

De plus, ces erreurs pourraient nuire à la confiance des utilisateurs envers ChatGPT Search, d’autant plus que l’outil prétend fournir des réponses rapides et fiables basées sur des sources authentiques.

Un avenir incertain pour ChatGPT Search

En dépit de ses promesses, ChatGPT Search semble encore loin d’être une alternative crédible à des moteurs de recherche établis comme Google. La capacité de générer des réponses fluides ne suffit pas si l’exactitude et la transparence font défaut.

Pour regagner la confiance des utilisateurs et des éditeurs, OpenAI devra non seulement améliorer son outil, mais aussi renforcer ses partenariats avec les médias pour garantir une utilisation éthique et responsable de leurs contenus.

En attendant, cette étude souligne une fois de plus les défis de l’intégration de l’intelligence artificielle dans le domaine de la recherche d’information et de l’attribution des contenus. OpenAI devra redoubler d’efforts pour transformer ChatGPT Search en un outil véritablement fiable.