DeepSeek R1, un modèle développé par une équipe chinoise, a secoué l’industrie de l’IA. Il a surpassé ChatGPT et s’est hissé en tête du classement de l’App Store américain.

Mais ce n’est pas tout : DeepSeek a également bouleversé le marché boursier technologique aux États-Unis grâce à son modèle révolutionnaire R1, qui prétend se mesurer à ChatGPT o1.

Même si vous pouvez accéder gratuitement à DeepSeek R1 sur son site officiel, de nombreux utilisateurs s’inquiètent pour la confidentialité de leurs données, celles-ci étant stockées en Chine. Si vous souhaitez exécuter DeepSeek R1 en local sur votre PC ou Mac, vous pouvez facilement le faire grâce à LM Studio et Ollama.

Voici un tutoriel pas à pas pour commencer.

Exécuter DeepSeek R1 en local avec LM Studio

- Téléchargez et installez LM Studio 0.3.8 ou version ultérieure sur votre PC, Mac ou ordinateur sous Linux.

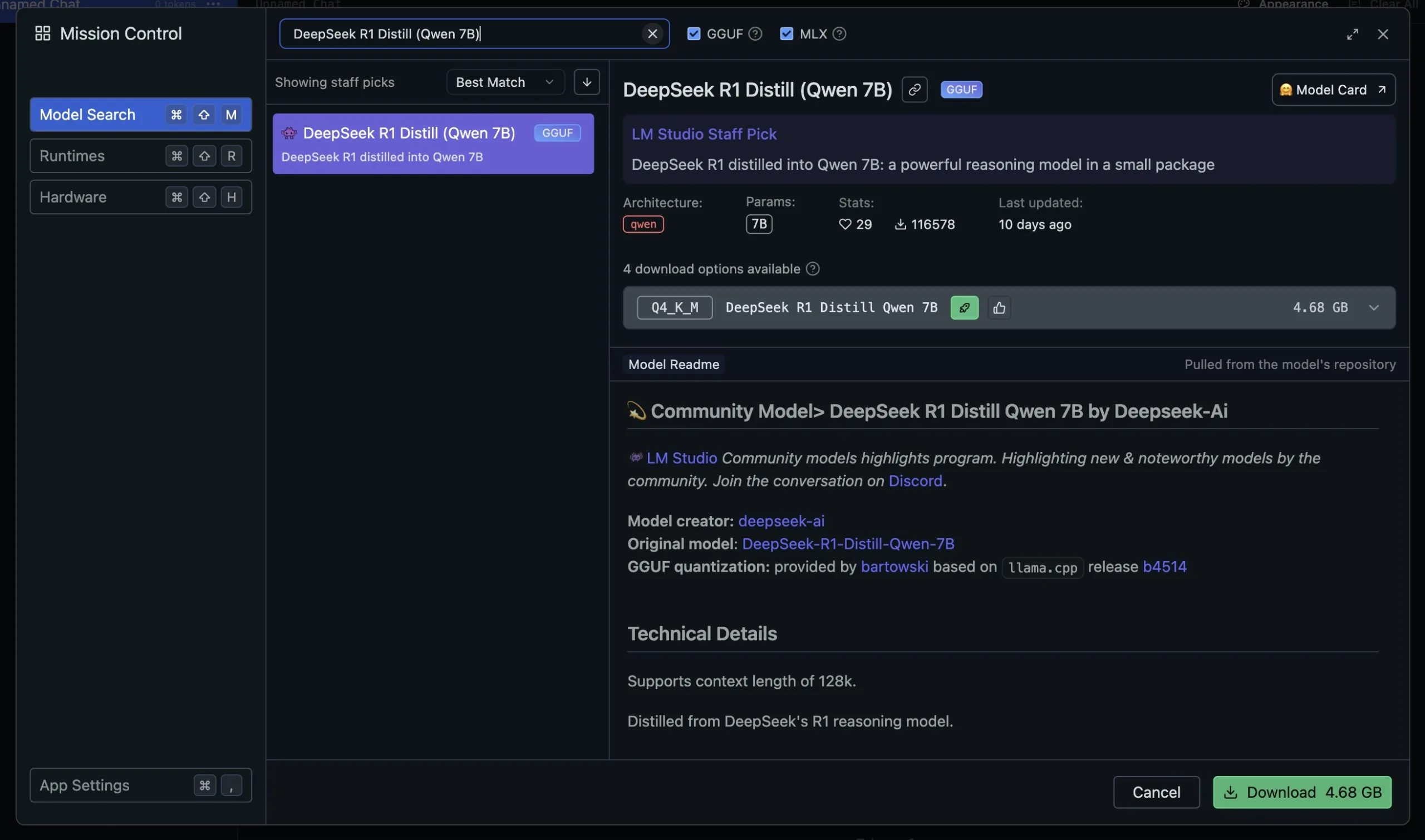

- Lancez ensuite LM Studio et accédez à la fenêtre de recherche dans le panneau de gauche.

- Dans la section Model Search, vous trouverez le modèle « DeepSeek R1 Distill (Qwen 7B) »

- Maintenant, cliquez sur Download. Vous devez disposer d’au moins 5 Go d’espace de stockage et 8 Go de RAM pour utiliser ce modèle.

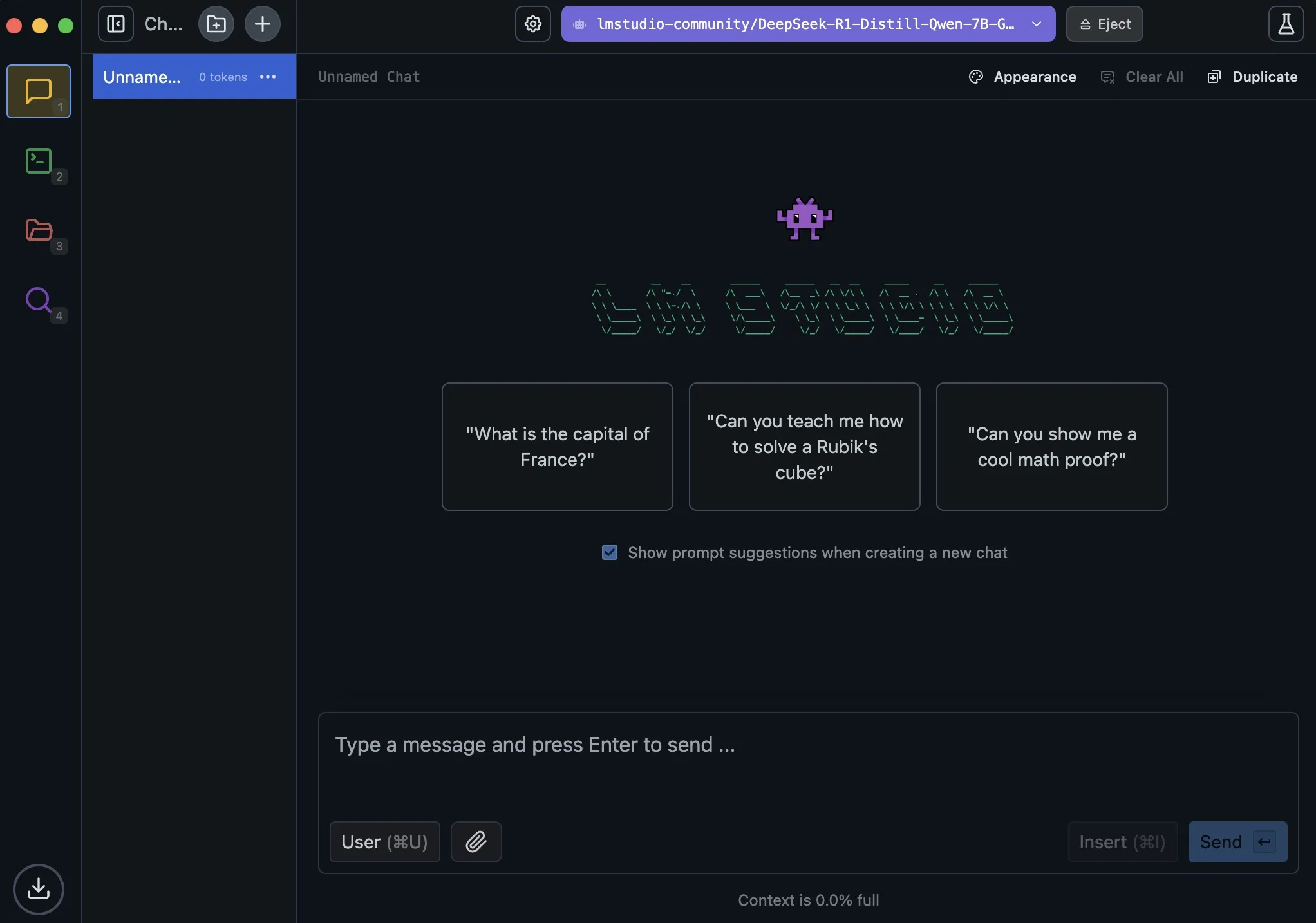

- Une fois le modèle DeepSeek R1 téléchargé, basculez vers l’onglet Chat et chargez le modèle.

- Sélectionnez simplement le modèle et cliquez sur Load Model. Si vous rencontrez une erreur, réduisez la valeur « GPU offload » à 0 et réessayez.

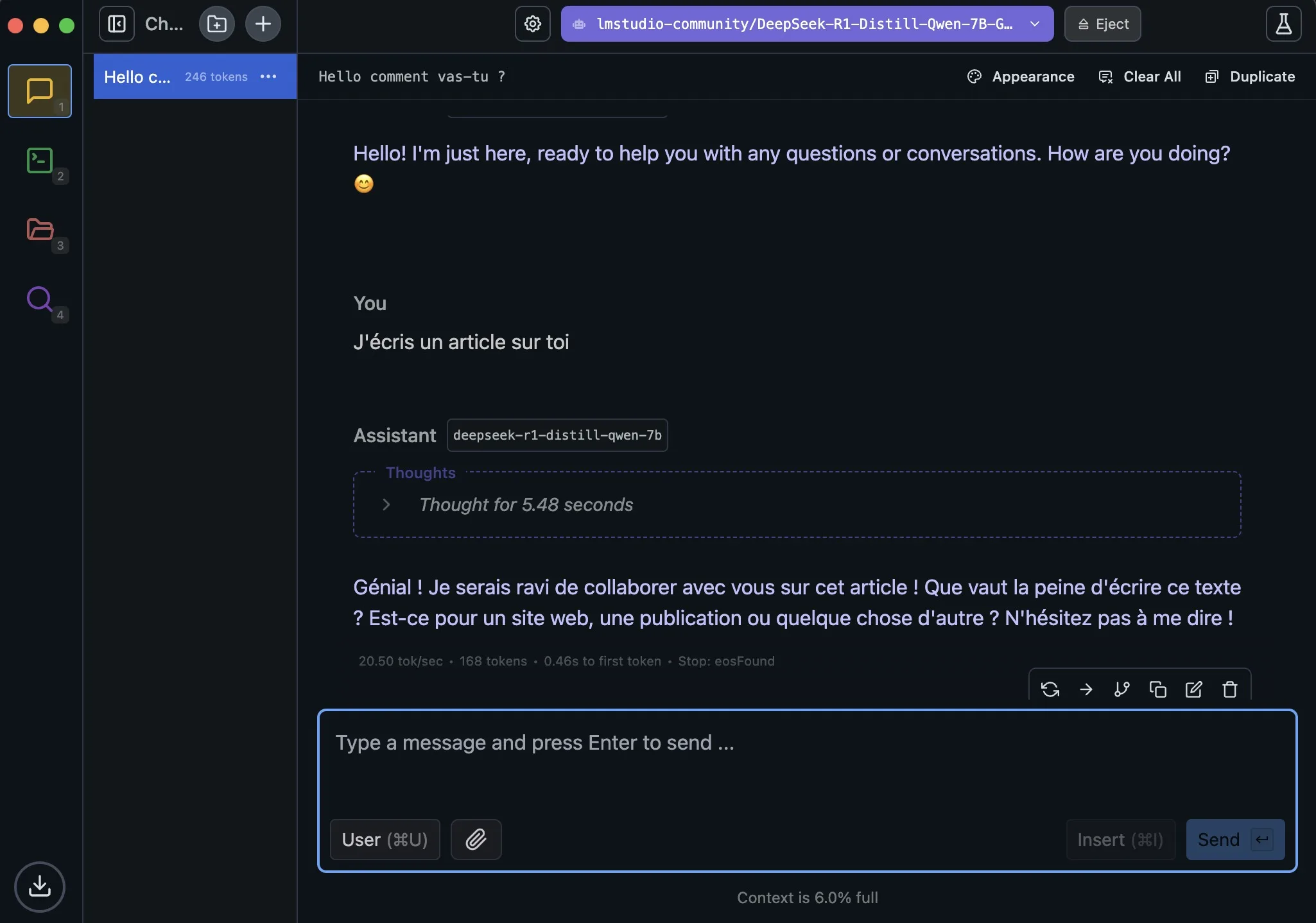

- Vous pouvez maintenant discuter avec DeepSeek R1 sur votre ordinateur en local. Profitez-en !

Exécuter DeepSeek R1 en local avec Ollama

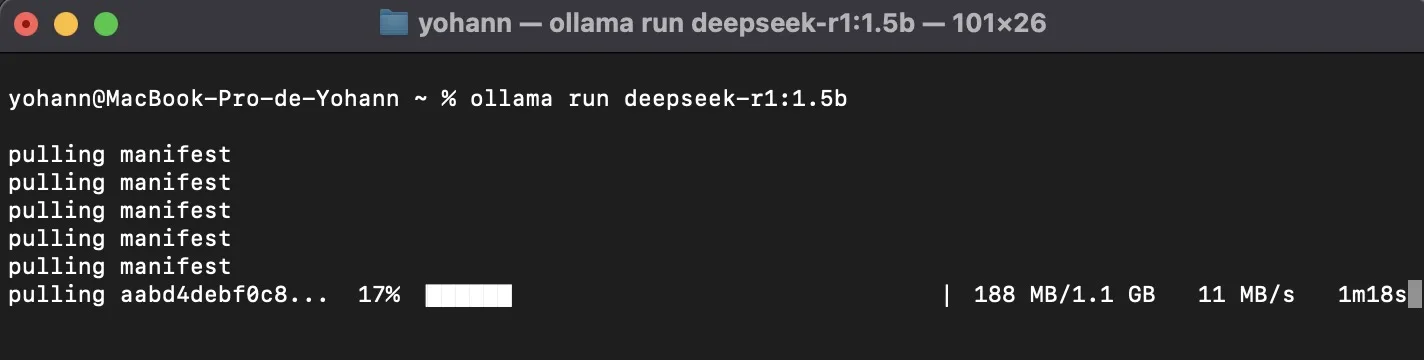

- Installez Ollama sur votre ordinateur Windows, macOS ou Linux.

- Ensuite, lancez le Terminal et exécutez la commande

ollama run deepseek-r1:1.5b.pour lancer DeepSeek R1 en local. Il s’agit d’un petit modèle de 1,5 milliard de paramètres, dérivé de DeepSeek R1 et basé sur Qwen, conçu pour les ordinateurs modestes. Il n’occupe que 1,1 Go de mémoire.

- Si vous disposez d’une large quantité de mémoire et d’un matériel puissant, vous pouvez exécuter les modèles en 7B, 14B, 32B ou 70B dérivés de DeepSeek R1. Les commandes sont disponibles ici. Voici la commande

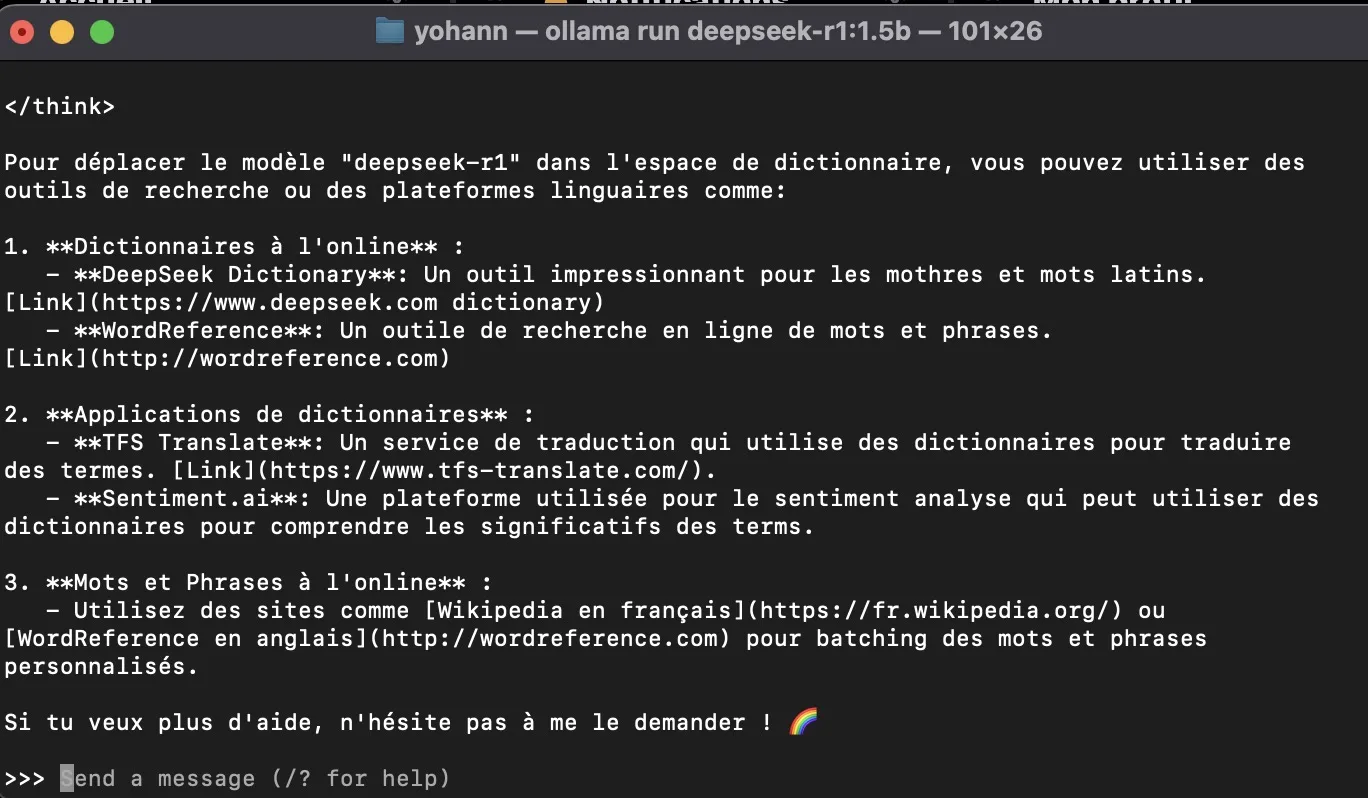

ollama run deepseek-r1:7bpour exécuter le modèle 7B de DeepSeek R1 sur votre ordinateur. Il utilise 4,7 Go de mémoire. - Vous pouvez maintenant dialoguer avec DeepSeek R1 en local sur votre ordinateur, directement depuis le Terminal.

- Pour arrêter la discussion avec le modèle IA et quitter, utilisez le raccourci

Ctrl + D.

Ainsi, voici deux méthodes simples pour installer DeepSeek R1 sur votre ordinateur et discuter avec le modèle d’IA sans connexion Internet. Lors de mes brèves essais, les modèles 1.5B et 7B ont eu tendance à « halluciner » et à se tromper sur certains faits historiques.

Cela dit, vous pouvez aisément utiliser ces modèles pour des tâches de rédaction créative et de raisonnement mathématique. Si vous disposez d’un matériel performant, je vous recommande d’essayer le modèle DeepSeek R1 32B. Il est nettement meilleur pour générer du code et fournir des réponses plus étayées.