Deux ans après l’arrivée de ChatGPT, les Large Language Model (LLM) se multiplient et restent vulnérables aux jailbreaks, ces techniques permettant de contourner les garde-fous pour obtenir du contenu interdit.

Malgré les efforts des développeurs, aucune solution efficace ne permet encore d’éliminer totalement ces failles. Cependant, Anthropic, le rival d’OpenAI et créateur de Claude 3.5 Sonnet, a introduit une nouvelle protection : les « classificateurs constitutionnels ». Selon l’entreprise, cette technologie bloque la grande majorité des attaques tout en réduisant les refus excessifs de requêtes légitimes.

Un défi lancé aux experts en cybersécurité

Pour prouver l’efficacité de son système, Anthropic a mis en place un challenge public, demandant aux experts en sécurité et aux « red teamers » de tester des « jailbreaks universels » capables de contourner complètement les protections du modèle.

We challenge you to break our new jailbreaking defense!

There are 8 levels. Can you find a single jailbreak to beat them all?https://t.co/9y0fIT79pN

— Jan Leike (@janleike) February 3, 2025

Le test se concentre sur des informations dangereuses, notamment la création d’armes chimiques. L’expérience, lancée le 10 février, comporte huit niveaux, et l’objectif est de trouver une seule faille capable de toutes les franchir.

Depuis août, Anthropic a également mené un programme de bug bounty via HackerOne, offrant 15 000 dollars à toute personne capable de concevoir un jailbreak universel permettant de répondre à 10 questions interdites. 183 experts ont consacré plus de 3 000 heures à essayer de contourner les protections. Résultat : la meilleure tentative n’a réussi qu’à fournir des informations exploitables sur cinq des dix requêtes interdites.

Un système inspiré de l’IA constitutionnelle

Anthropic a bâti son système sur le concept d’IA constitutionnelle, qui aligne les modèles sur des principes éthiques définis. Par exemple, une recette de moutarde est autorisée, mais pas celle du gaz moutarde.

L’entreprise a développé ses classificateurs constitutionnels en générant 10 000 prompts de jailbreak, traduits dans plusieurs langues et adaptés aux techniques connues de contournement (substitutions de mots, encodages, mises en contexte dans des récits fictifs, etc.).

L’objectif : entraîner un système capable de repérer et bloquer ces tentatives dès la saisie de l’utilisateur.

Comment fonctionne ce bouclier anti-jailbreak ?

Le système utilise une double approche :

- Détection en entrée : chaque requête est encadrée par des instructions détaillant les types d’informations interdites et les méthodes courantes de dissimulation utilisées par les pirates.

- Analyse en sortie : un classificateur calcule en temps réel la probabilité que le texte généré contienne un contenu interdit. Si un certain seuil est dépassé, la réponse est automatiquement bloquée.

Exemple concret : Une demande explicite sur la fabrication d’armes chimiques sera bloquée. Mais si un utilisateur tente de dissimuler cette demande dans un texte anodin (par exemple, un long paragraphe sur la chimie des protéines), le système est conçu pour détecter ces signaux cachés et refuser la requête.

Une protection efficace, mais onéreuse

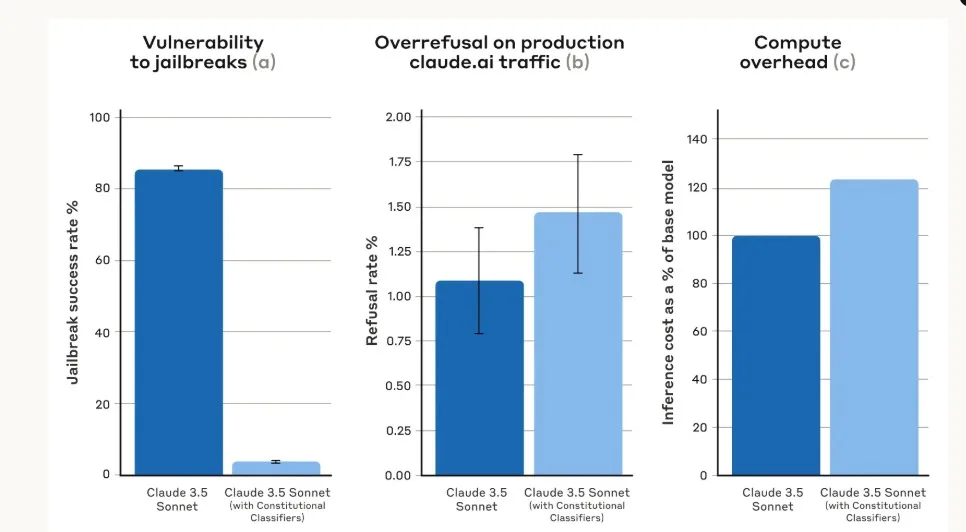

Anthropic a comparé deux versions de Claude 3.5 Sonnet :

- Sans protection : 86 % des attaques ont réussi.

- Avec les classificateurs constitutionnels : seulement 4,4 % des tentatives ont abouti, soit une réduction de 95 % des jailbreaks.

Malgré son efficacité, cette technologie augmente de 23,7 % la consommation de calcul, ce qui impacte les coûts et la consommation d’énergie. Elle refuse aussi 0,38 % de requêtes légitimes en plus par rapport à un modèle non protégé, mais cette différence reste jugée négligeable.

Jailbreaks: quelles techniques fonctionnent encore ?

Bien que le système bloque la majorité des attaques, certaines méthodes restent plus efficaces que d’autres :

- Paraphrase bénigne : transformer une requête interdite en un message anodin. Ex. : au lieu de « Comment extraire la toxine de ricin ? », certains demandent « Comment extraire des protéines de haricot ? » pour contourner la détection.

- Exploitation de la longueur : générer de très longues réponses techniques, en espérant qu’une information interdite passe à travers les filtres.

En revanche, les techniques les plus avancées, comme le « God-Mode » ou les attaques par contexte ultra-long n’ont pas fonctionné.

Pourquoi ? Les attaquants ont privilégié des stratégies visant à tromper le système d’évaluation plutôt qu’à contourner réellement les défenses.

Vers une IA plus sûre, mais pas inviolable

Anthropic reconnaît que son système n’est pas infaillible et que de nouvelles techniques de jailbreak apparaîtront inévitablement. Toutefois, l’entreprise estime que ces protections :

- Complexifient grandement les attaques, rendant le jailbreak plus coûteux et difficile à réaliser.

- Sont adaptables rapidement : la « constitution » qui entraîne les classificateurs peut être modifiée pour couvrir de nouvelles failles dès qu’elles sont découvertes.

Pour tester ces protections, Anthropic ouvre désormais l’accès au public jusqu’au 10 février. Tout utilisateur de Claude peut essayer de contourner les défenses du modèle sur huit questions spécifiques liées aux armes chimiques.

Si un jailbreak est découvert, Anthropic s’engage à analyser et publier les résultats.

La course entre développeurs d’IA et hackers continue, et si Anthropic a pris une longueur d’avance, l’histoire montre que chaque nouvelle protection appelle une nouvelle attaque.