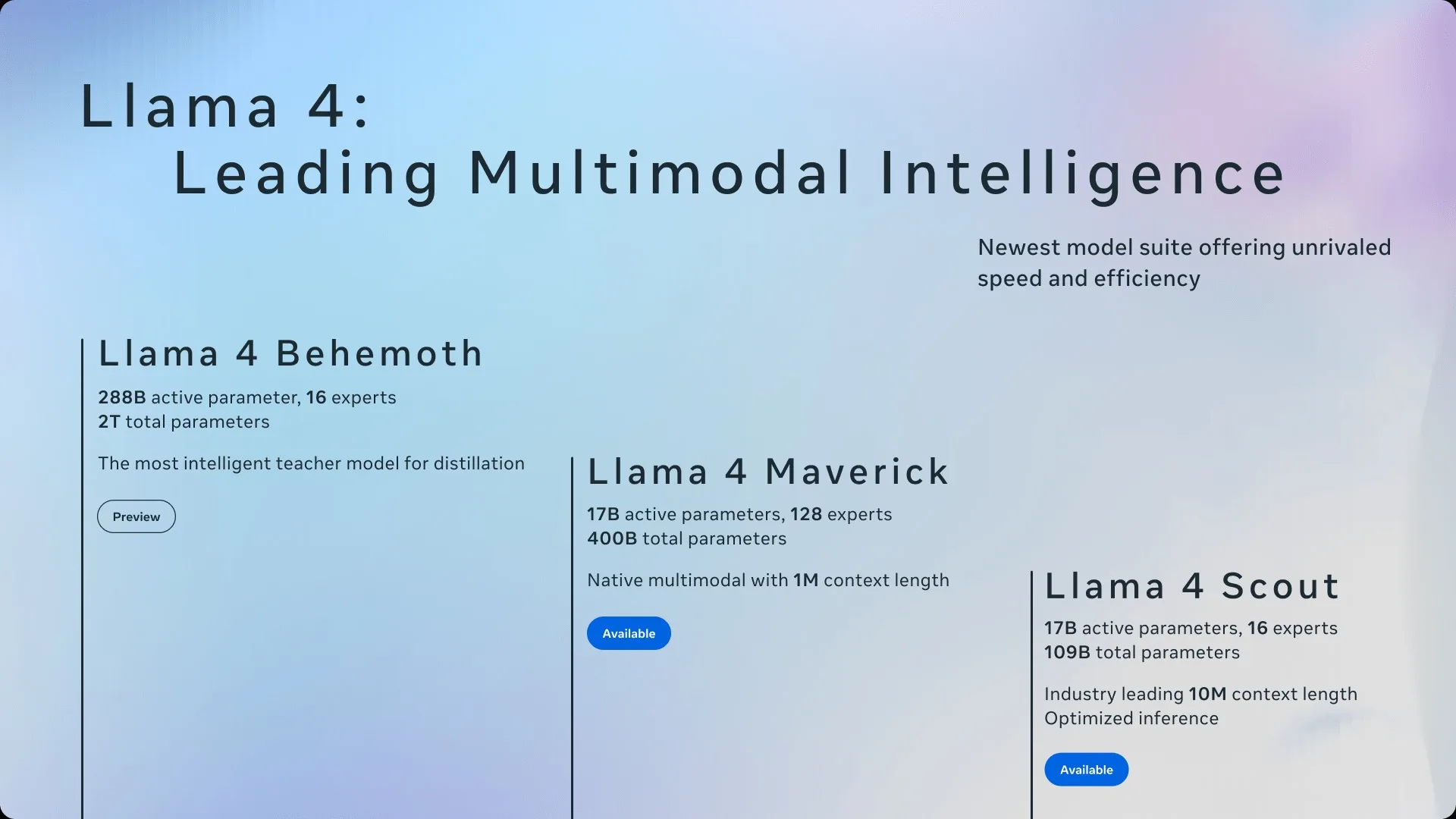

Meta fait face à des accusations selon lesquelles la société aurait manipulé les résultats de benchmarks pour son modèle d’intelligence artificielle Llama 4 Maverick. Ce modèle a atteint un score ELO impressionnant de 1 417 sur Chatbot Arena, surpassant des modèles concurrents tels que GPT-4o et Gemini 2.0 Pro.

Un utilisateur se présentant comme un ancien employé de Meta a affirmé que la direction de l’entreprise aurait intégré des ensembles de tests de divers benchmarks dans le processus de post-entraînement pour gonfler les scores et atteindre des objectifs internes. Cet individu aurait démissionné en raison de ces pratiques, jugeant cette approche inacceptable.

Ahmad Al-Dahle, vice-président de la division Générative AI chez Meta, a fermement nié ces allégations, déclarant que l’entreprise n’a pas entraîné ses modèles sur des ensembles de tests et ne le ferait jamais.

Il a suggéré que les variations de qualité observées pourraient être dues à la nécessité de stabiliser les implémentations.

LMSYS, l’organisation derrière le classement Chatbot Arena, a précisé que le modèle soumis par Meta, nommé « Llama-4-Maverick-03-26-Experimental », était une variante personnalisée optimisée pour les préférences humaines. LMSYS a reconnu que cette information n’avait pas été suffisamment clarifiée par l’équipe de Meta et a annoncé une mise à jour de ses politiques pour renforcer la transparence des évaluations.

Pas simplement Llama 4 : Précédents incidents chez Meta

Ce n’est pas la première fois que Meta est accusée de manipuler des benchmarks. En février, une étude a révélé que plus de 50 % des échantillons de tests de certains benchmarks clés étaient présents dans les données d’entraînement de Llama 1, soulevant des préoccupations quant à la fiabilité des évaluations de performance.

Ces événements soulignent l’importance d’une transparence accrue dans les processus d’évaluation des modèles d’intelligence artificielle pour maintenir la confiance de la communauté scientifique et des utilisateurs.