OpenAI continue d’élargir sa gamme de modèles d’intelligence artificielle avec le lancement officiel de deux nouveaux modèles de raisonnement : o3 et o4-mini.

En décembre 2024, OpenAI avait annoncé o3, son modèle d’IA de raisonnement le plus avancé, et a indiqué que le modèle serait publié après des tests de sécurité appropriés. Il est donc enfin lancé. Au cours de ces quatre mois, OpenAI a encore amélioré le modèle o3 et affirme qu’il s’agit du « modèle de raisonnement le plus puissant » développé par l’entreprise De plus, OpenAI a également publié le modèle de raisonnement de nouvelle génération o4-mini (et o4-mini-high).

Déployés dès aujourd’hui pour les abonnés ChatGPT Plus, Pro et Team, ces modèles se positionnent comme des outils puissants, capables de raisonner en profondeur… et même de « penser avec des images ».

Introducing OpenAI o3 and o 4-mini—our smartest and most capable models to date.

For the first time, our reasoning models can agentically use and combine every tool within ChatGPT, including web search, Python, image analysis, file interpretation, and image generation. pic.twitter.com/rDaqV0x0wE

—OpenAI (@OpenAI) April 16, 2025

o3 : le modèle de raisonnement le plus avancé d’OpenAI

OpenAI présente o3 comme son modèle de raisonnement le plus performant à ce jour, surpassant tous les précédents dans des domaines clés : mathématiques, codage, raisonnement logique, compréhension scientifique et traitement visuel.

Parmi les faits marquants :

- Un score de 69,1 % au test SWE-bench Verified (sans aides personnalisées), l’un des benchmarks les plus exigeants en programmation.

- Intégration native des outils ChatGPT, y compris la navigation web, l’exécution de code Python via Canvas, la génération d’images, et l’analyse d’images.

- Un prix compétitif : 10 dollars par million de tokens en entrée et 40 dollars par million de tokens en sortie (moins cher que GPT-4.5).

OpenAI affirme que o3 établit une nouvelle référence en matière de codage, de mathématiques, de sciences et de tâches visuelles telles que l’analyse d’images, de graphiques et de diagrammes. Les premiers testeurs affirment qu’o3 peut « générer et évaluer de manière critique de nouvelles hypothèses, notamment dans les domaines de la biologie, des mathématiques et de l’ingénierie ».

o4-mini : rapide, léger, mais redoutablement efficace

En revanche, conçu comme une version plus abordable, o4-mini propose un compromis efficacité/vitesse/coût. Il affiche :

- Un score impressionnant de 68,1 % sur SWE-bench Verified, quasi équivalent à o3.

- Une tarification identique à celle de o3-mini : 1,10 dollar en entrée, 4,40 dollars en sortie par million de tokens.

- Une variante o4-mini-high, qui prend plus de temps pour générer ses réponses avec plus de fiabilité.

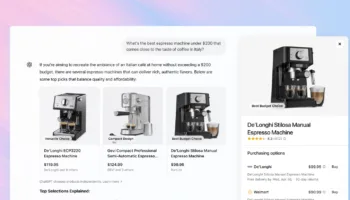

Raisonnement avec images : une nouveauté majeure

Pour la première fois, OpenAI propose des modèles capables de « penser avec des images ». Cela signifie que :

- Vous pouvez téléverser des croquis, schémas, photos floues ou captures de PDF dans ChatGPT.

- L’IA peut analyser visuellement, zoomer, faire pivoter ou interpréter les contenus graphiques comme partie intégrante de sa réflexion.

- C’est un bond en avant pour les usages en éducation, ingénierie, médecine, design ou data science.

Intégration API pour développeurs

Les modèles o3, o4-mini et o4-mini-high sont aussi disponibles via les API Chat Completions et Responses d’OpenAI, permettant aux développeurs d’intégrer ces IA dans leurs propres apps et services.

Et la suite ?

OpenAI prévoit de lancer o3-pro dans les semaines à venir : une version plus gourmande en ressources, réservée aux abonnés ChatGPT Pro. Sam Altman a annoncé que ces modèles pourraient être les derniers modèles de raisonnement autonomes avant l’arrivée de GPT-5, censé unifier la série GPT-4.1 et les modèles de raisonnement.

Avec o3 et o4-mini, OpenAI confirme sa place de leader dans la course mondiale à l’IA face à Google (Gemini), Meta (LLaMA), xAI (Grok), Anthropic (Claude 3) ou encore DeepSeek. Ces nouveaux modèles marquent une avancée majeure, non seulement par leur puissance de raisonnement, mais aussi par leur capacité à analyser des images et à exécuter du code en temps réel.

Les annonces d’hier font suite à la présentation par OpenAI de son modèle d’IA phare GPT-4.1, le successeur de GPT-4o, lundi dernier.