OpenAI fait face à un problème préoccupant avec ses derniers modèles d’IA de raisonnement, o3 et o4-mini. Alors que ces nouveaux modèles étaient censés représenter une avancée significative en matière d’intelligence artificielle, ils se révèlent être plus sujets aux hallucinations que leurs prédécesseurs — un phénomène qui soulève de nombreuses inquiétudes au sein de l’industrie.

Contrairement aux attentes habituelles selon lesquelles chaque nouvelle génération de modèle améliore la précision des réponses et réduit les erreurs, les modèles o3 et o4-mini d’OpenAI semblent aller à contre-courant. Dans un rapport technique publié récemment, OpenAI reconnaît que o3, en particulier, fait plus de déclarations que les modèles précédents. Cela se traduit par plus de bonnes réponses, mais aussi plus de réponses erronées ou inventées.

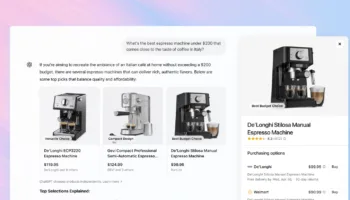

Le modèle o4-mini, plus petit, affiche des performances inférieures sur le benchmark PersonQA, une évaluation conçue pour mesurer la précision et détecter les hallucinations à partir d’un jeu de données basé sur des faits publics. Moins performant que o1 et o3, cela reste toutefois logique, car les petits modèles disposent de moins de “connaissances du monde”.

OpenAI : Une crise à l’échelle de l’industrie

Le problème des hallucinations ne se limite pas à OpenAI. L’ensemble de l’industrie de l’IA générative est confronté à ce défi. Déjà en 2023, Sundar Pichai (PDG de Google) admettait qu’aucun modèle n’avait encore résolu ce problème de manière satisfaisante. Selon lui, les hallucinations sont “attendues” et aucune solution complète n’existe pour l’instant.

Même discours du côté d’Apple. Tim Cook a été clair : malgré les efforts, il ne garantit pas une fiabilité totale des réponses générées par l’IA d’Apple. “Je ne dirai jamais que c’est fiable à 100 %”, a-t-il déclaré, tout en assurant que ses équipes ont pris “toutes les précautions connues à ce jour”.

Pour des analystes comme Arun Chandrasekaran (Gartner), l’industrie s’approche du fameux “creux de la désillusion” : une période où les attentes élevées, les coûts exponentiels et les limites techniques non résolues risquent de provoquer une perte de confiance dans les technologies d’IA générative. « Ce n’est pas que la technologie est mauvaise, mais elle ne peut pas suivre les attentes énormes qui ont été créées », explique-t-il. Selon lui, le problème des hallucinations est l’un des plus préoccupants, car aucune solution robuste n’a encore été trouvée.

Un futur prometteur… mais à long terme

Malgré tout, les experts ne remettent pas en cause le potentiel à long terme de l’intelligence artificielle générative. Ce qu’ils remettent en question, c’est le calendrier et la maturité de la technologie dans le court terme.

Le cas des modèles o3 et o4-mini d’OpenAI, avec leurs hallucinations plus fréquentes, en est un exemple flagrant. Cela montre que même les acteurs les plus avancés peinent à stabiliser leurs modèles les plus ambitieux. Pour l’instant, il reste donc essentiel de garder une approche critique vis-à-vis des réponses générées par ces IA, en particulier dans les cas d’usages professionnels ou sensibles.