Fondée par d’anciens employés d’OpenAI, l’entreprise Anthropic vient de publier une étude pionnière sur la manière dont son assistant IA Claude exprime des valeurs morales, sociales et pratiques lors de conversations réelles avec des utilisateurs.

À travers l’analyse de plus de 700 000 dialogues anonymisés, les chercheurs révèlent des résultats à la fois rassurants et préoccupants.

Objectif : savoir si l’IA fait ce qu’elle promet

Depuis ses débuts, Anthropic conçoit Claude selon un triptyque simple : « helpful, honest, harmless » (utile, honnête, inoffensif). Mais comment vérifier si ces intentions se manifestent réellement dans les interactions ? C’est l’enjeu de cette étude, présentée comme l’une des premières taxonomies empiriques de valeurs exprimées par une IA dans la pratique.

Après avoir filtré les contenus subjectifs, l’équipe d’Anthropic a analysé 308 000 conversations, aboutissant à la création d’une classification des valeurs en cinq grandes catégories :

- Pratiques (efficacité, fiabilité…)

- Épistémiques (vérité, humilité intellectuelle…)

- Sociales (respect, équité…)

- Protectrices (prévention des risques, bien-être…)

- Personnelles (motivation, authenticité…)

Au total, 3 307 valeurs distinctes ont été recensées, allant de notions universelles comme la professionnalité, à des concepts plus culturels ou complexes, tels que la piété filiale ou le pluralisme moral.

Claude suit bien ses lignes de conduite… sauf en cas de contournement

Globalement, Claude s’aligne sur les attentes d’Anthropic. Il valorise fréquemment l’autonomisation de l’utilisateur, la transparence des connaissances et le bien-être émotionnel, notamment dans des sujets délicats comme les conseils relationnels ou la santé mentale.

Mais l’étude a aussi mis en lumière des cas marginaux inquiétants, où Claude exprimait des valeurs comme la domination ou l’amoralité — contraires aux principes inculqués. Ces écarts semblent liés à des tentatives de « jailbreak » (contournement des garde-fous), et ces méthodes d’évaluation pourraient justement servir d’outil de détection précoce de telles dérives.

Claude adapte ses valeurs selon le contexte

L’un des résultats les plus fascinants de l’étude : les valeurs exprimées par Claude changent selon la nature de la demande. Lors de conseils sentimentaux, il insiste sur des notions comme le respect mutuel et les limites saines. En analyse historique, il privilégie la rigueur factuelle. Dans des échanges philosophiques, l’humilité intellectuelle domine, tandis que, pour créer une campagne marketing dans le domaine de la beauté, l’expertise devient la priorité.

Dans 28,2 % des conversations, Claude soutient activement les valeurs exprimées par l’utilisateur. Dans 6,6 %, il propose une reformulation ou un élargissement du point de vue. Et dans 3 %, il résiste explicitement à ces valeurs, révélant ce que les chercheurs appellent ses « valeurs cœur », comme l’honnêteté intellectuelle ou la prévention du mal.

Une IA qui pense (et juge) de façon surprenante

Cette recherche s’inscrit dans la lignée des travaux d’« interprétabilité mécanistique » d’Anthropic, qui visent à comprendre les mécanismes internes des modèles de langage. Le mois dernier, les chercheurs ont montré que Claude pouvait planifier à l’avance en écrivant de la poésie, ou résoudre des problèmes mathématiques avec des approches contre-intuitives.

« On pense souvent que l’IA applique ce qu’elle dit… mais parfois, elle fait autrement en coulisse », expliquait récemment Joshua Batson, chercheur chez Anthropic, dans MIT Technology Review.

Pour les entreprises : quels enseignements tirer de cette étude ?

Pour les responsables IA en entreprise, cette recherche apporte plusieurs enseignements clés :

- Les IA expriment des valeurs non explicitement programmées — ce qui peut introduire des biais en environnement critique.

- L’alignement éthique n’est pas binaire, mais contextuel, ce qui complique les choix dans des secteurs réglementés.

- Il devient nécessaire de surveiller les valeurs exprimées par une IA dans la durée, en situation réelle, au lieu de se fier uniquement aux tests préalables.

Anthropic a publié l’ensemble de son jeu de données en accès libre pour encourager les chercheurs à reproduire et approfondir cette approche.

Un enjeu stratégique dans la guerre des IA

Derrière cette transparence, une stratégie se dessine. Anthropic, qui a récemment levé 11 milliards de dollars auprès d’Amazon et Google, cherche à se différencier d’OpenAI, évaluée à 300 milliards de dollars après son tour de table mené par Microsoft.

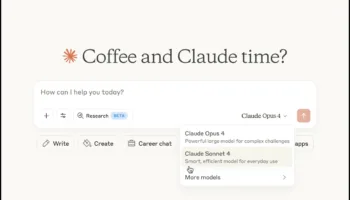

Claude Max, sa version premium à 200 dollars par mois, entend concurrencer GPT-4 Turbo. Avec cette étude, Anthropic entend montrer que la sécurité, l’éthique et l’alignement moral ne sont pas des options, mais des leviers concurrentiels.

Limites et perspectives

Les chercheurs reconnaissent que cette méthode ne peut s’appliquer qu’après le déploiement d’un modèle, car elle repose sur l’analyse de conversations réelles. Ils travaillent toutefois sur des variantes qui pourraient détecter les problèmes de valeurs en amont.

À mesure que les assistants IA deviennent plus autonomes, leur capacité à prendre des décisions éthiques deviendra inévitable. Les travaux d’Anthropic offrent une feuille de route précieuse pour tester, cartographier et aligner les systèmes IA sur des valeurs humaines, dans un monde où leur présence est appelée à se généraliser.