Apple a présenté une liste exhaustive de nouvelles fonctionnalités conçues pour aider les parents à protéger leurs enfants contre les contenus potentiellement explicites et dangereux, ainsi que pour réduire les chances qu’un prédateur puisse contacter un enfant avec des contenus dangereux. Les nouvelles fonctionnalités couvrent les messages, Siri et la recherche, offrant des choses comme l’analyse par l’IA des images entrantes et sortantes.

En effet, Apple vient de confirmer ses plans précédemment rapportés pour déployer une nouvelle technologie au sein d’iOS, macOS, watchOS et iMessage qui détectera les images potentielles d’abus d’enfants, mais a clarifié des détails cruciaux du projet en cours. Pour les appareils aux États-Unis, les nouvelles versions d’iOS et d’iPadOS qui seront déployées cet automne comportent « de nouvelles applications de la cryptographie pour aider à limiter la propagation du CSAM [matériel pédopornographique] en ligne, tout en respectant la vie privée des utilisateurs ».

Le projet est également détaillé dans une nouvelle page « Sécurité des enfants » sur le site Web d’Apple. La mise en œuvre la plus invasive et potentiellement controversée est le système qui effectue un balayage sur l’appareil avant qu’une image ne soit sauvegardée dans iCloud. D’après la description, le balayage ne se produit pas avant qu’un fichier ne soit sauvegardé sur iCloud, et Apple ne reçoit des données sur une correspondance que si les pièces justificatives cryptographiques (téléchargées sur iCloud avec l’image) pour un compte particulier atteignent un seuil de correspondance avec des CSAM connus.

Depuis des années, Apple utilise des systèmes de hachage pour rechercher les images d’abus d’enfants envoyées par e-mail, à l’instar des systèmes analogues de Gmail et d’autres fournisseurs de courrier électronique sur le cloud. Le programme annoncé aujourd’hui appliquera les mêmes analyses aux images des utilisateurs stockées dans iCloud Photos, même si ces images ne sont jamais envoyées à un autre utilisateur ou partagées d’une autre manière.

Dans un document PDF fourni avec l’annonce, Apple a justifié sa décision de numériser les images en décrivant plusieurs restrictions visant à protéger la vie privée.

Quelques garanties

Les nouveaux détails s’appuient sur les préoccupations divulguées plus tôt cette semaine, mais ajoutent également un certain nombre de garanties qui devraient permettre de se prémunir contre les risques d’atteinte à la vie privée d’un tel système. En particulier, le système de seuil garantit que les erreurs isolées ne généreront pas d’alertes, ce qui permet à Apple de viser un taux d’erreur d’une fausse alerte par trillion d’utilisateurs par an. Le système de hachage est également limité au matériel signalé par le National Center for Missing and Exploited Children (NCMEC) et aux images téléchargées sur iCloud Photos. Une fois qu’une alerte est générée, elle est examinée par Apple et le NCMEC avant d’alerter les forces de l’ordre, ce qui constitue une garantie supplémentaire contre l’utilisation du système pour détecter des contenus non-CSAM. En outre, Apple a commandé des évaluations techniques du système à trois cryptographes indépendants, qui l’ont trouvé mathématiquement robuste.

Cependant, Apple a déclaré que d’autres groupes de sécurité des enfants étaient susceptibles d’être ajoutés en tant que sources de hachage à mesure que le programme se développe, et la société ne s’est pas engagée à rendre la liste des partenaires publiquement disponible à l’avenir. Cela risque de renforcer les inquiétudes quant à la façon dont le système pourrait être exploité par le gouvernement chinois, qui cherche depuis longtemps à obtenir un meilleur accès aux données des utilisateurs d’iPhone dans le pays.

Alerter aussi les parents

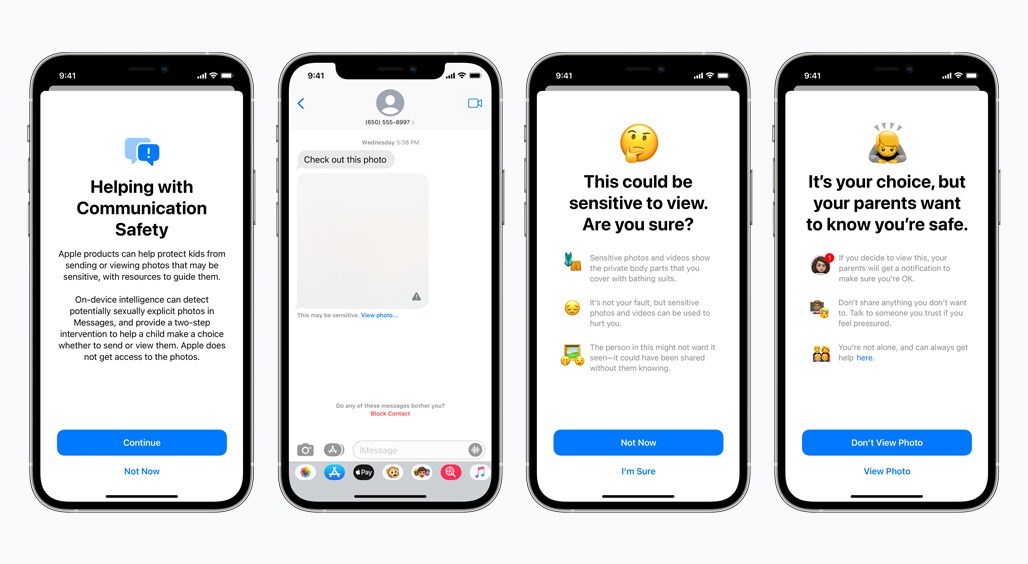

En plus des nouvelles mesures dans iCloud Photos, Apple a ajouté deux systèmes supplémentaires pour protéger les jeunes propriétaires d’iPhone qui risquent d’être victimes d’abus sexuels. L’application Messages analysait déjà sur l’appareil les pièces jointes des images des comptes d’enfants pour détecter les contenus potentiellement sexuellement explicites. Une fois détecté, le contenu est flouté et un avertissement apparaît. Un nouveau paramètre que les parents peuvent activer sur leurs comptes iCloud familiaux déclenchera un message indiquant à l’enfant que s’il visualise (en entrée) ou envoie (en sortie) l’image détectée, ses parents recevront un message à ce sujet.

Apple met également à jour la façon dont Siri et l’application de recherche répondent aux requêtes concernant les images d’abus d’enfants. Dans le cadre du nouveau système, les applications « expliqueront aux utilisateurs que l’intérêt pour ce sujet est nuisible et problématique, et fourniront des ressources de partenaires pour obtenir de l’aide sur ce sujet ».

Apple indique que ses nouvelles fonctions de sécurité pour les enfants seront disponibles pour les utilisateurs avec les mises à jour d’iOS 15, iPadOS 15, watchOS 8 et macOS Monterey dont la sortie est prévue plus tard cette année. Elle sera uniquement disponible outre-Atlantique.