Si vous suivez le monde de l’intelligence artificielle (IA), vous vivez une époque excitante. ChatGPT envahit le monde, Microsoft ajoute sa technologie à Bing, et Google travaille sur sa propre IA appelée Bard. Sauf que Bard n’est peut-être pas tout à fait prêt pour le prime time — et Google vient de le prouver lors de sa propre démonstration technologique. Oups.

En début de semaine, Microsoft a organisé un événement surprise sur l’IA au cours duquel il a fait une démonstration en direct de son moteur de recherche Bing alimenté par l’IA. Pour ne pas être en reste, Google a publié sur Twitter une démonstration de son propre chatbot d’IA. Cependant, les choses ne se sont pas passées exactement comme prévu.

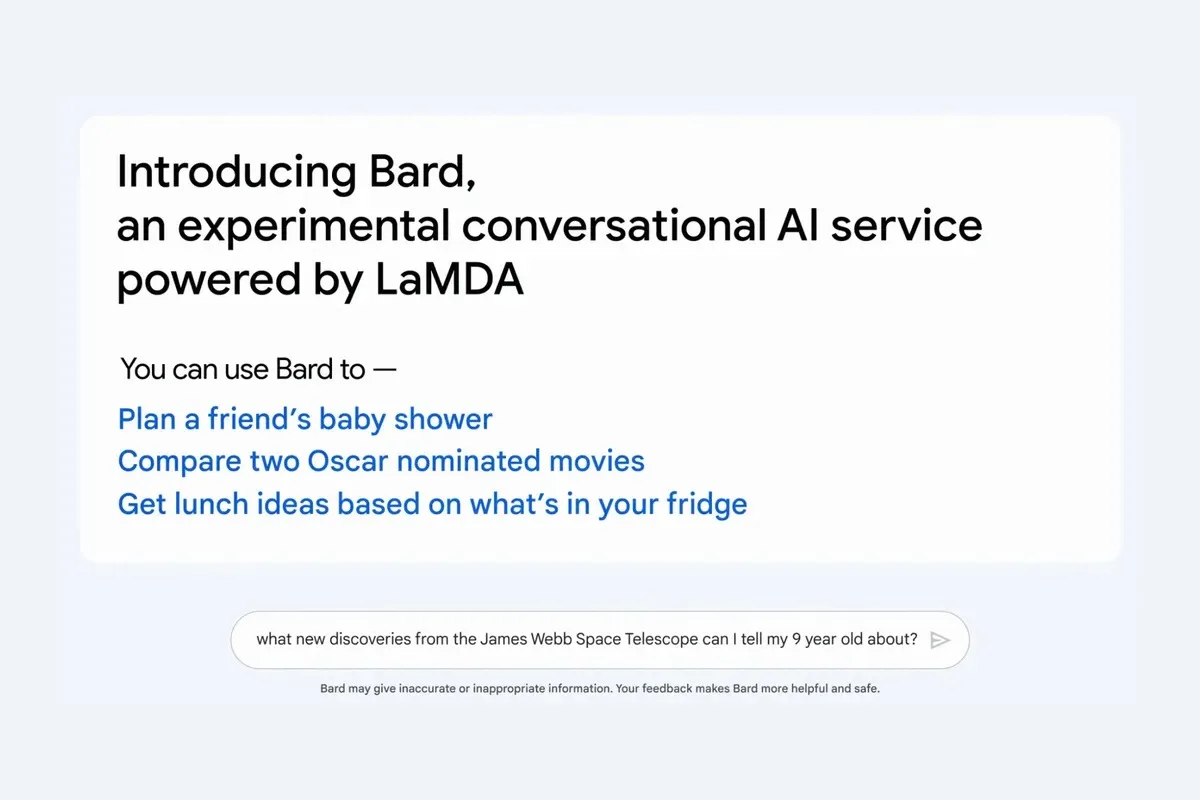

Ce n’est un secret pour personne que la popularité écrasante de ChatGPT inquiète Google. Pour lutter contre cette menace, Google a dévoilé son propre chatbot IA, Bard. Cet outil peut produire des réponses intelligentes à des requêtes en langage naturel en utilisant des informations extraites d’Internet.

Un jour après la démonstration en direct de Bing alimenté par l’IA de Microsoft, Google a publié sur Twitter un GIF montrant son nouvel outil d’IA en action. Le GIF montre Bard répondant à la question « Quelles sont les nouvelles découvertes du télescope spatial James Webb dont je peux parler à mon enfant de 9 ans ? ». Bard fournit ensuite une liste à puces de réponses.

Bard is an experimental conversational AI service, powered by LaMDA. Built using our large language models and drawing on information from the web, it’s a launchpad for curiosity and can help simplify complex topics → https://t.co/fSp531xKy3 pic.twitter.com/JecHXVmt8l

— Google (@Google) February 6, 2023

Dans le dernier point, il est dit que « le JWST a pris les toutes premières photos d’une planète en dehors de notre propre système solaire ». Sur Twitter, les astronomes ont rapidement fait remarquer que cette information était fausse. L’astrophysicien Grant Tremblay a ensuite cité la publication en expliquant que la première image d’une planète en dehors de notre système solaire a été prise en 2004 — c’est-à-dire avant la création du télescope spatial James Webb.

Not to be a ~well, actually~ jerk, and I’m sure Bard will be impressive, but for the record: JWST did not take « the very first image of a planet outside our solar system ».

the first image was instead done by Chauvin et al. (2004) with the VLT/NACO using adaptive optics. https://t.co/bSBb5TOeUW pic.twitter.com/KnrZ1SSz7h

— Grant Tremblay (@astrogrant) February 7, 2023

Les actions de Google ont chuté

Si cette gaffe peut être un moment drôle pour certains sur les réseaux sociaux, Google, lui, ne fait que rire. Peu de temps après la diffusion de l’erreur, les actions de la société mère de Google — Alphabet — auraient chuté de 8 %, selon Reuters. Cela a entraîné une perte de plus de 100 milliards de dollars en valeur boursière.

Il n’est pas rare que des outils d’IA comme Bard et ChatGPT fassent des erreurs factuelles, car ils tirent des informations d’Internet plutôt que d’une base de données vérifiée. Le problème, c’est que ces systèmes présentent les informations d’une manière qui fait autorité et vous fait croire que les réponses sont vraies.

Microsoft s’est protégée de manière préventive contre la responsabilité qui en découle en faisant porter la charge sur l’utilisateur. C’est ce qu’indique sa clause de non-responsabilité : « Bing est alimenté par l’IA, des surprises et des erreurs sont donc possibles. Assurez-vous de vérifier les faits, et partagez vos commentaires afin que nous puissions apprendre et nous améliorer ! ».

L’IA a encore besoin de progresser

En réponse à cet incident, un porte-parole de Google a déclaré à The Verge :

Cela souligne l’importance d’un processus de test rigoureux, quelque chose que nous lançons cette semaine avec notre programme Trusted Tester. Nous combinerons les commentaires externes avec nos propres tests internes pour nous assurer que les réponses de Bard répondent à des critères élevés de qualité, de sécurité et d’ancrage dans des informations du monde réel.

Dans un tweet de suivi, Tremblay mentionne : « Mais, ChatGPT, etc., bien qu’impressionnant de manière effrayante, est souvent faux de manière *très sûre*. Il sera intéressant de voir un avenir où les LLM vérifient eux-mêmes les erreurs ». Reste à savoir si cet incident convaincra ces entreprises de mettre en place une assurance qualité par le biais de contrôles d’erreurs.

Les IA de recherche ont manifestement besoin de beaucoup de travail avant de pouvoir être traitées avec plus qu’un iota de confiance. Google affirme lui-même qu’il ne publiera pas Bard tant qu’il n’aura pas atteint un « niveau élevé de sécurité ». Il est clair que le chemin à parcourir est encore long.