ChatGPT est devenu une célébrité virale au cours des 6 derniers mois, mais il n’est pas sorti de nulle part. Selon un article de blog publié par Microsoft lundi, OpenAI, la société à l’origine de ChatGPT, a contacté Microsoft pour construire une infrastructure d’IA sur des milliers de GPU NVIDIA il y a plus de 5 ans.

Le partenariat entre OpenAI et Microsoft a fait couler beaucoup d’encre ces derniers temps, notamment après que Microsoft a investi 10 milliards de dollars dans le groupe de recherche à l’origine d’outils tels que ChatGPT et DALL-E 2. Depuis lors, Bloomberg rapporte que Microsoft a dépensé « plusieurs centaines de millions de dollars » pour développer l’infrastructure nécessaire à ChatGPT et à des projets tels que Bing Chat.

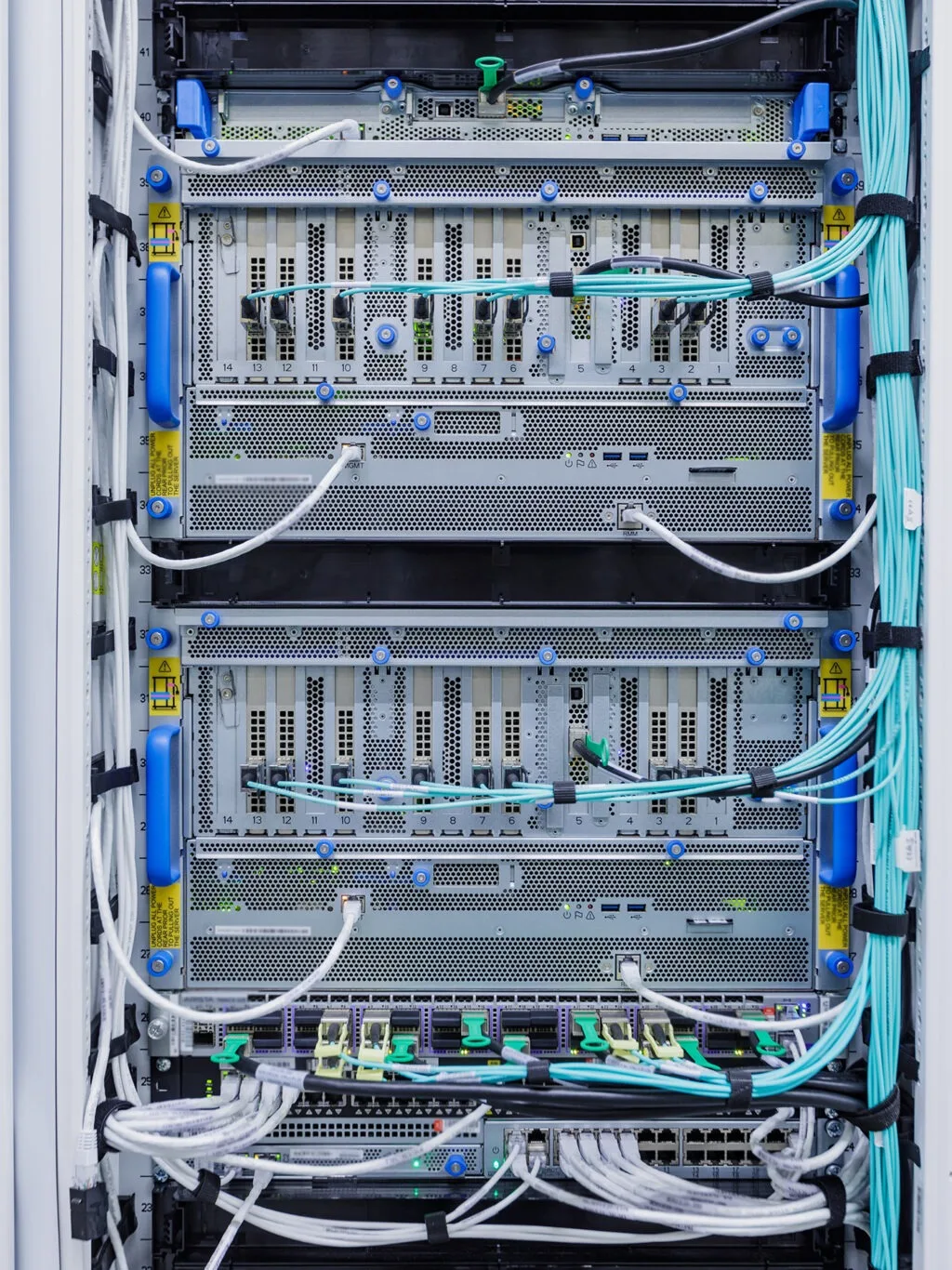

Une grande partie de cet argent est allée à NVIDIA, qui est désormais à la pointe du matériel informatique nécessaire à l’entraînement des modèles d’IA. Au lieu de choisir des GPU pour les jeux, comme ceux que l’on trouve dans les listes des meilleures cartes graphiques, Microsoft a choisi les GPU d’entreprise de NVIDIA, tels que les A100 et H100.

Mais, il ne s’agit pas simplement de réunir des cartes graphiques et d’entraîner un modèle de langage. Comme l’explique Nidhi Chappell, responsable des produits Microsoft pour Azure : « Il ne suffit pas d’acheter un tas de GPU, de les brancher ensemble et ils commenceront à travailler ensemble. Il y a beaucoup d’optimisation au niveau du système pour obtenir les meilleures performances, et cela vient avec beaucoup d’expérience sur plusieurs générations ». « L’une des choses que nous avons apprises de la recherche est que plus le modèle est grand, plus vous avez de données et plus vous pouvez vous entraîner longtemps, meilleure est la précision du modèle », a-t-il poursuivi.

NVIDIA s’est avéré être un puissant allié, avec sa technologie remarquable pour donner vie aux massifs processus nécessaires à l’entraînement d’Azure et de ChatGPT. L’équipe a récolté les fruits de son travail après l’introduction réussie de sa technologie et de la fameuse IA. L’infrastructure étant en place, Microsoft ouvre maintenant son matériel à d’autres. La société a annoncé lundi, dans un autre article de blog, qu’elle proposerait des systèmes NVIDIA H100 « à la demande dans des tailles allant de 8 à des milliers de GPU Nvidia H100 », livrés depuis le réseau Azure de Microsoft.

Microsoft et NVIDIA les grands gagnants !

La popularité de ChatGPT a fait monter en flèche NVIDIA, qui investit dans l’IA par le biais de matériel et de logiciels depuis plusieurs années. AMD, le principal concurrent de NVIDIA dans le domaine des cartes graphiques pour les jeux, a tenté de s’imposer dans ce secteur avec des accélérateurs tels que l’Instinct MI300.

Selon Greg Brockman, président et cofondateur d’OpenAI, la formation au ChatGPT n’aurait pas été possible sans la puissance fournie par Microsoft : « La co-conception de supercalculateurs avec Azure a été cruciale pour la mise à l’échelle de nos besoins exigeants en matière de formation à l’IA, rendant possible notre travail de recherche et d’alignement sur des systèmes tels que ChatGPT ».

NVIDIA devrait en dire plus sur ses futurs produits d’IA lors de la conférence sur la technologie des GPU (GTC), dont le coup d’envoi sera donné le 21 mars. Microsoft va également élargir sa feuille de route en matière d’IA dans le courant de la semaine, avec une présentation axée sur l’avenir de l’IA sur le lieu de travail prévue pour le 16 mars.