Ces derniers temps, tout le monde ne parle que de ChatGPT. Alimenté par le modèle linguistique GPT 3 et GPT 3.5 (pour les abonnés Plus), le chatbot d’IA s’est développé à pas de géant dans ce qu’il peut faire. Cependant, de nombreuses personnes attendaient avec impatience un modèle mis à jour qui repousse les limites. OpenAI a fait de cette attente une réalité avec GPT-4, son dernier LLM multimodal, qui regorge d’améliorations et de technologies sans précédent dans le domaine de l’IA.

Announcing GPT-4, a large multimodal model, with our best-ever results on capabilities and alignment: https://t.co/TwLFssyALF pic.twitter.com/lYWwPjZbSg

— OpenAI (@OpenAI) March 14, 2023

Le modèle GPT-4 récemment annoncé par OpenAI est une grande nouveauté dans le domaine de l’intelligence artificielle. Le plus important est que le GPT-4 est un grand modèle multimodal. Cela signifie qu’il sera capable d’accepter des images et des textes, ce qui lui permettra de mieux comprendre les choses. OpenAI indique que même si le nouveau modèle est moins performant que les humains dans de nombreux scénarios du monde réel, il peut encore afficher des performances de niveau humain à différents niveaux.

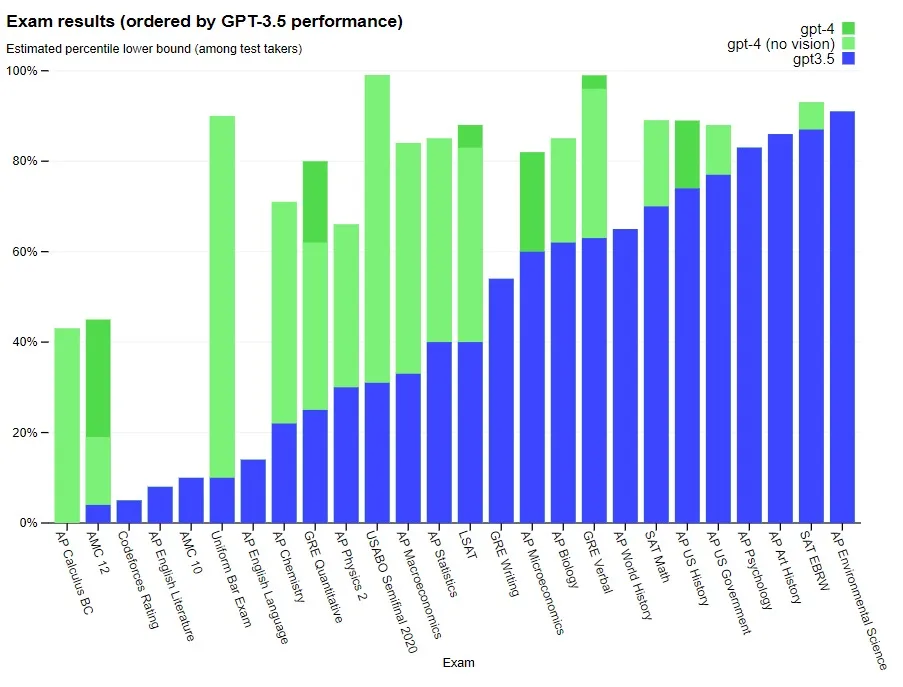

GPT-4 est également considéré comme un modèle plus fiable, plus créatif et plus efficace que son prédécesseur GPT-3.5. Par exemple : le nouveau modèle a pu réussir un examen du barreau simulé avec un score avoisinant les 10 % des candidats les plus performants, alors que le GPT 3.5 s’est classé dans les 10 % les moins performants. GPT-4 est également capable de traiter des instructions plus nuancées que le modèle 3.5. OpenAI a comparé les deux modèles dans le cadre d’une série de tests de référence et d’examens, et c’est le modèle GPT-4 qui est arrivé en tête. Découvrez ici tout ce que ChatGPT peut faire de génial.

GPT-4 a été développé sur une période de six mois et a été entraîné sur les supercalculateurs Microsoft Azure AI. OpenAI affirme que cette formation a rendu le modèle « plus sûr et mieux aligné », puisqu’il est 82 % moins susceptible de répondre à des messages à contenu négatif et 40 % plus susceptible de générer des informations souhaitées.

GPT-4 et entrées visuelles

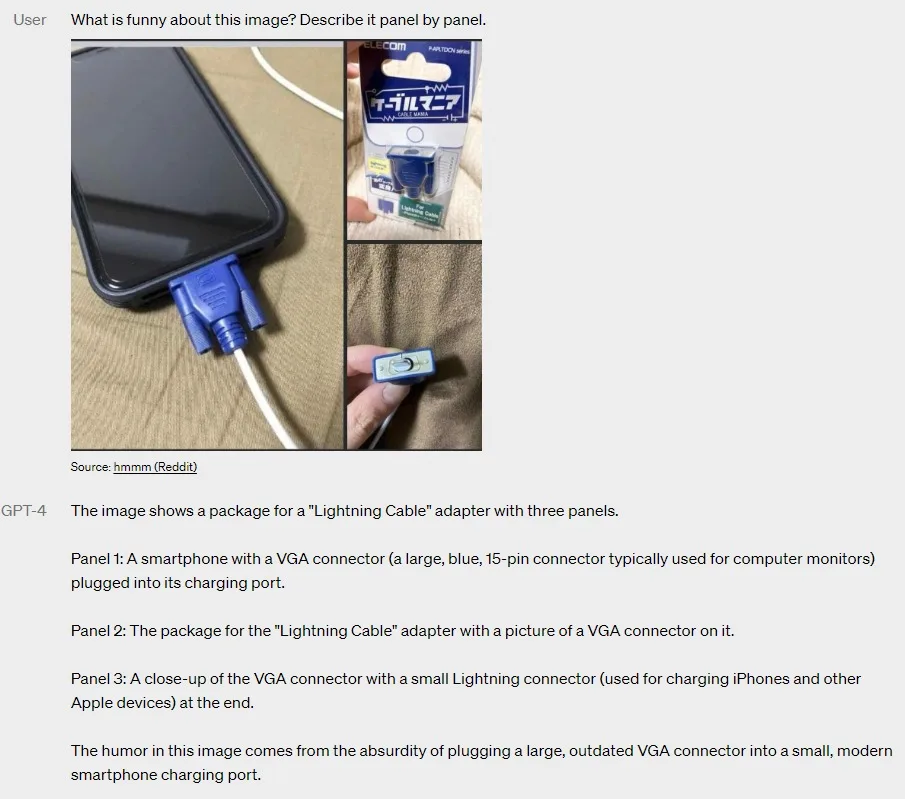

Comme mentionné ci-dessus, le nouveau modèle peut accepter des textes et des images. Par rapport à une entrée textuelle restreinte, GPT-4 comprendra beaucoup mieux les entrées qui contiennent à la fois du texte et des images. Les entrées visuelles restent cohérentes pour divers documents, y compris le texte et les photos, les diagrammes et même les captures d’écran.

OpenAI en a fait la démonstration en donnant à GPT-4 une image et une invite textuelle lui demandant de décrire ce qui est drôle dans cette image. Comme on peut le voir ci-dessus, le modèle a réussi à lire une image aléatoire tirée de Reddit et à répondre à l’invite de l’utilisateur. Il a ensuite pu identifier l’élément humoristique. Toutefois, les données d’entrée de GPT-4 ne sont pas encore accessibles au public et sont encore à l’état de projet de recherche.

Une tendance à l’hallucination et des données limitées

Bien que GPT-4 représente un progrès considérable par rapport à sa précédente itération, certains problèmes subsistent. Pour commencer, OpenAI indique qu’elle n’est pas encore totalement fiable et qu’elle est sujette aux hallucinations. Cela signifie que l’IA commettra des erreurs de raisonnement et que ses résultats doivent être pris avec beaucoup de précautions et avec l’intervention d’un être humain. Elle peut également se tromper en toute confiance dans ses prédictions, ce qui peut entraîner des erreurs. Cependant, GPT-4 réduit les hallucinations par rapport aux modèles précédents. Plus précisément, le nouveau modèle obtient un score supérieur de 40 % à celui du GPT-3.5 dans les évaluations de l’entreprise.

Un autre inconvénient que beaucoup espéraient voir disparaître avec GPT-4 est l’ensemble limité de données. Malheureusement, GPT-4 ne tient toujours pas compte des événements survenus après septembre 2021, ce qui est décevant. Il ne tire pas non plus de leçons de son expérience, ce qui se traduit par les erreurs de raisonnement mentionnées ci-dessus. En outre, GPT-4 peut échouer dans des problèmes difficiles, tout comme les humains, y compris les vulnérabilités en matière de sécurité. Mais, il n’y a pas lieu de s’inquiéter, car l’IA de Bing utilise le modèle GPT-4. Vous pouvez donc essayer le nouveau modèle d’IA, en vous appuyant sur les données Internet en temps réel de Bing.

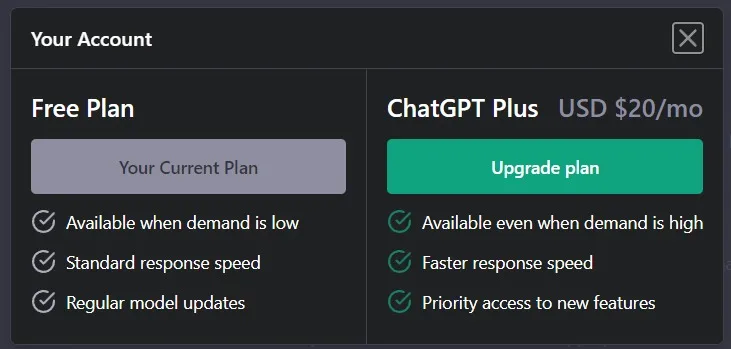

Accéder à GPT-4 avec ChatGPT Plus

GPT-4 est disponible pour les abonnés de ChatGPT Plus avec un plafond d’utilisation. OpenAI indique qu’elle ajustera le plafond d’utilisation exact en fonction de la demande et des performances du système. En outre, la société pourrait même introduire un « nouveau niveau d’abonnement » pour une utilisation plus importante de GPT-4. Les utilisateurs gratuits, quant à eux, devront attendre, car la société n’a pas mentionné de plans spécifiques et espère seulement pouvoir offrir un certain nombre de requêtes GPT-4 gratuites à ceux qui n’ont pas souscrit d’abonnement.

D’après ce que l’on peut voir, GPT-4 sera un modèle linguistique extrêmement attrayant, même s’il a quelques faiblesses dans son armure.