Google a donné le coup d’envoi de sa conférence annuelle I/O en mettant l’accent sur les mesures prises pour faire progresser l’intelligence artificielle (IA) dans l’ensemble de son domaine.

La Google I/O est depuis longtemps la principale conférence de Google à l’intention des développeurs, qui aborde un grand nombre de sujets différents. Mais 2023 est différent : l’IA domine presque tous les aspects de l’événement. Cette année, Google tente d’asseoir sa position de leader sur le marché de l’IA, alors que ses rivaux Microsoft et OpenAI profitent du succès fulgurant de ChatGPT.

Les efforts de Google reposent sur son nouveau modèle de langage PaLM 2, qui servira à alimenter au moins 25 produits et services Google présentés lors des sessions de la conférence I/O, notamment Bard, Workspace, Cloud, Security et Vertex AI.

Le PaLM original (abréviation de Pathways Language Model) a été lancé en avril 2022 en tant que première itération de la LLM de base de Google pour l’IA générative. Google affirme que PaLM 2 élargit considérablement les capacités de l’entreprise en matière d’IA générative.

Avec PaLM 2, l’IA de pointe est au cœur des mains des développeurs

PaLM 2 est un modèle linguistique de pointe qui est performant en mathématiques, en codage, en raisonnement, en traduction multilingue et en génération de langage naturel.

Google a insisté sur le fait qu’il est meilleur que les précédents LLM du géant de la recherche dans presque tous les domaines qui peuvent être mesurés. Cela dit, l’une des façons dont les modèles précédents étaient mesurés était le nombre de paramètres. Par exemple, en 2022, lorsque la première itération de PaLM a été lancée, Google a affirmé que son plus grand modèle comportait 540 milliards de paramètres. Malheureusement, pour PaLM 2, la firme se contente de noter que le comptage des paramètres n’est pas un moyen idéal de mesurer les performances ou les capacités.

Elle a plutôt déclaré que le modèle a été entraîné et construit de manière à l’améliorer. Google a entraîné PaLM 2 sur la dernière infrastructure Tensor Processing Unit (TPU), qui est la puce personnalisée de Google pour l’entraînement à l’apprentissage machine (ML).

En ce qui concerne les capacités de base améliorées de PaLM 2, en voici trois :

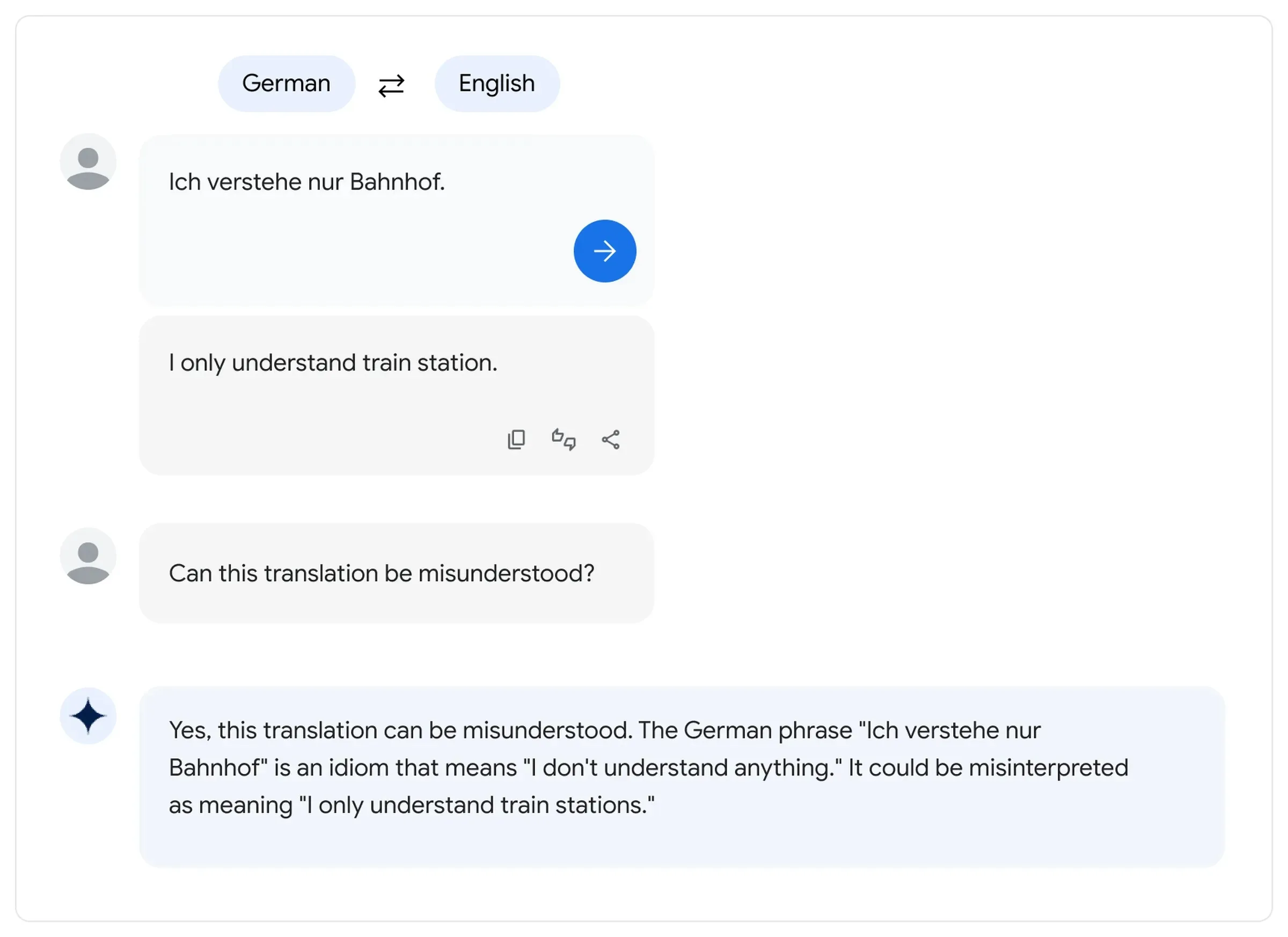

- Multilingualité : Le nouveau modèle a été entraîné sur plus de 100 langues parlées, ce qui permet à PaLM 2 d’exceller dans les tâches multilingues. Pour aller plus loin, Google a précisé qu’il pouvait comprendre des phrases nuancées dans différentes langues, y compris l’utilisation d’un sens ambigu ou figuré des mots plutôt que leur sens littéral

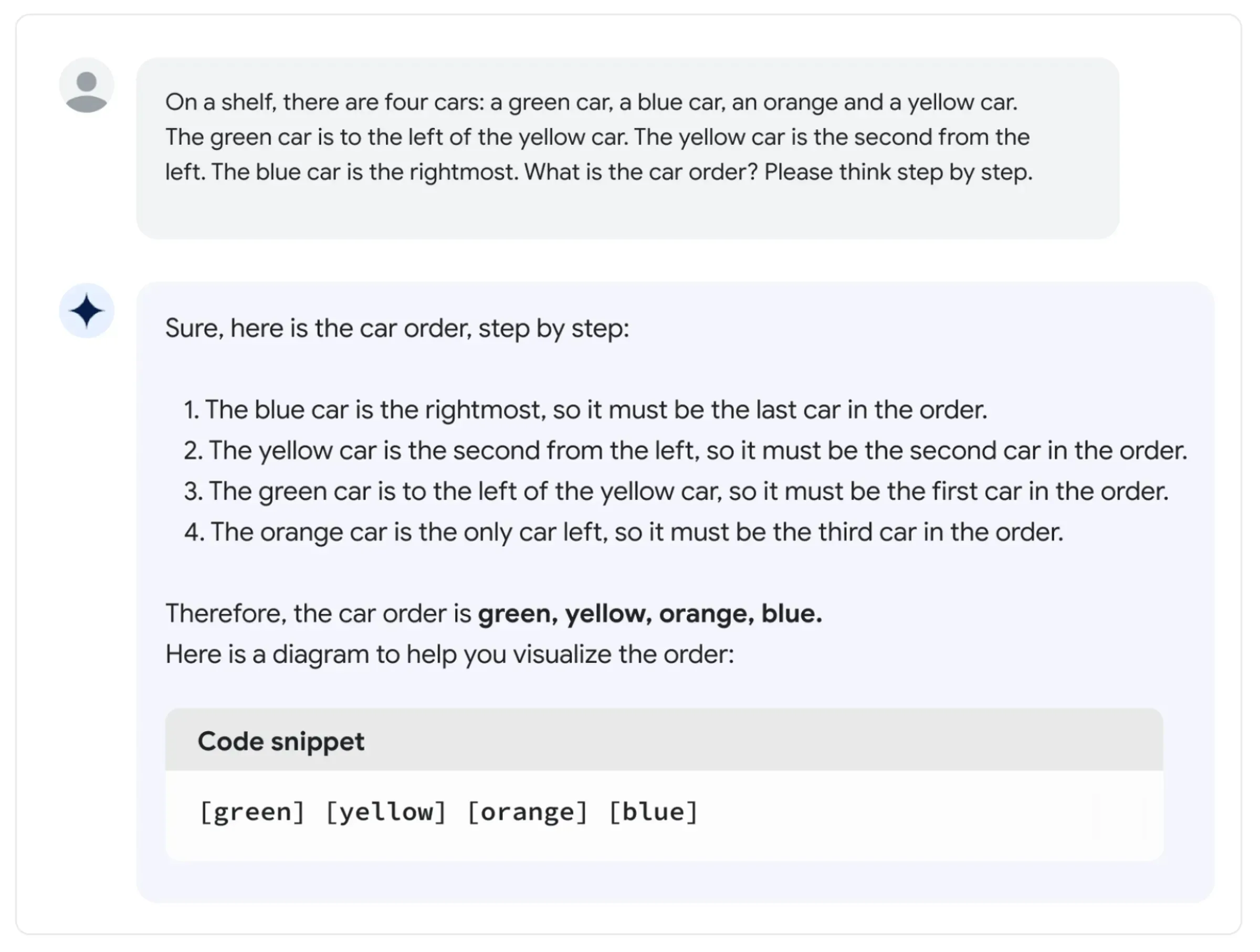

- Raisonnement : PaLM 2 offre une logique, un raisonnement de bon sens et des mathématiques plus solides que les précédents modèles

- Codage : PaLM 2 comprend, génère et débogue également du code et a été formé à plus de 20 langages de programmation. Outre les langages de programmation populaires tels que Python et JavaScript, PaLM 2 peut également utiliser des langages plus anciens tels que Fortran

PaLM 2 est un modèle qui alimente 25 applications de Google, dont Bard

PaLM 2 peut s’adapter à un large éventail de tâches et, lors de la conférence Google I/O, l’entreprise a expliqué en détail comment il prend en charge 25 produits qui ont un impact sur pratiquement tous les aspects de l’expérience de l’utilisateur.

En s’appuyant sur le PaLM 2 à usage général, Google a également développé le Med-PaLM 2, un modèle destiné à la profession médicale. Pour les cas d’utilisation liés à la sécurité, Google a formé Sec-PaLM. Bard, le concurrent de Google pour ChatGPT, bénéficiera également de la puissance de PaLM 2, qui offre une interface utilisateur intuitive basée sur des invites que tout le monde peut utiliser, quelles que soient ses compétences techniques. La suite d’applications de productivité Workspace de Google bénéficiera également d’une amélioration de l’intelligence, grâce à PaLM 2.