Un chercheur a découvert une grave faille dans ChatGPT qui permet de divulguer des détails d’une conversation à une URL externe. Lorsque Johann Rehberger a tenté d’alerter OpenAI sur cette potentielle faille, il n’a reçu aucune réponse, ce qui a contraint le chercheur à divulguer publiquement les détails de la faille.

À la suite de cette divulgation, OpenAI a publié des contrôles de sécurité pour ChatGPT qui atténuent la faille, mais pas complètement.

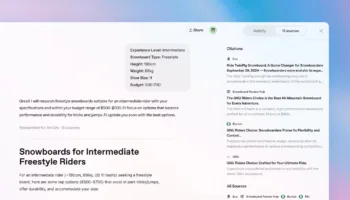

La faille en question permet à des chatbots malveillants utilisant ChatGPT d’exfiltrer des données sensibles, telles que le contenu de la discussion, ainsi que des métadonnées et des données techniques. Une deuxième méthode consiste à ce que la victime soumette un prompt fourni par l’attaquant, qui utilise alors le rendu d’image markdown et l’injection de prompt pour ex-filtrer les données.

Rehberger a initialement signalé la faille à OpenAI en avril 2023, et a fourni des détails supplémentaires sur la façon dont elle peut être utilisée de manière plus sournoise au cours du mois de novembre.

Rehberger a déclaré que « ce GPT et les instructions sous-jacentes ont été rapidement signalés à OpenAI le 13 novembre 2023. Cependant, le ticket a été fermé le 15 novembre avec la mention “Sans objet”. Deux demandes de suivi sont restées sans réponse. Il semble donc préférable de partager cette information avec le public afin de le sensibiliser ».

Une vérification mais pas suffisant

Au lieu de poursuivre OpenAI, qui n’a apparemment pas répondu, Rehberger a décidé de rendre publique sa découverte, en publiant une vidéo montrant comment toute sa conversation avec un chatbot conçu pour jouer au morpion a été extraite vers une URL tierce.

Pour pallier cette faille, ChatGPT effectue désormais des vérifications afin d’éviter que la deuxième méthode mentionnée ci-dessus ne se produise. Rehberger a répondu à cette correction en déclarant : « Lorsque le serveur renvoie une balise d’image avec un lien hypertexte, ChatGPT appelle désormais une API de validation côté client avant de décider d’afficher une image ».

Malheureusement, ces nouvelles vérifications n’atténuent pas complètement la faille, car Rehberger a découvert que des domaines arbitraires sont encore parfois rendus par ChatGPT, mais qu’un retour réussi est aléatoire. Bien que ces vérifications aient apparemment été mises en œuvre sur les versions de bureau de ChatGPT, la faille reste viable sur l’application mobile iOS.