Il y a quelques semaines, Microsoft a annoncé les Copilot+ PC, suscitant une question majeure : pourquoi ne pas simplement exécuter ces applications d’IA sur mon GPU ? Au Computex 2024, Nvidia a finalement apporté une réponse.

Nvidia et Microsoft collaborent sur une interface de programmation d’application (API) qui permettra aux développeurs d’exécuter leurs applications accélérées par l’IA sur les cartes graphiques RTX. Cela inclut les divers Small Language Models (SLM) intégrés dans le runtime Copilot, utilisés pour des fonctionnalités telles que Recall et les sous-titres en direct.

Grâce à cet ensemble d’outils, les développeurs pourront faire fonctionner les applications localement sur le GPU plutôt que sur l’unité de traitement neuronal (NPU). Cela ouvre la voie non seulement à des applications d’IA plus puissantes, car les capacités d’IA des GPU sont généralement supérieures à celles des NPU, mais aussi à la possibilité de les exécuter sur des PC qui ne font pas partie de la gamme Copilot+.

C’est une excellente initiative. Les Copilot+ PC nécessitent actuellement une NPU capable d’au moins 40 Tera Operations Per Second (TOPS). Pour le moment, seul le Snapdragon X Elite satisfait à ce critère. Cependant, les GPU ont des capacités de traitement de l’IA beaucoup plus élevées, même les modèles bas de gamme atteignant 100 TOPS, et les options haut de gamme allant bien au-delà.

Nouvelles capacités avec l’API

En plus de l’exécution sur le GPU, la nouvelle API ajoute des capacités de génération augmentée par récupération (RAG) au runtime Copilot. RAG permet au modèle d’IA d’accéder à des informations spécifiques localement, lui permettant de fournir des solutions plus utiles. Nous avons pu voir RAG en action avec le Chat avec RTX de Nvidia plus tôt cette année.

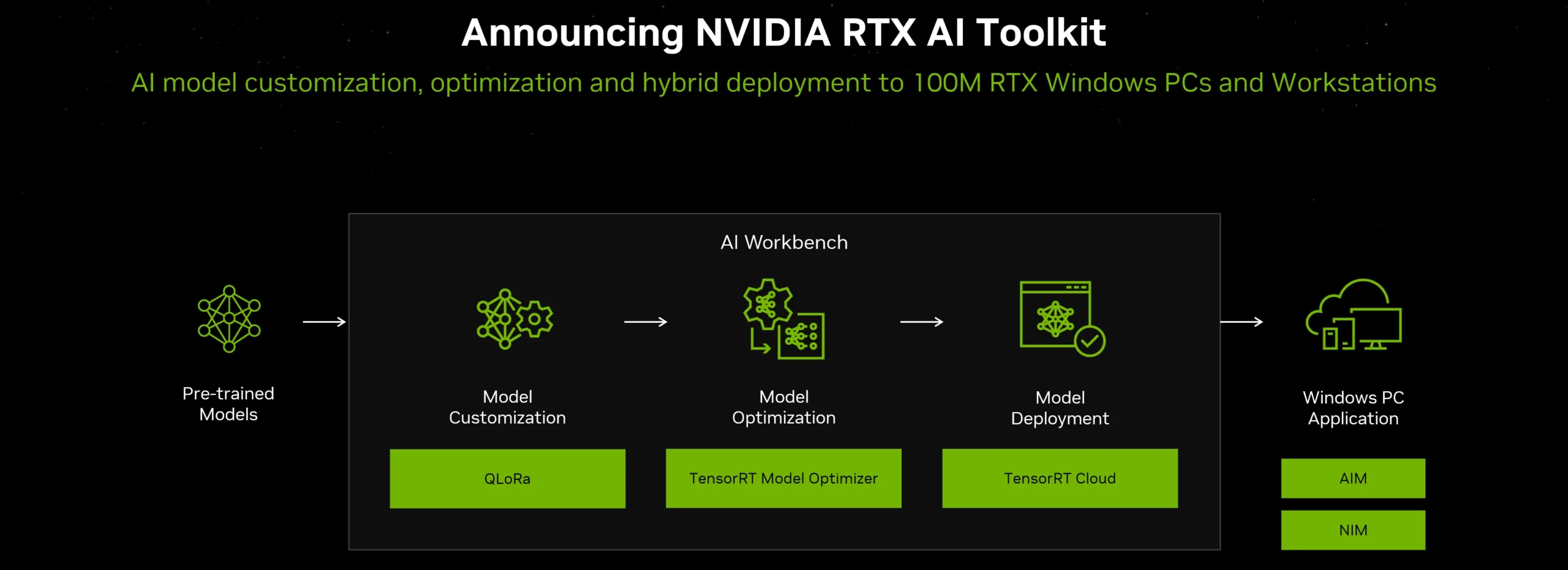

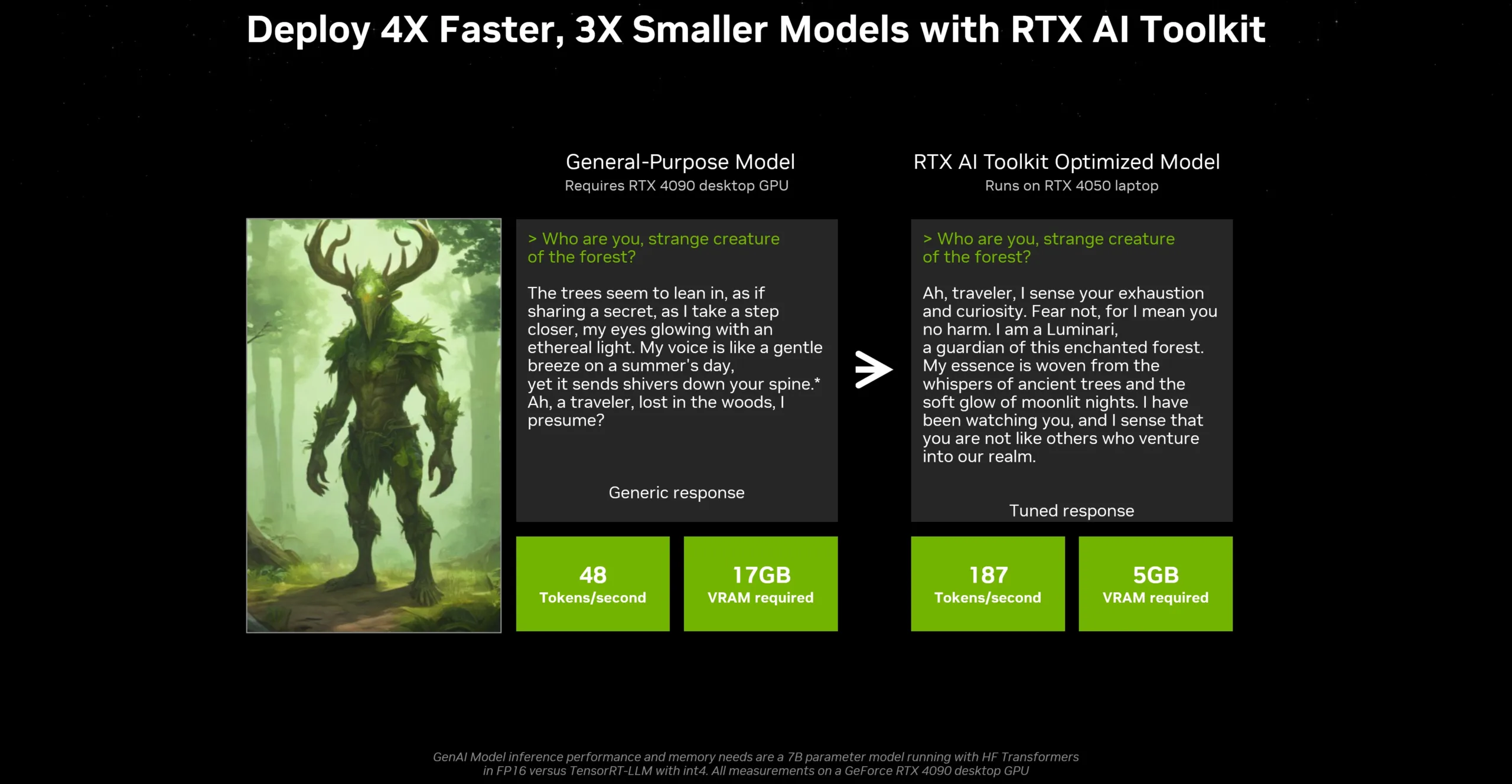

En dehors de l’API, Nvidia a annoncé le RTX AI Toolkit au Computex. Cette suite de développement, prévue pour juin, combine divers outils et SDK permettant aux développeurs d’ajuster les modèles d’IA pour des applications spécifiques. Nvidia affirme qu’en utilisant le RTX AI Toolkit, les développeurs peuvent rendre les modèles quatre fois plus rapides et trois fois plus petits par rapport aux solutions open source.

Un futur prometteur pour l’IA

Nous assistons à une vague d’outils permettant aux développeurs de créer des applications d’IA spécifiques pour les utilisateurs finaux. Certains de ces outils sont déjà visibles dans les Copilot+ PC, mais il est probable que nous verrons beaucoup plus d’applications d’IA d’ici l’année prochaine. Nous avons le matériel pour faire fonctionner ces applications, il ne manque plus que les logiciels.