Google vient de dévoiler Trillium, sa sixième génération de puce dédiée à l’intelligence artificielle (IA), annonçant des améliorations qui pourraient transformer radicalement les coûts et les capacités du développement de l’IA.

Cette puce, qui a servi à entraîner le modèle Gemini 2.0 récemment annoncé, promet des performances multipliées par quatre par rapport à la précédente génération tout en réduisant considérablement la consommation d’énergie.

Selon Sundar Pichai, PDG de Google, 100% de l’entraînement et de l’inférence de Gemini 2.0 ont été alimentés par les puces Trillium. Ce lancement s’inscrit dans un projet ambitieux : Google a connecté plus de 100 000 puces Trillium dans un réseau unique, créant ainsi l’un des supercalculateurs d’IA les plus puissants au monde.

Trillium, des performances 4 fois supérieures et une efficacité énergétique accrue

Trillium offre des avancées significatives à plusieurs niveaux :

- 4,7 fois plus de puissance de calcul par puce.

- Mémoire et bande passante doublées, permettant une gestion plus fluide des grands modèles.

- 67% d’efficacité énergétique en plus, un facteur crucial alors que les centres de données luttent pour gérer les besoins croissants en énergie des entraînements d’IA.

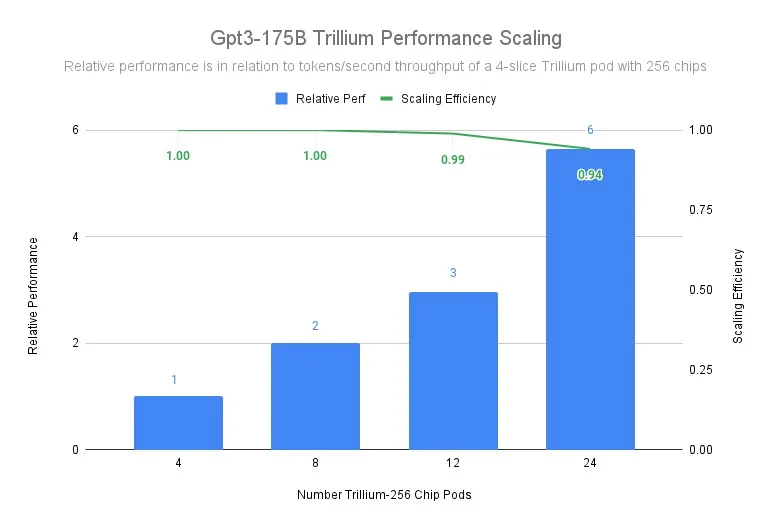

Mark Lohmeyer, vice-président de l’infrastructure de calcul et d’IA chez Google Cloud, a déclaré : « Lors de l’entraînement du modèle Llama-2-70B, Trillium a atteint une efficacité de mise à l’échelle de 99% sur des pods allant de 4 à 36 puces ».

Un changement économique pour les startups IA

En plus de ses performances, Trillium pourrait bouleverser l’économie du développement de l’IA. Google affirme que la puce offre jusqu’à 2,5x plus de performances par dollar investi par rapport à la génération précédente. Cette réduction des coûts pourrait être décisive pour les startups et entreprises développant des modèles linguistiques de grande taille.

AI21 Labs, l’un des premiers clients de Trillium, a déjà constaté des améliorations notables. Barak Lenz, directeur technique de AI21 Labs, a déclaré : « Les progrès en termes d’échelle, de vitesse et de rentabilité sont impressionnants ».

Une infrastructure hyperconnectée avec 100 000 puces

L’architecture d’hypercalcul de Google, intégrant les puces Trillium, utilise un réseau Jupiter capable de gérer 13 pétaoctets par seconde de bande passante. Cette infrastructure permet à un seul travail d’entraînement d’être réparti sur des centaines de milliers d’accélérateurs, atteignant une échelle auparavant inédite.

« L’usage des ressources flash a augmenté de 900%, ce qui est incroyable à observer », a ajouté Logan Kilpatrick, chef de produit chez Google AI Studio.

Concurrence avec Nvidia et les autres acteurs de l’IA

Le lancement de Trillium marque une intensification de la guerre des puces d’IA, un domaine largement dominé par Nvidia avec ses GPU. Alors que les puces Nvidia restent la norme pour de nombreuses applications IA, l’approche sur-mesure de Google pourrait offrir des avantages spécifiques, notamment pour l’entraînement de très grands modèles.

En rendant Trillium accessible à ses clients cloud, Google cherche également à s’imposer face à Microsoft Azure et Amazon Web Services dans le marché très compétitif des services d’IA cloud.

Un avenir prometteur pour le développement de l’IA

Les capacités de Trillium vont au-delà des gains de performances immédiats. La puce est optimisée pour gérer efficacement des charges de travail mixtes, allant de l’entraînement de modèles massifs à l’inférence en production. Cela ouvre la voie à une IA plus accessible et rentable, tant pour les grandes entreprises que pour les développeurs indépendants.

Selon Demis Hassabis, PDG de Google DeepMind : « Nous ne sommes qu’au début de ce qui est possible avec l’IA. Disposer de l’infrastructure adéquate, tant matérielle que logicielle, sera essentiel pour repousser les limites de ce que l’IA peut accomplir ».

Avec Trillium, Google démontre son engagement à rester à l’avant-garde de l’innovation en IA, en investissant dans une infrastructure capable de soutenir la prochaine génération de progrès en intelligence artificielle. Alors que la demande en puissance de calcul explose, cette puce pourrait bien devenir une pièce maîtresse dans l’évolution future de l’IA.