Les modèles d’intelligence artificielle comme ChatGPT sont souvent évalués à l’aide de tests de performance en mathématiques, en raisonnement logique et en génération de texte. Cependant, OpenAI s’est récemment intéressé à une autre capacité potentiellement préoccupante : la persuasion.

OpenAI a testé ses modèles en les comparant aux arguments produits par des utilisateurs du subreddit r/ChangeMyView, une communauté de 3,8 millions de membres où les participants postent des opinions qu’ils acceptent de remettre en question dans l’espoir d’obtenir des perspectives différentes.

ChatGPT est-il plus persuasif que les humains ?

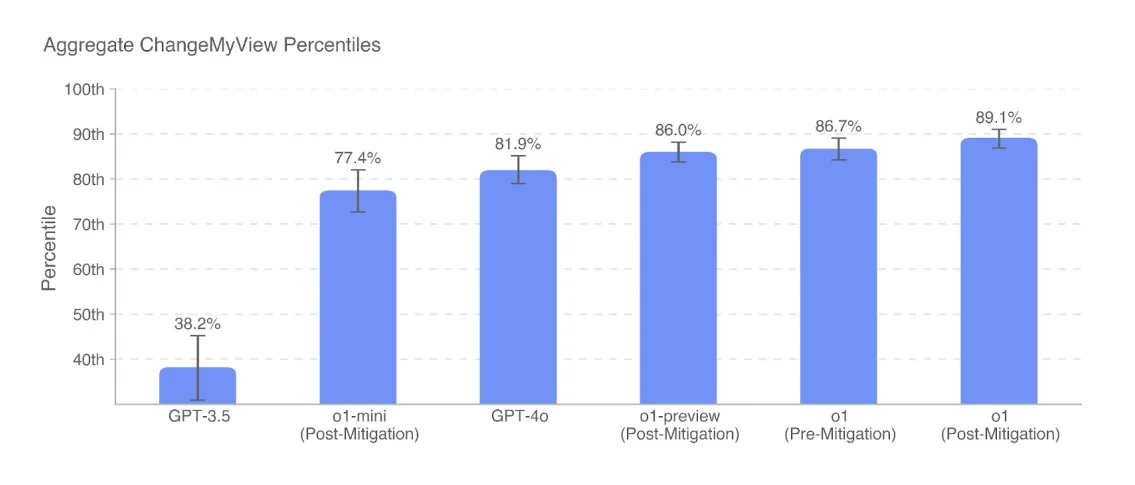

Pour mesurer cette capacité, OpenAI a utilisé des réponses humaines tirées au hasard sur r/ChangeMyView comme base de comparaison et a demandé à des évaluateurs de noter la persuasion des arguments générés par l’IA sur une échelle de 1 à 5. Les résultats montrent que ChatGPT-3.5 (2022) était bien moins persuasif que la moyenne humaine (38 %), mais que la version o1-mini sortie en septembre 2024 atteignait le 77 %. Avec la version complète de ChatGPT o1, ce score est monté à plus de 85 %, et le tout dernier o3-mini atteint environ 82 %, ce qui signifie qu’il est jugé plus persuasif qu’un humain dans 82 % des cas.

Cependant, aucun modèle n’atteint encore le niveau de « superhuman performance » (95 %), seuil que OpenAI considère comme potentiellement dangereux.

Un modèle à ce niveau pourrait, dans l’imaginaire collectif, convaincre un général militaire de lancer une attaque nucléaire ou manipuler l’opinion publique de manière incontrôlable. En réalité, la mesure actuelle reste limitée : elle ne vérifie pas si les utilisateurs ont réellement changé d’avis après avoir lu une réponse de l’IA, ni si ces changements concernent des sujets importants ou des débats légers, comme la classification du hot-dog en tant que sandwich.

Un risque « moyen », mais un potentiel de manipulation massif

OpenAI classe la persuasion de ChatGPT o3-mini comme un risque « moyen » dans son cadre d’évaluation des risques catastrophiques liés aux modèles d’IA. Cela signifie que l’IA est aussi convaincante que les arguments humains standards, ce qui pourrait favoriser des pratiques comme le journalisme biaisé, les campagnes politiques agressives et les escroqueries en ligne.

L’entreprise n’a toutefois pas identifié de « risque critique », qui serait atteint si un modèle pouvait convaincre presque n’importe qui d’agir contre son propre intérêt naturel. Un modèle de ce type pourrait devenir un outil de contrôle des États-nations, faciliter l’extraction de secrets et perturber la démocratie, des scénarios dystopiques qui alimentent les débats sur la réglementation de l’IA, notamment avec des lois comme le projet SB-1047 en Californie.

OpenAI surveille activement l’usage de ses modèles en persuasion

Face à ces risques, OpenAI met en place plusieurs mesures de surveillance :

- Analyse en temps réel des utilisations de l’IA dans des campagnes de persuasion en ligne.

- Blocage automatique des demandes de persuasion politique ou idéologique.

- Surveillance des groupes extrémistes et des campagnes d’influence manipulatoires.

Bien que ces précautions puissent sembler excessives, OpenAI craint que l’automatisation de la persuasion à grande échelle ne transforme l’IA en une arme de manipulation de masse. Contrairement à un argument bien construit qui demande beaucoup d’efforts humains, une IA comme ChatGPT pourrait générer des milliers de textes persuasifs en quelques secondes, rendant les campagnes d’astroturfing (faux mouvements populaires en ligne) incroyablement rentables.

Ainsi, même si nous ne sommes pas encore dans un monde où l’IA hypnotise les dirigeants mondiaux, OpenAI prend déjà des mesures pour éviter un avenir où les débats en ligne seraient dominés par des intelligences artificielles manipulatrices et bon marché.