Mistral AI est une startup française spécialisée dans les modèles d’intelligence artificielle open source. Fondée en 2023 par d’anciens chercheurs de Google DeepMind et Meta, elle s’est rapidement imposée grâce à ses modèles ouverts, portables, personnalisables et économiques, qui nécessitent moins de ressources informatiques que d’autres modèles de LLM populaires.

Avec un soutien financier important de la part d’investisseurs tels que Microsoft et Andreessen Horowitz, la startup a atteint une valorisation de 6 milliards de dollars après son dernier tour de financement.

Mistral AI se positionne ainsi comme un concurrent sérieux sur le marché de l’IA générative, rivalisant avec des géants comme Google, OpenAI et Anthropic.

Les modèles de Mistral AI : fonctionnement et innovations

Les modèles de Mistral AI reposent sur des architectures avancées et offrent plusieurs innovations clés.

Une architecture « Mixture of Experts » (MoE)

Certains modèles de Mistral, comme Mixtral 8x7B et 8x22B, utilisent une architecture Mixture of Experts (MoE). Contrairement aux architectures standard des transformeurs, cette approche divise le modèle en plusieurs sous-modèles appelés « experts », qui ne sont activés qu’en fonction du contexte.

Cela permet d’améliorer la performance tout en réduisant la consommation de ressources informatiques.

Open source et personnalisation

Une grande partie des modèles de Mistral AI sont open source, permettant aux utilisateurs d’accéder librement au code, aux données et aux poids des modèles. Cela favorise la transparence, l’adaptabilité et l’optimisation pour des besoins spécifiques. Particulièrement utile pour les secteurs réglementés (banques, hôpitaux), cette approche garantit un contrôle total sur la gestion des données.

Capacités de Function Calling

Les modèles Mistral Large 2, Large, Small, 8x22B et NeMo intègrent des fonctionnalités de Function Calling, facilitant leur intégration avec d’autres systèmes et leur utilisation pour l’extraction de données en temps réel, les calculs complexes et l’accès aux bases de données.

Multilingue par nature

Contrairement à certains LLM qui ne maîtrisent qu’une seule langue, les modèles de Mistral AI sont nativement fluents en anglais, français, espagnol, allemand et italien. Certains, comme Mistral Large 2, couvrent plus de 80 langues de programmation ainsi que le chinois, japonais, coréen, arabe et hindi.

Les modèles phares de Mistral AI

Mistral AI propose des modèles commerciaux et open source, chacun ayant ses spécificités et avantages.

Modèles commerciaux (via API uniquement)

- Mistral Large 2 :

- Modèle le plus avancé, avec une fenêtre de contexte de 128k tokens

- Proficient en 80+ langages de programmation

- Disponible en plusieurs langues européennes et asiatiques

- Mistral Large :

- Idéal pour les tâches complexes (génération de texte et de code)

- Fenêtre de contexte de 32k tokens

- Rivalise avec GPT-4 sur plusieurs benchmarks

- Mistral Small :

- Pensé pour les tâches à faible latence et le traitement en masse

- Fenêtre de contexte de 32k tokens

- Mistral Embed :

- Modèle spécialisé en conversion de texte en représentations numériques

- Utilisé pour l’analyse de sentiment et la classification de texte

Modèles open source (sous licence Apache 2.0)

- Mistral 7B :

- Léger et rapide, avec 32k tokens de contexte

- Surpasse Llama 2 (13B) et égale des modèles de 30B paramètres

- Mixtral 8x7B :

- Basé sur une architecture MoE (utilise 12B sur 45B paramètres)

- Surpasse Llama 2 (70B) et GPT-3.5 (175B)

- Mixtral 8x22B :

- Version plus avancée de Mixtral 8x7B (39B sur 141B paramètres actifs)

- Conçu pour la synthèse de documents volumineux et la génération massive de texte

- Codestral Mamba :

- Conçu pour le codage avec une fenêtre de contexte de 256k tokens

- Rivalise avec les meilleurs modèles transformeurs spécialisés en programmation

- Mathstral :

- Conçu pour les problèmes mathématiques complexes

- Équilibre précision et rapidité

- Mistral NeMo :

- Spécialisé en raisonnement et connaissances générales

- Fenêtre de contexte de 128k tokens

- Prend en charge plus de 10 langues, y compris le chinois, l’arabe et le portugais

Le Chat : L’alternative de Mistral à ChatGPT

Mistral AI propose également Le Chat, un chatbot analogue à ChatGPT, Gemini ou Claude. Il permet de choisir entre différents modèles selon l’usage souhaité :

- Mistral Large : Raisonnement avancé

- Mistral Small : Rapidité et coût réduit

- Mistral Next : Réponses concises et efficaces

- Mistral Large 2 : Expérimentations et tests avancés

Le Chat est gratuit et accessible sur chat.mistral.ai/chat, avec une version payante prévue pour les entreprises.

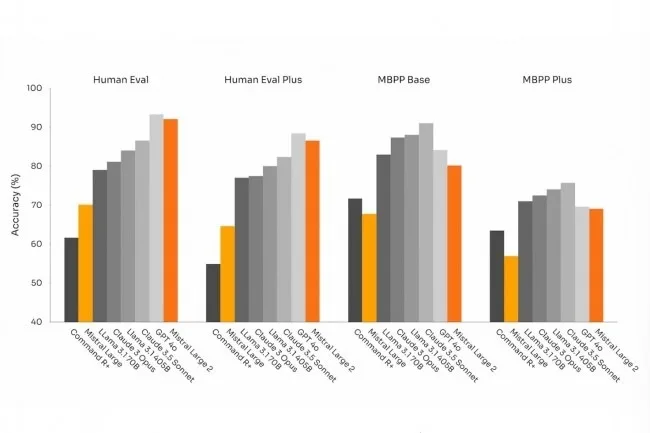

Mistral AI vs. OpenAI : Qui est le meilleur ?

Le modèle Mistral Large 2 est comparable à GPT-4o, bien que GPT-4o surpasse Mistral sur les benchmarks de génération de code. Cependant, Mistral excelle en function calling et en rapport coût-performance.

| Modèle | Performance globale | Prix (1M tokens entrée) | Prix (1M tokens sortie) |

|---|---|---|---|

| GPT-4o | Supérieur | 5 dollars | 15 dollars |

| Mistral Large 2 | Très compétitif | 3 dollars | 9 dollars |

Avec une différence de quelques points seulement en génération de code, Mistral Large 2 est un choix rentable pour les entreprises cherchant une IA performante à moindre coût.

Où utiliser les modèles Mistral AI ?

Les modèles de Mistral AI sont disponibles sur :

- La Plateforme, l’environnement de développement et de déploiement de Mistral

- Amazon Bedrock, Databricks, Snowflake Cortex, Azure AI

- Le Chat pour tester les modèles en direct

Les modèles de Mistral AI s’intègrent dans diverses applications :

- Chatbots et assistants virtuels

- Résumé de texte et génération de contenu

- Génération et optimisation de code

- Analyse de texte et classification

Avec sa philosophie open source, ses modèles performants et sa stratégie de coût optimisé, Mistral AI se positionne comme un acteur clé du marché de l’IA générative. En poursuivant son développement, elle pourrait bien remettre en cause la domination d’OpenAI et Google.

Que pensez-vous des modèles de Mistral AI ? Seriez-vous prêt à les utiliser dans vos projets ?