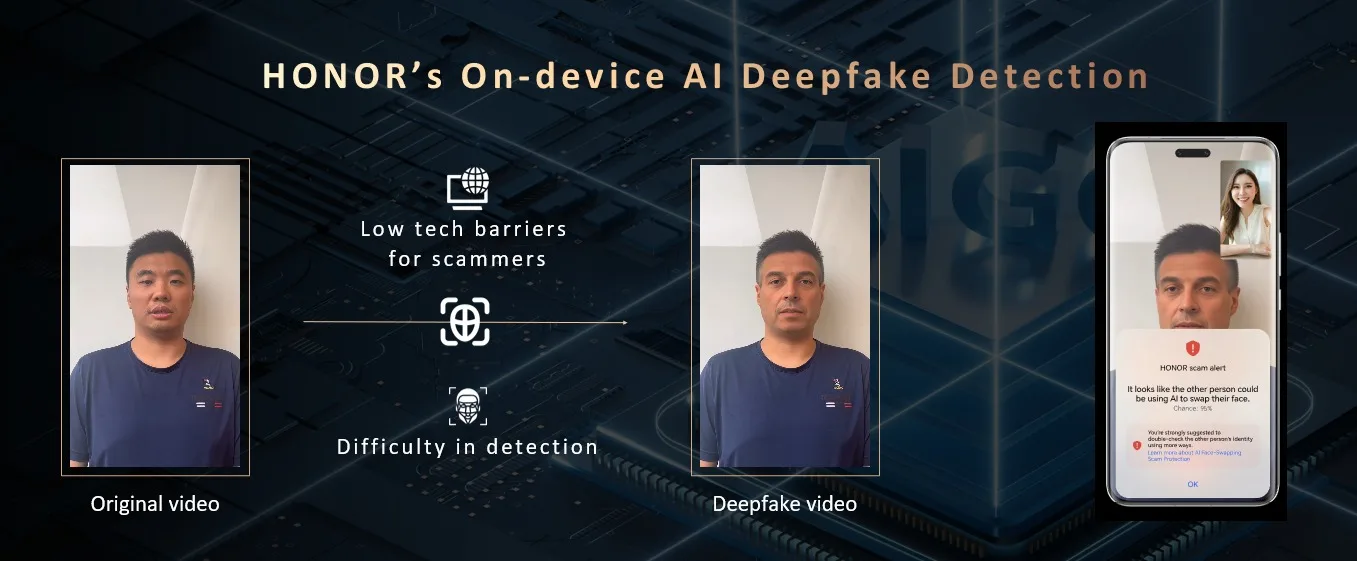

Honor a annoncé que sa fonction AI Deepfake Detection sera disponible dans le monde entier à partir d’avril 2025. Cette initiative vise à aider les utilisateurs à identifier les contenus audio et vidéo manipulés en temps réel.

La technologie Deepfake, qui utilise l’IA pour produire des médias très réalistes, mais faux, est devenue une préoccupation croissante pour les entreprises et les particuliers. L’Entrust Cybersecurity Institute a constaté qu’en 2024 seulement, une attaque de deepfake se produirait toutes les cinq minutes.

L’étude 2024 Connected Consumer Study de Deloitte a également révélé que 59 % des personnes interrogées avaient du mal à faire la différence entre un contenu créé par des humains et un contenu généré par l’IA. Par ailleurs, 84 % des personnes utilisant l’IA générative ont déclaré qu’elles souhaitaient que le contenu généré par l’IA soit clairement étiqueté.

Détection de Deepfake par l’IA de HONOR

Honor a présenté pour la première fois sa technologie de détection de Deepfake AI à l’IFA 2024. Le système utilise des algorithmes d’IA avancés pour repérer les incohérences mineures qui sont difficiles à repérer pour l’œil humain.

Comment fonctionne la détection de deepfakes par IA?

La technologie de Honor analyse les médias à la recherche d’incohérences subtiles, telles que:

- Imperfections synthétiques au niveau des pixels

- Artefacts de composition aux bordures

- Problèmes de continuité inter-images

- Anomalies faciales (rapport visage-oreilles, coiffure, traits du visage)

En cas de détection de contenu manipulé, les utilisateurs reçoivent des alertes en temps réel.

Combattre les attaques de type « deepfake »

Ce déploiement mondial intervient à un moment où les attaques de type « deepfake » se multiplient. L’IA a transformé de nombreux secteurs, mais a également amplifié les cybermenaces, notamment les attaques par deepfakes. Entre 2023 et 2024, les falsifications de documents numériques ont augmenté de 244 %. Les secteurs tels que l’iGaming, la fintech et la cryptographie ont été particulièrement touchés, avec des incidents de deepfake augmentant d’une année sur l’autre de 1520 %, 533 % et 217 %, respectivement.

Les initiatives de Honor s’inscrivent dans le cadre d’un effort plus large de l’industrie pour répondre aux préoccupations liées aux deepfakes. Des organisations, telles que le C2PA (Content Provenance and Authenticity), fondé par Adobe, Arm, Intel, Microsoft et Truepic, travaillent sur des normes techniques pour vérifier l’authenticité des contenus numériques. Microsoft a introduit des outils d’IA pour aider à prévenir les abus de deepfake, notamment une fonction de floutage automatique des visages dans les images téléchargées sur Copilot. En outre, le Snapdragon X Elite NPU de Qualcomm prend en charge la détection locale des deepfakes à l’aide des modèles d’IA de McAfee, préservant ainsi la vie privée des utilisateurs.

Une technologie important dans le combat des deepfakes

Marco Kamiya, de l’Organisation des Nations Unies pour le développement industriel (ONUDI), a fait l’éloge de cette technologie, soulignant que la détection des faux clichés par l’IA est une mesure de sécurité essentielle sur les appareils mobiles et qu’elle peut aider à protéger les utilisateurs contre les manipulations numériques.