Le marché de l’intelligence artificielle (IA) devient de plus en plus compétitif, et la startup canadienne Cohere ne compte pas se laisser distancer. Alors qu’elle peine encore à s’imposer face à OpenAI, Anthropic ou DeepSeek, Cohere vient d’annoncer Aya Vision, son premier modèle IA open-weight combinant traitement du langage et vision artificielle.

Ce modèle se distingue par sa capacité à comprendre et générer du contenu dans 23 langues, ce qui, selon Cohere, couvre « la moitié de la population mondiale ». Une avancée majeure qui pourrait changer la donne dans les applications d’IA multimodale.

Aya Vision : une IA visuelle et linguistique en open source

Aya Vision est conçu pour analyser des images, générer du texte et traduire du contenu visuel en langage naturel. Son objectif est de rendre l’IA multilingue plus accessible et plus efficace, notamment pour les entreprises et les organisations opérant à l’international.

Disponible en deux versions :

- Aya Vision 8B (8 milliards de paramètres)

- Aya Vision 32B (32 milliards de paramètres)

Où l’obtenir ?

Aya Vision est déjà disponible sur :

- Le site de Cohere

- Hugging Face et Kaggle

- WhatsApp, permettant une interaction directe avec l’IA

Licence d’utilisation : Le modèle est publié sous Creative Commons Attribution-NonCommercial 4.0 (CC BY-NC 4.0), ce qui signifie qu’il est gratuitement accessible pour des usages non commerciaux.

Une IA capable de comprendre 23 langues

Alors que des modèles comme GPT-4 ou Claude maîtrisent plusieurs langues, l’application de ces compétences aux tâches de vision reste un défi. Aya Vision le relève en permettant la génération de légendes d’images, la traduction visuelle et les réponses aux questions basées sur des images dans les langues suivantes : Anglais, Français, Allemand, Espagnol, Italien, Portugais, Japonais, Coréen, Chinois, Arabe, Grec, Persan, Polonais, Indonésien, Tchèque, Hébreu, Hindi, Néerlandais, Roumain, Russe, Turc, Ukrainien, Vietnamien.

Exemples d’applications :

- Apprentissage des langues : traduction et description d’images

- Préservation culturelle : analyse et documentation d’œuvres d’art et monuments

- Accessibilité : assistance aux personnes malvoyantes via des descriptions détaillées

- Communication mondiale : traduction multimodale en temps réel

- Une efficacité impressionnante face à des modèles plus grands

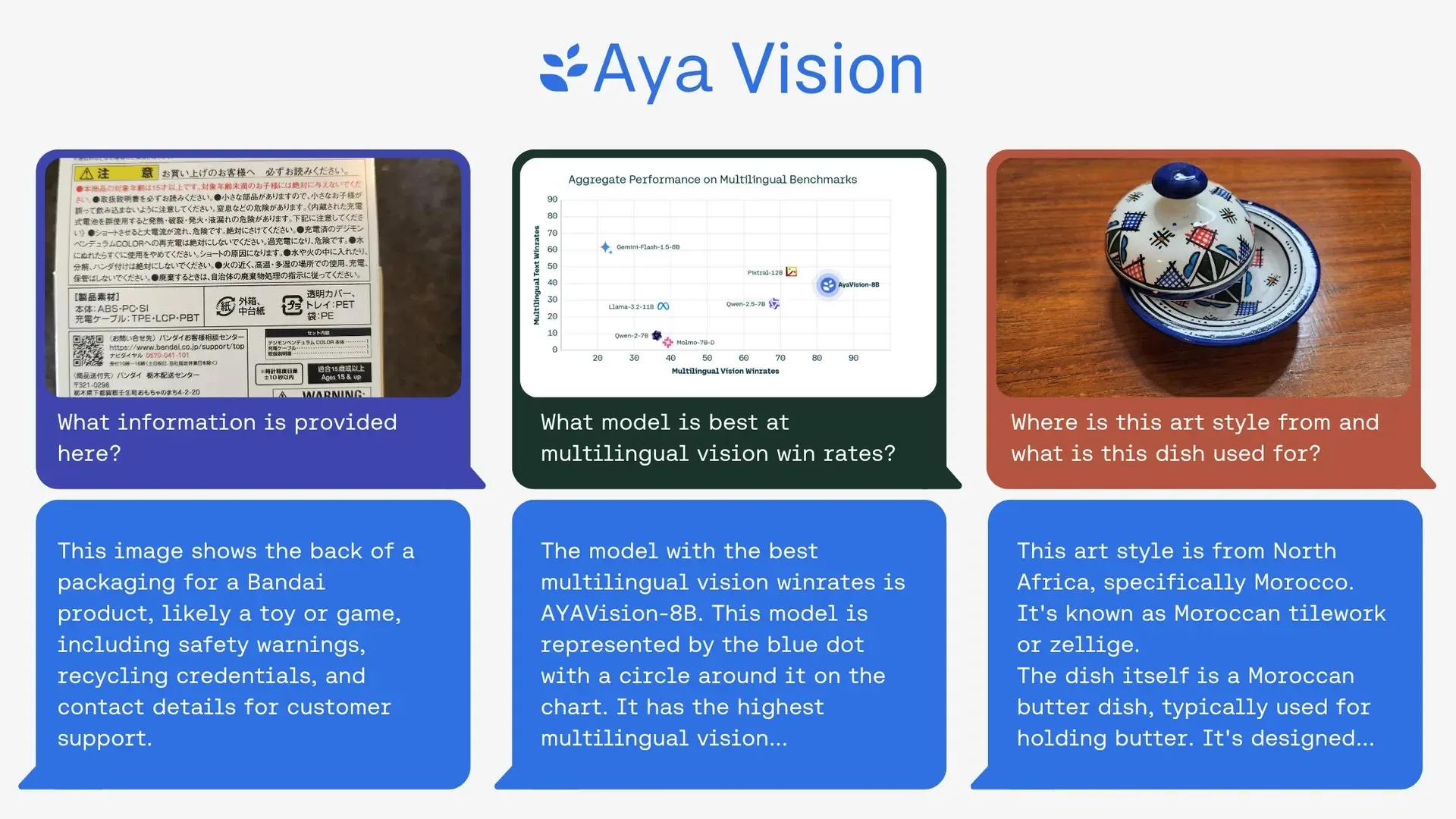

Malgré une taille plus réduite que d’autres IA, Aya Vision affiche des performances exceptionnelles sur plusieurs benchmarks.

- Aya Vision 8B dépasse LLaMA 90B, un modèle 11x plus grand

- Aya Vision 32B surpasse Qwen 72B, LLaMA 90B et Molmo 72B, tous au moins 2x plus grands

Résultats de benchmarking :

- Aya Vision 8B atteint un taux de réussite de 79 % en compréhension d’images multilingues

- Aya Vision 32B atteint 72 %

Quelles innovations derrière ces performances ?

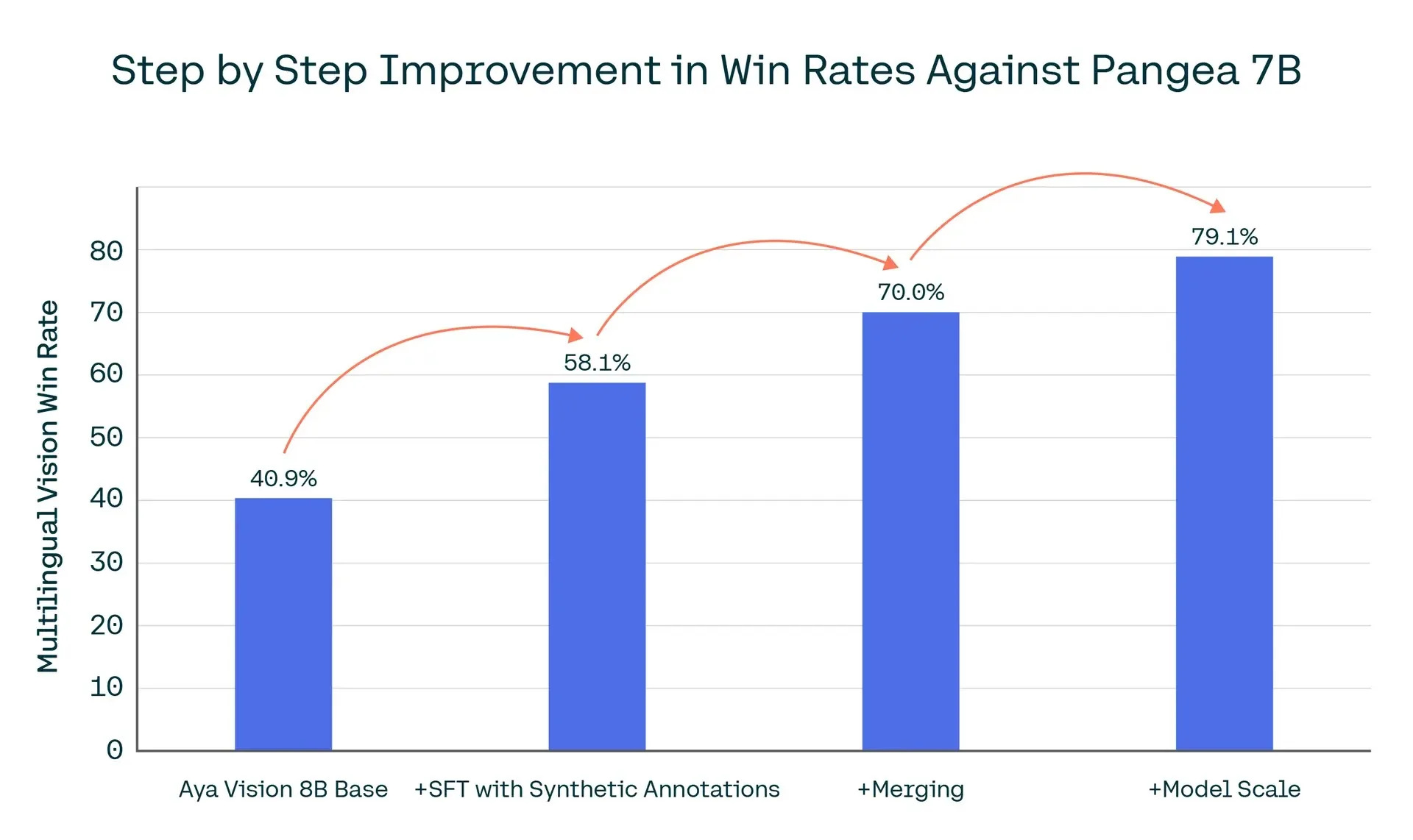

Cohere For AI explique qu’Aya Vision bénéficie de plusieurs avancées technologiques :

- Annotations synthétiques : génération de données artificielles pour améliorer l’apprentissage

- Échelle de données multilingues : traduction et reformulation automatique des données

- Fusion de modèles multimodaux : combinaison optimisée des informations issues des modèles visuels et linguistiques

Ces techniques permettent à Aya Vision de traiter des images et du texte avec une grande précision tout en conservant des capacités multilingues avancées.

Aya Vision pour les entreprises et chercheurs

Bien qu’Aya Vision soit conçu pour l’entreprise, sa licence non commerciale peut limiter son adoption dans des solutions payantes.

Utilisation en entreprise :

- Recherche et développement interne

- Benchmarking et tests d’IA multimodale

- Études sur l’IA multilingue avant une adoption à grande échelle

Utilisation pour les chercheurs :

- Analyse et amélioration des modèles IA

- Fine-tuning dans un cadre non commercial

- Études sur l’impact de l’IA en linguistique et vision

Aya Vision représente donc une ressource précieuse pour les chercheurs et les entreprises qui veulent expérimenter des solutions IA sans dépendre de modèles propriétaires fermés.

Aya Vision et l’avenir de l’IA multilingue

Aya Vision s’inscrit dans l’initiative Aya, lancée par Cohere en février 2024 pour rendre l’IA plus inclusive et multilingue.

Communauté de recherche Aya :

- 3 000 chercheurs indépendants

- 119 pays représentés

- Développement collaboratif pour améliorer les modèles IA

Cohere prévoit également de lancer un programme de recherche collaboratif et d’attribuer des bourses de recherche pour stimuler les avancées en IA multilingue.

Aya Vision, une avancée majeure pour l’IA multimodale

En rendant Aya Vision accessible à la communauté open source, Cohere continue de pousser les limites de l’IA.

Pourquoi Aya Vision est important ?

- Modèle puissant et efficace malgré une taille réduite

- Compatible avec 23 langues, une première pour un modèle vision-texte

- Open-weight et accessible, contrairement aux solutions propriétaires fermées

- Conçu pour la recherche et l’innovation IA, avec un fort engagement envers l’open science

Avec Aya Vision, Cohere veut non seulement démocratiser l’IA multilingue, mais aussi offrir une alternative puissante aux modèles propriétaires. Un projet ambitieux qui pourrait changer le paysage de l’IA multimodale dans les années à venir.