Google a récemment envoyé un e-mail aux parents utilisant le service de contrôle parental Family Link, leur annonçant que leurs enfants pourront bientôt accéder aux applications Gemini sur leurs appareils Android.

Cette décision marque une nouvelle étape dans l’intégration de l’IA dans le quotidien des jeunes utilisateurs, mais soulève aussi des questions sur la sécurité, la surveillance parentale et la sensibilisation.

Gemini pour les enfants : aide aux devoirs et lectures interactives

Selon The New York Times, les enfants pourront utiliser Gemini pour les aider à faire leurs devoirs ou se faire lire des histoires. Google précise que, comme pour ses comptes Google Workspace for Education, les données des enfants ne seront pas utilisées pour entraîner ses modèles d’IA.

Cependant, l’e-mail envoyé aux parents inclut une mise en garde claire : « Gemini peut faire des erreurs ». « Vos enfants pourraient tomber sur du contenu que vous préféreriez éviter ».

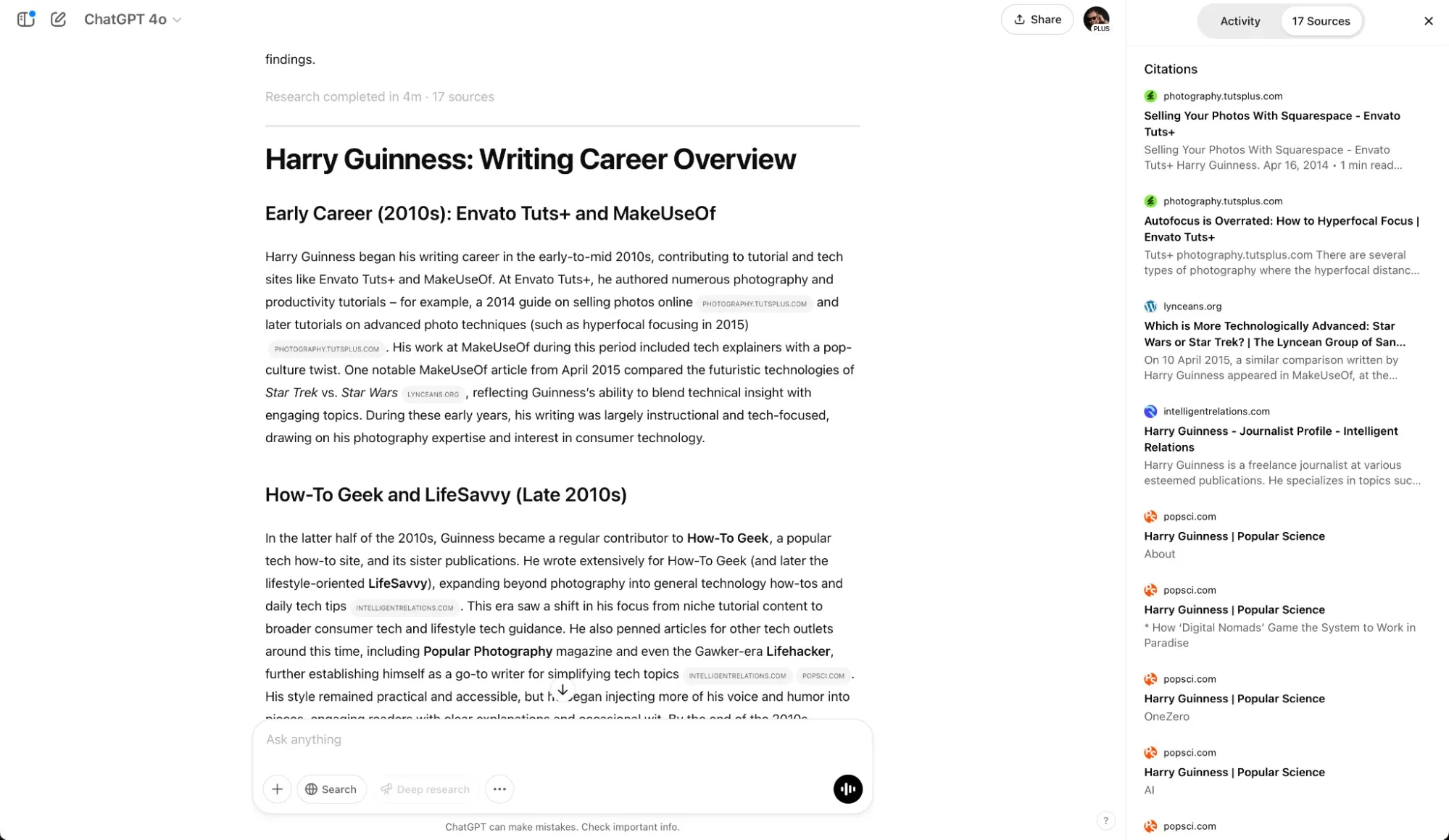

Des risques déjà documentés avec d’autres IA conversationnelles

Google n’est pas le premier à faire face à des controverses autour de l’usage de l’IA par les plus jeunes. Des plateformes comme Character.ai ont été accusées d’avoir induit des enfants en erreur, certains pensant qu’ils parlaient à de vraies personnes. Pire encore, des contenus inappropriés ont été suggérés, forçant ces services à instaurer de nouvelles restrictions et contrôles parentaux.

Un accès autonome pour les moins de 13 ans… sauf si les parents l’interdisent

Dans le cas de Gemini, les enfants de moins de 13 ans pourront activer l’IA eux-mêmes sur leurs appareils supervisés via Family Link. Ce système permet aux parents de :

- Surveiller l’activité numérique de leurs enfants

- Limiter le temps d’écran

- Bloquer certaines applications ou contenus

Un porte-parole de Google, Karl Ryan, a précisé que : « Les parents peuvent désactiver l’accès à Gemini via Family Link. Ils recevront également une notification supplémentaire lorsque l’enfant accède à Gemini pour la première fois ».

Sensibiliser les enfants à l’usage responsable de l’IA

Google encourage également les parents à discuter avec leurs enfants de la nature de l’IA :

- L’IA n’est pas humaine

- Il ne faut pas partager d’informations sensibles avec le chatbot

- Il est essentiel de vérifier les réponses fournies