C’est officiel : Google Assistant va tirer sa révérence en 2025, laissant place à Gemini, la nouvelle IA de Google. L’entreprise a progressivement introduit Gemini sur les nouveaux smartphones Android et s’apprête désormais à remplacer complètement Assistant.

Google Assistant a été annoncé en 2016 et bien que Google pense qu’il s’agit d’un assistant capable, la société a entendu des gens dire qu’ils voulaient un compagnon plus personnalisé qui peut les aider à faire plus de choses. Gemini est un assistant d’IA qui a été conçu à partir de zéro avec une compréhension du langage et un raisonnement avancés.

Quand Google Assistant disparaîtra-t-il ?

Google prévoit de désactiver Google Assistant sur la plupart des appareils mobiles d’ici la fin de 2025. Gemini est déjà installé par défaut sur les nouveaux modèles Pixel, Samsung, OnePlus et Motorola, mais jusqu’à présent, le passage à Gemini était optionnel.

Désormais, les utilisateurs recevront une notification les invitant à basculer sur Gemini, et l’option pour revenir à Google Assistant disparaîtra. De plus, l’application Google Assistant ne sera plus disponible en téléchargement sur le Play Store.

Seuls les appareils sous Android 9 ou inférieur avec moins de 2 Go de RAM pourront continuer à utiliser Google Assistant.

Google Assistant remplacé partout : smartphones, tablettes, voitures et objets connectés

L’arrêt de Google Assistant ne concerne pas que les smartphones. Google prévoit également de migrer tous ses autres produits vers Gemini, notamment :

- Tablettes

- Systèmes embarqués dans les voitures (Android Auto, Google Maps)

- Appareils connectés : écouteurs, montres Wear OS, TV et enceintes connectées

Google assure que l’Assistant restera fonctionnel sur ces appareils le temps d’adapter Gemini, mais qu’il finira par être totalement remplacé.

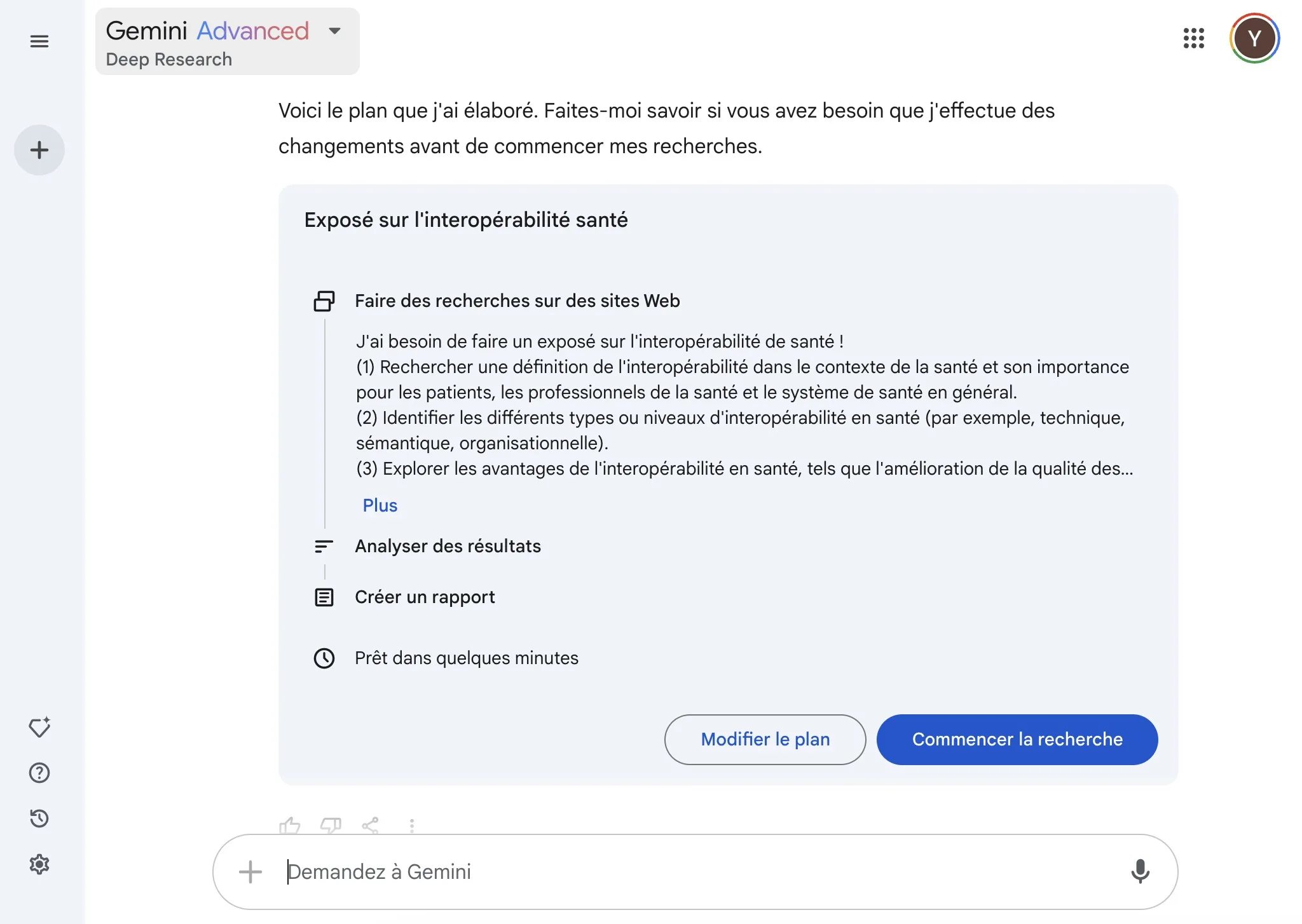

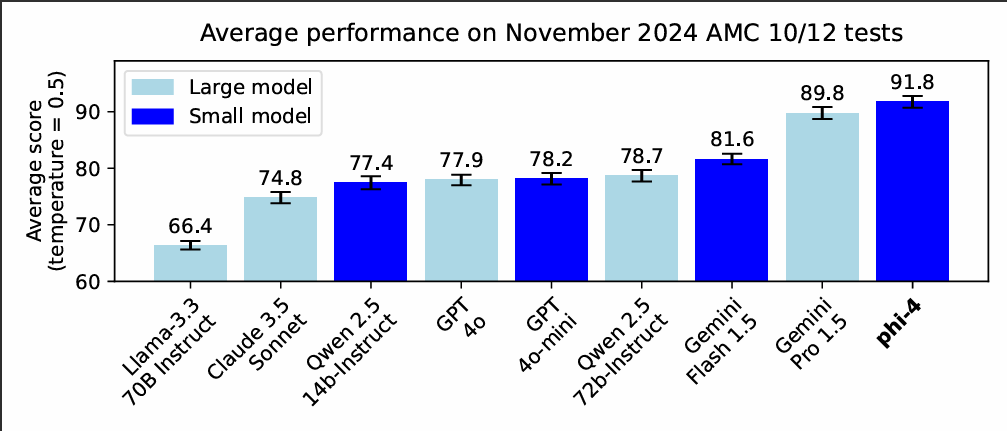

Gemini : Une IA vraiment plus performante que Google Assistant ?

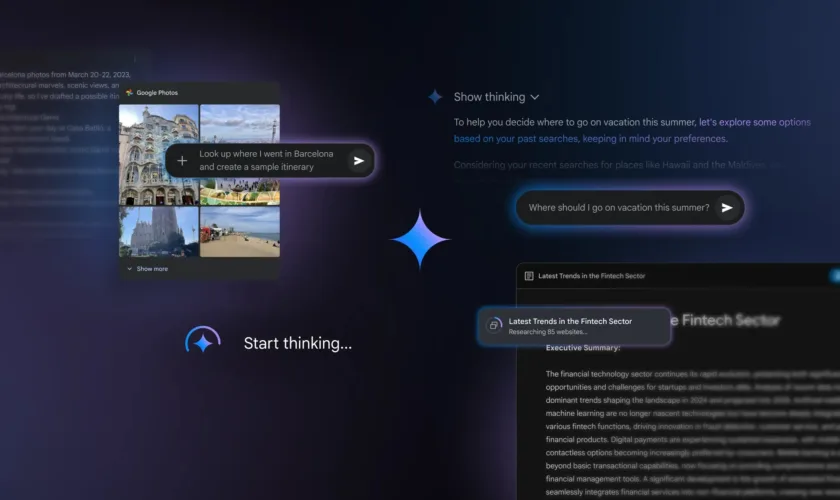

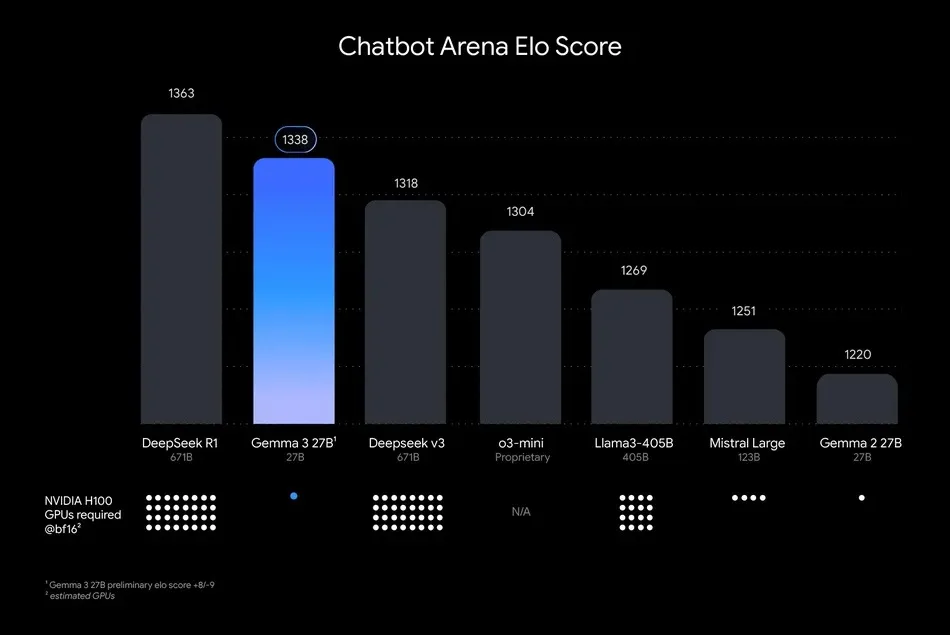

Le remplacement de Google Assistant par Gemini suscite beaucoup d’interrogations. Officiellement, Gemini est censé être une IA plus avancée et plus performante, capable d’interpréter des requêtes complexes et d’offrir des réponses plus naturelles.

Toutefois, des études récentes ont montré que les chatbots comme Gemini peuvent être « confiants, mais incorrects » dans 74 % des cas. Contrairement à Google Assistant, qui s’appuie sur des sources vérifiées, Gemini génère des réponses à partir de modèles d’IA entraînés sur des données du web — un risque majeur en termes de fiabilité.

Quel avenir pour Google et ses IA ?

Google mise tout sur Gemini pour contrer ChatGPT (OpenAI) et Copilot (Microsoft). Mais pour convaincre les utilisateurs, il devra :

- Améliorer la fiabilité de Gemini

- Assurer une transition fluide pour les anciens utilisateurs de Google Assistant

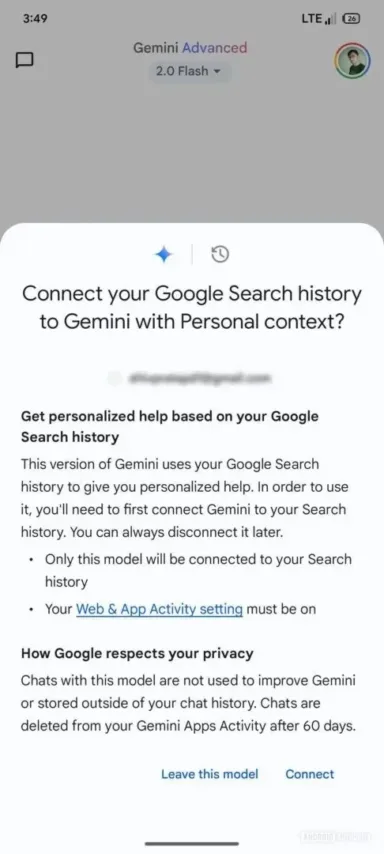

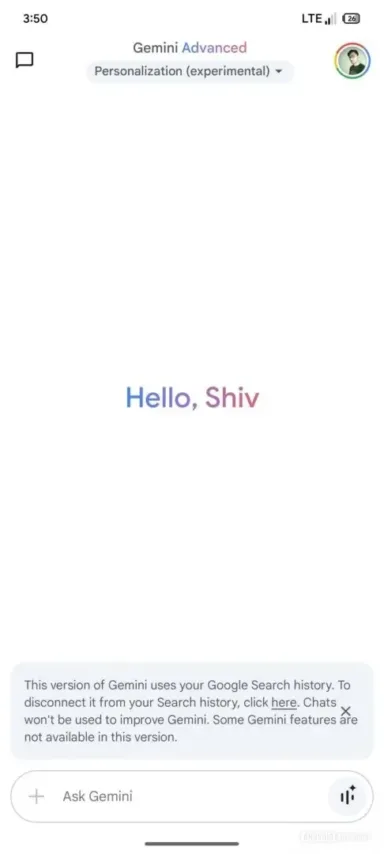

- Proposer une meilleure intégration avec les services Google et les objets connectés

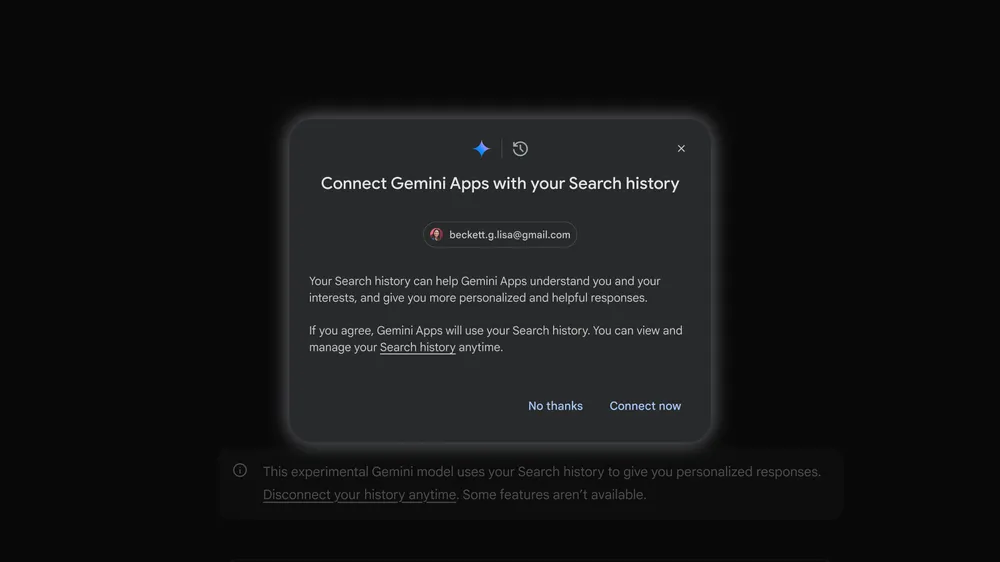

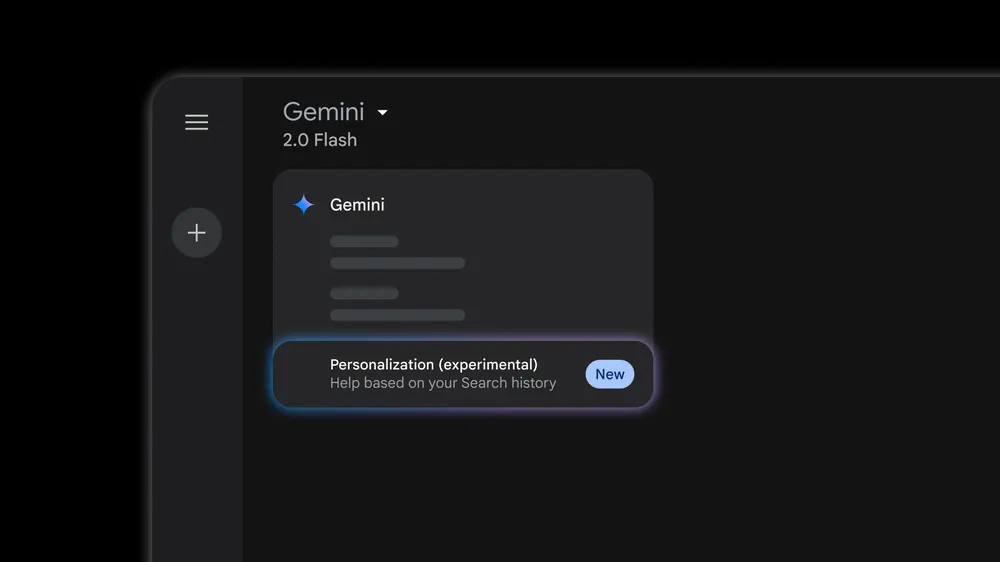

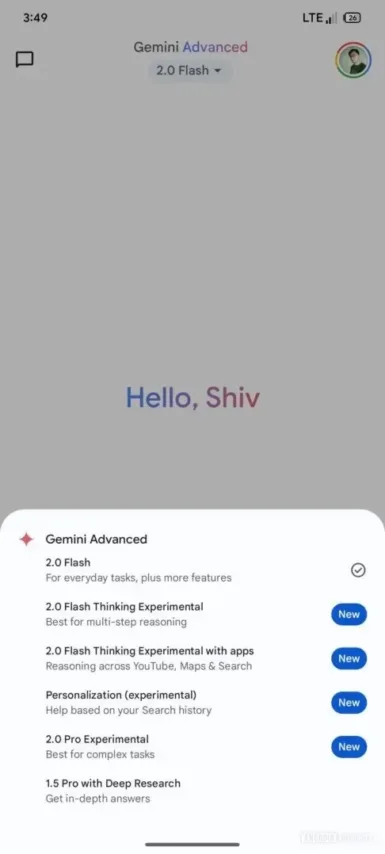

D’ici là, si vous êtes un utilisateur régulier de Google Assistant, préparez-vous à un changement radical en 2025 ! Depuis l’introduction de l’application Gemini l’année dernière, Google l’a améliorée de plusieurs façons et a ajouté des fonctionnalités que les gens aimaient dans Google Assistant. Cela devrait théoriquement faciliter la transition.

Que pensez-vous de la disparition de Google Assistant au profit de Gemini ? Bonne ou mauvaise nouvelle ?