Le lancement de GPT-4.5, le tout dernier modèle d’OpenAI, est entravé par une pénurie de puces GPU (Graphics Processing Units). Ces composants sont essentiels à l’entraînement des modèles d’intelligence artificielle, permettant de traiter d’énormes volumes de données et d’effectuer des calculs complexes simultanément.

Contrairement aux CPU (Central Processing Units), qui traitent les données de manière séquentielle, les GPU sont optimisés pour les opérations matricielles, rendant leur utilisation bien plus adaptée aux modèles d’IA.

Face à cette contrainte matérielle, Sam Altman, PDG d’OpenAI, a assuré que des centaines de milliers de GPU sont en route. L’entreprise devrait ainsi pouvoir progressivement élargir l’accès à GPT-4.5, qui pour l’instant est réservé aux abonnés Pro de ChatGPT, facturés 200 dollars par mois. Lorsque la situation s’améliorera, les utilisateurs de ChatGPT Plus (20 dollars par mois) devraient également pouvoir profiter de cette mise à niveau.

Mais ce problème met en lumière une dépendance critique : OpenAI dépend fortement des fournisseurs comme NVIDIA pour ses besoins en calcul intensif. C’est pourquoi l’entreprise envisage de développer ses propres puces afin de réduire sa vulnérabilité face aux fluctuations des stocks et aux prix du marché.

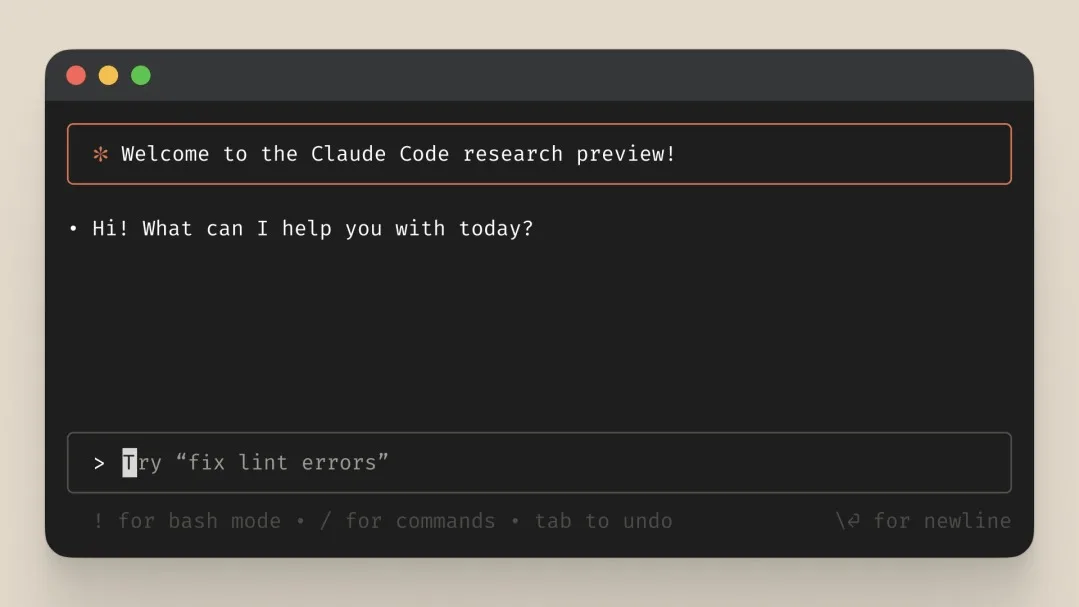

GPT-4.5 is ready!

good news: it is the first model that feels like talking to a thoughtful person to me. i have had several moments where i’ve sat back in my chair and been astonished at getting actually good advice from an AI.

bad news: it is a giant, expensive model. we…

— Sam Altman (@sama) February 27, 2025

Un modèle cher mais révolutionnaire

Dans son tweet, Sam Altman précise que GPT-4.5 n’est pas un modèle conçu pour battre des records de raisonnement, mais qu’il s’agit d’une nouvelle forme d’intelligence qui, selon lui, possède une « magie » qu’il n’a jamais ressentie auparavant.

Cependant, ce modèle est extrêmement coûteux. Son utilisation revient à 75 dollars par million de tokens en entrée et 150 dollars par million de tokens en sortie. À titre de comparaison, GPT-4o coûte seulement 2,50 dollars par million de tokens en entrée et 10 dollars par million de tokens en sortie.

Les tokens, qui peuvent être une lettre, un mot ou un signe de ponctuation, sont l’unité de base avec laquelle les modèles de langage traitent le texte. Plus un modèle est avancé, plus il consomme de tokens, ce qui impacte directement son coût d’exploitation.

NVIDIA, le grand gagnant de la course à l’IA

Cette demande croissante pour les GPU explique l’ascension fulgurante de NVIDIA en bourse, avec une hausse impressionnante de 1 748,96 % en 5 ans. L’IA étant l’un des secteurs technologiques les plus porteurs, NVIDIA bénéficie d’une demande explosive pour ses puces spécialisées.

Alors que les géants de l’IA comme OpenAI, Google et Meta se ruent sur les ressources informatiques, la course aux GPU est plus intense que jamais. L’avenir nous dira si OpenAI réussira à s’affranchir de cette dépendance en développant ses propres solutions matérielles ou si NVIDIA continuera de dominer ce marché stratégique.