Le paysage du développement logiciel est en pleine effervescence avec les progrès de l’intelligence artificielle, de l’informatique sur le cloud et de l’automatisation.

Les développeurs, architectes infatigables de notre monde numérique, s’adaptent en permanence pour garder une longueur d’avance. Et s’il existait un moyen de simplifier leur charge de travail, de rationaliser leurs processus et de libérer leur potentiel créatif ?

Voici Google Bard, le compagnon de codage innovant qui devrait révolutionner le développement de logiciels au cours de l’année à venir.

Bard : au-delà des mots à la mode

Bard n’est pas un simple mot à la mode : il s’agit d’un vaste modèle de langage développé par Google et entraîné sur un ensemble massif de données de texte et de code. Cela lui permet de comprendre les subtilités du langage humain, les nuances des langages de programmation et la logique complexe qui sous-tend le développement de logiciels.

Contrairement à un simple outil de complétion de code, Google Bard est un partenaire collaboratif, un sherpa numérique qui guide les développeurs sur le terrain inconnu des projets complexes.

La symphonie de la collaboration

Imaginez un peu : vous êtes bloqué sur un problème de codage particulièrement épineux. Vous avez passé des heures à déboguer, la frustration monte et l’échéance se profile à l’horizon. C’est alors que vous vous adressez à Bard. Vous décrivez votre problème dans un langage simple et Bard vous écoute attentivement. Il analyse votre code, suggère des solutions potentielles et génère même des bouts de code à tester. C’est comme si un développeur chevronné vous chuchotait des conseils avisés à l’oreille, vous guidant vers l’insaisissable solution.

C’est la symphonie de la collaboration qu’orchestre Bard. Elle amplifie vos forces, en comblant les lacunes de vos connaissances. Il peut :

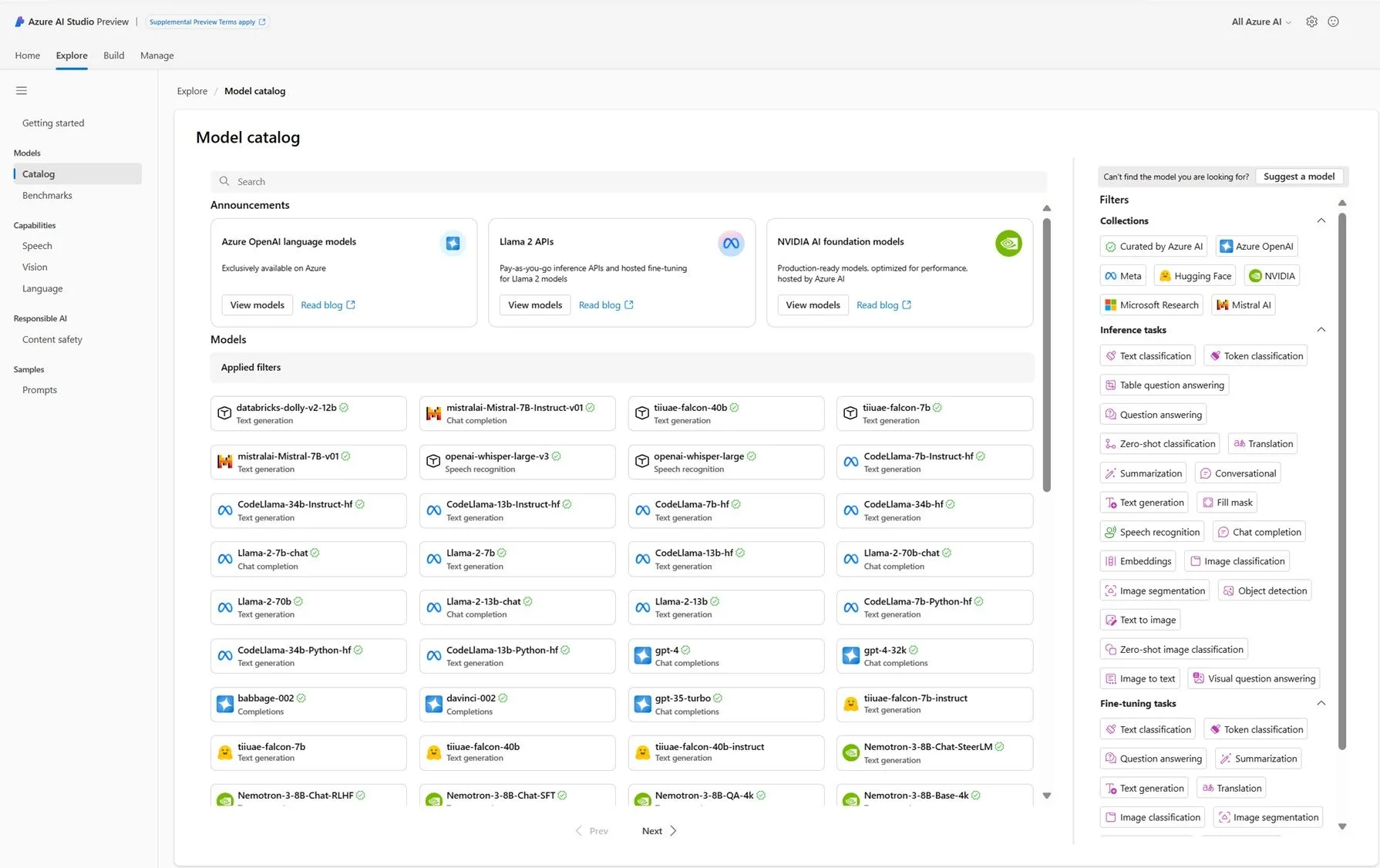

- Comprendre vos besoins : expliquez les objectifs de votre projet et Bard en saisira les fonctionnalités essentielles, en vous suggérant des bibliothèques, des frameworks et des meilleures pratiques.

- Démystifier le code : vous êtes bloqué sur un bug ? Bard peut analyser votre code, signaler les potentielles erreurs et même suggérer des corrections.

- Générer du code standard : libérez-vous de la fastidieuse tâche d’écrire du code répétitif. Bard peut créer du code de base, ce qui vous permet de vous concentrer sur la logique de base.

- Offrir des perspectives diverses : vous êtes coincé dans une ornière de codage ? Bard peut suggérer des approches alternatives, en s’inspirant d’un vaste répertoire de projets open source et de forums de développeurs.

- Rédiger une documentation complète : Plus besoin de se démener pour documenter votre code. Bard peut générer automatiquement une documentation claire et concise, ce qui vous permet de gagner un temps précieux et d’assurer la maintenabilité du projet.

Au-delà des corrections de bugs : libérer la créativité

Mais les capacités de Bard vont bien au-delà de la correction de bugs et de l’achèvement du code. C’est un catalyseur créatif qui repousse les limites du développement logiciel. Il peut :

- Prototyper rapidement : vous avez besoin de tester rapidement une nouvelle idée ? Bard peut vous aider à construire des prototypes de base, vous permettant d’itérer et d’affiner votre concept avant de plonger dans un développement complet.

- Générer des interfaces utilisateur créatives : vous êtes bloqué sur la conception d’une interface utilisateur ? Bard peut vous suggérer des mises en page innovantes, des palettes de couleurs et des éléments interactifs, afin de stimuler votre créativité.

- Écrire des tests unitaires sans effort : vous redoutez la corvée d’écriture des tests unitaires ? Bard peut générer automatiquement des tests complets, garantissant la robustesse et la qualité de votre code.

- Collaborez avec diverses équipes : comblez le fossé de la communication entre les développeurs, les designers et les chefs de produit. Bard peut traduire le jargon technique en anglais simple et vice versa, garantissant ainsi une collaboration sans faille.

L’avenir du développement : les humains et l’IA en harmonie

L’essor de l’IA dans le développement de logiciels ne signifie pas que les développeurs humains vont sombrer dans la sinistrose. Au contraire, c’est l’occasion de travailler plus intelligemment, et non plus durement. Bard responsabilise les développeurs en les libérant des tâches banales et répétitives, ce qui leur permet de se concentrer sur les aspects véritablement créatifs du développement logiciel. Il s’agit d’une relation symbiotique où l’ingéniosité humaine et la puissance de traitement de l’IA se combinent pour créer des expériences logicielles remarquables.

Accepter le changement : se préparer à un avenir alimenté par Bard

Alors, comment pouvez-vous, en tant que développeur, vous préparer à cet avenir alimenté par l’IA ?

Voici quelques conseils :

- Adopter l’apprentissage tout au long de la vie : à mesure que les outils d’IA évoluent, l’apprentissage continu devient crucial. Tenez-vous au courant des dernières avancées en matière d’IA et des capacités de Bard pour en exploiter tout le potentiel.

- Mettez l’accent sur les compétences non techniques : Si Bard peut se charger des tâches techniques, de solides compétences en matière de communication, de collaboration et de résolution de problèmes resteront essentielles dans les équipes de développement humain-IA de demain.

- Expérimentez et explorez : n’ayez pas peur d’expérimenter les fonctionnalités de Bard. Jouez, repoussez les limites et découvrez comment il peut rationaliser votre workflow et stimuler votre créativité.

Résumé

L’année 2024 marque l’avènement d’une nouvelle ère dans le développement de logiciels, où les humains et l’IA collaborent dans une symphonie de créativité et d’efficacité. Bard, le compagnon de codage, se trouve à l’avant-garde de cette révolution, prêt à donner du pouvoir aux développeurs et à remodeler le tissu même de la création de logiciels.

Adoptez le changement, explorez les possibilités et libérez l’immense potentiel qui se trouve à l’intersection de l’ingéniosité humaine et de l’IA.