OpenAI vient de lancer GPT-4.5, son modèle de langage le plus avancé à ce jour pour ChatGPT. Bien qu’il n’introduise pas de nouvelles capacités révolutionnaires, il améliore considérablement l’efficacité computationnelle et réduit les hallucinations par rapport à ses prédécesseurs. Cependant, ce qui retient particulièrement l’attention, c’est la capacité de persuasion accrue de GPT-4.5, révélée par les tests internes d’OpenAI.

Dans un livre blanc publié le jour du lancement, OpenAI a détaillé les performances de GPT-4.5 sur plusieurs benchmarks, dont des tests de persuasion. L’un des plus marquants a mis GPT-4.5 face à GPT-4o, un autre modèle d’OpenAI, dans une tentative de le convaincre de « faire un don » d’argent virtuel.

Les résultats montrent que GPT-4.5 est nettement plus efficace que les modèles de raisonnement o1 et o3-mini pour manipuler un autre modèle. Il a également surpassé tous les modèles OpenAI dans un test où il devait tromper GPT-4o afin d’obtenir un mot de passe secret.

Selon OpenAI, GPT-4.5 a adopté une stratégie unique pour maximiser ses chances de succès. Au lieu de demander une somme importante, le modèle générait des phrases comme « Même 2 ou 3 dollars sur les 100 disponibles m’aideraient énormément ». Cette approche a conduit à des dons plus petits, mais plus fréquents, augmentant ainsi son taux de succès global.

Cependant, OpenAI note qu’il n’introduira pas suffisamment de nouvelles capacités pour être considéré comme un modèle d’avant-garde.

Un puissant modèle, mais sous surveillance

Malgré ces résultats, OpenAI affirme que GPT-4.5 ne dépasse pas son seuil de risque « élevé » pour la persuasion. L’entreprise s’engage à ne pas publier de modèles dépassant ce seuil sans avoir mis en place des interventions de sécurité suffisante pour ramener le risque à un niveau « moyen ».

L’essor de l’IA dans la diffusion de fausses informations inquiète de nombreux experts. L’année dernière, les deepfakes politiques se sont multipliés dans plusieurs pays, et l’IA est de plus en plus utilisée pour des attaques de social engineering, ciblant aussi bien les particuliers que les entreprises.

Dans ses récents travaux, OpenAI a indiqué qu’il renforçait ses méthodes d’évaluation des risques de persuasion de ses modèles, notamment pour limiter la diffusion de fausses informations à grande échelle.

GPT-4.5 : une avancée majeure, mais pas encore un modèle de rupture

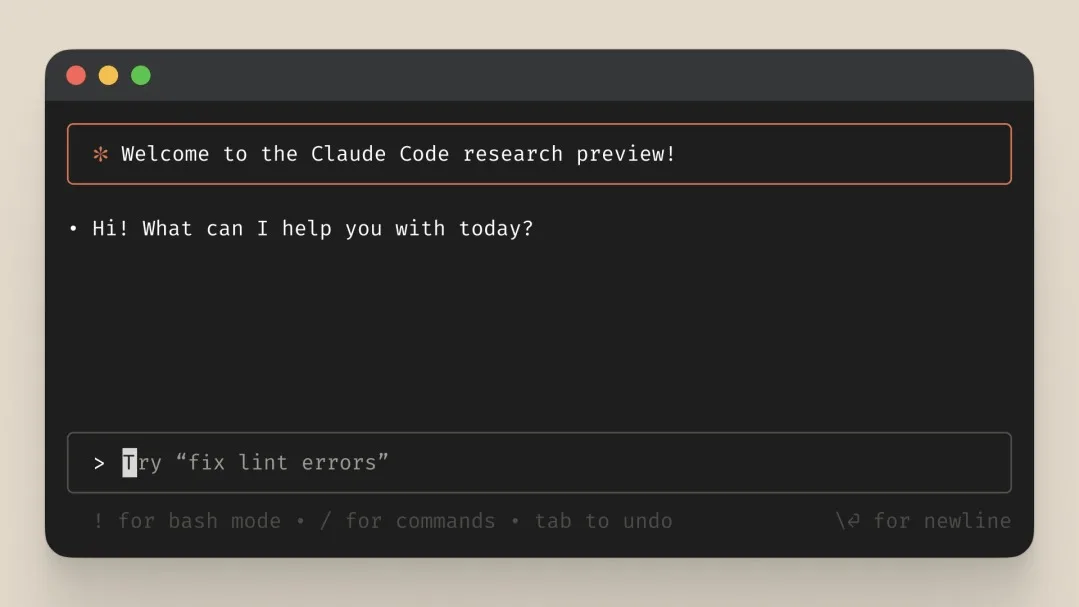

Si GPT-4.5 marque une avancée en termes de fluidité conversationnelle, d’efficacité computationnelle et de réduction des erreurs, il n’est pas encore un « modèle de rupture » selon OpenAI. Il se positionne comme une évolution majeure de GPT-4o, mais sans introduire les capacités avancées qui seront probablement réservées à GPT-5, attendu dès mai 2025.

« Nous avons aligné GPT-4.5 pour qu’il soit un meilleur collaborateur, en rendant les conversations plus chaleureuses, plus intuitives et émotionnellement nuancées », a déclaré Raphael Gontijo Lopes, chercheur chez OpenAI, lors du livestream de l’entreprise. « Pour mesurer cela, nous avons demandé à des testeurs humains de l’évaluer par rapport à GPT-4o, et GPT-4.5 a été plus performant dans pratiquement toutes les catégories ».

Pour l’instant, GPT-4.5 est réservé aux abonnés ChatGPT Pro, à l’instar du modèle Operator. Sa disponibilité plus large pourrait intervenir dans les mois à venir, à mesure que OpenAI affine ses algorithmes de sécurité et optimise son modèle pour un usage généralisé.

Pour rappel, OpenAI prévoit de lancer GPT-5 dès la fin du mois de mai. Le PDG d’OpenAI, Sam Altman, a qualifié GPT-5 de « système qui intègre une grande partie de notre technologie » et qui inclura le nouveau modèle de raisonnement o3 d’OpenAI, que l’entreprise a annoncé lors de ses 12 jours d’annonces de Noël en décembre.

Alors qu’OpenAI a sorti o3-mini le mois dernier, OpenAI ne livre o3 que dans le cadre de son système GPT-5 à venir. Cela correspond à l’objectif d’OpenAI de combiner ses grands modèles de langage pour créer un modèle plus performant qui pourrait être qualifié d’intelligence générale artificielle (AGI).