Lorsque OpenAI a lancé ChatGPT il y a un an aujourd’hui, l’idée d’un assistant personnel piloté par l’IA était nouvelle pour une grande partie du monde.

Nous avions tous vu des chatbots capables de fournir des réponses préprogrammées, mais personne ne pensait pouvoir disposer d’un véritable compagnon de conversation, capable de parler de tout et de rien et de nous aider dans toutes sortes de tâches fastidieuses — qu’il s’agisse de préparer un itinéraire de voyage, d’apporter des éclaircissements sur des sujets complexes ou de rédiger des articles de longue haleine.

Aujourd’hui, malgré toutes les péripéties de l’entreprise — de l’interdiction éphémère de l’Italie à l’éviction de Sam Altman et à son retour triomphal — ChatGPT continue d’être l’assistant d’IA de référence pour des millions d’utilisateurs connectés à l’Internet. Il est présent sur le Web et les appareils mobiles, aidant à accomplir diverses tâches et témoignant d’un engagement à l’échelle de milliards.

Selon SimilarWeb, pour le seul mois d’octobre 2023, ChatGPT a enregistré près de 1,7 milliard de visites sur mobile et sur le Web, avec 193 millions de visiteurs uniques et une durée d’environ 8 minutes par visite. Pour mettre en perspective, c’est bien plus que l’engagement dont témoignent des services populaires sur Internet, notamment Zoom et (214 millions de visites) Google Meet (59 millions de visites).

Mais au-delà de l’introduction de l’IA conversationnelle dans la vie de millions de personnes en l’espace de quelques mois, ChatGPT a également réussi à catalyser l’écosystème de l’IA au sens large. Peu après son lancement, l’IA générative a fait parler d’elle, entraînant le lancement de dizaines d’offres grand public pour la production de texte, de musique, de vidéo et de code.

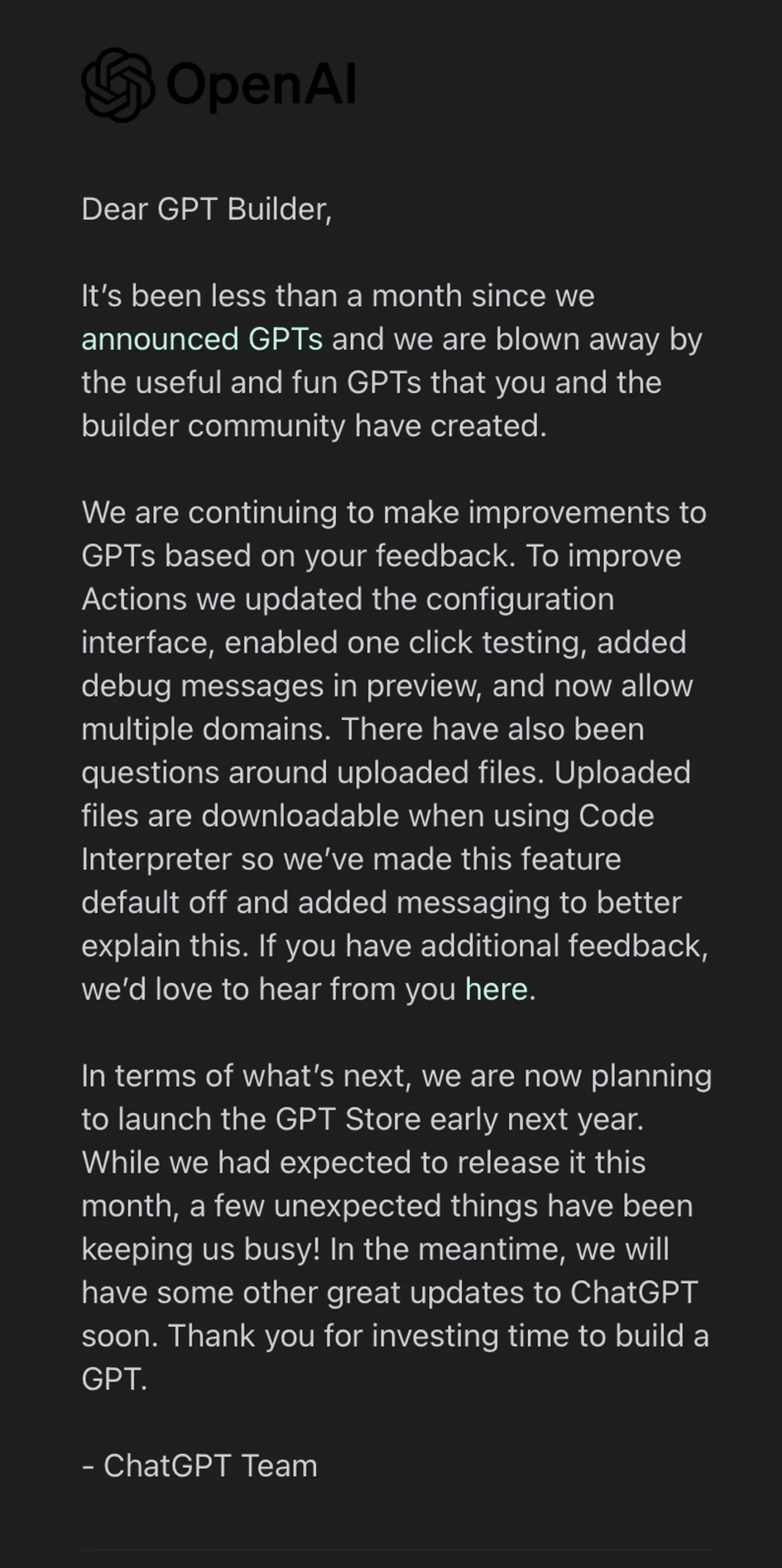

Pour le chat et le code, beaucoup de ces offres — comme Github Copilot et Perplexity AI — ont exploité des versions affinées de la série de modèles GPT qui alimentent ChatGPT. Plusieurs entreprises et startups ont également exploité les API d’OpenAI pour des applications commerciales internes et la création de GPT personnalisés pour des tâches granulaires telles que l’analyse de données.

Plus important encore, dans cette course à l’IA, de nombreuses startups et géants de la technologie ont également développé leurs propres grands modèles de langage (LLM) et ont produit des chatbots polyvalents tout aussi performants, capables de comprendre, de raisonner et de répondre aux demandes des utilisateurs. Certes, ils ne sont peut-être pas encore aussi populaires que ChatGPT, mais ils ont démocratisé l’espace, en veillant à ce que l’assistant OpenAI ne soit pas le seul de son genre.

L’ère des assistants d’IA conversationnels

Anthropic et Google ont été les premiers à entrer en scène après OpenAI. Quelques mois à peine après le lancement de ChatGPT, les deux entreprises ont présenté leurs assistants conversationnels respectifs : Claude et Bard.

Anthropic, fondée en 2021 par d’anciens employés de OpenAI, se concentre fortement sur la sécurité et l’éthique et a formé son assistant en tant qu’« IA constitutionnelle », où il suit certains ensembles de règles et s’améliore grâce à un retour d’information automatisé. Bard, quant à lui, a été construit sur le modèle de langage Pathways 2 et fonctionne autour de la recherche Google, en utilisant l’accès à Internet et le traitement du langage naturel pour fournir des réponses aux requêtes avec un contexte et des sources détaillées. Ils sont tous deux considérés comme les plus grands rivaux de ChatGPT.

Mais ce n’est pas tout.

Après l’arrivée de Claude et de Bard, d’autres chatbots intéressants ont commencé à apparaître. Il ne faut pas oublier le modèle Llama 2 de Meta Platforms, qui a suscité une vague de développement et de variantes perfectionnées grâce à son caractère open source. Plus récemment, xAI d’Elon Musk a annoncé Grok, qui est doté d’une touche d’humour et de sarcasme et utilise les données X en temps réel pour fournir les informations les plus récentes.

Bien que tous ces assistants aient été conçus pour aider les utilisateurs à effectuer des tâches allant de la recherche générale à l’écriture en passant par le résumé de texte, il faut toujours garder à l’esprit qu’ils sont en constante évolution. Les capacités et les limites qu’ils présentent aujourd’hui ne seront peut-être plus les mêmes quelques mois plus tard.

Après tout, lorsque ChatGPT a été lancé il y a un an, il s’agissait d’un assistant textuel. Aujourd’hui, il prend en charge les commandes vocales et les images, et dispose même de sa propre voix pour répondre, à l’instar d’Alexa.

Les assistants spécifiques à un marché sont également présents

Outre les grands assistants mentionnés ci-dessus, plusieurs assistants d’IA spécifiques à un marché ont également été développés — adaptés à différents secteurs, publics, langues et utilisations plus distinctes.

Il s’agit notamment de HyperClovaX du géant sud-coréen de l’Internet Naver, des célèbres chatbots chinois Ernie et DeepSeek récemment introduits, ainsi que de Poro et Nucleus, ce dernier étant conçu pour le secteur agricole.

La société indienne Reliance Industries a également décidé de lancer un assistant d’IA générative conçu pour les différents dialectes du pays et s’est assuré l’infrastructure informatique de NVIDIA pour ce faire.

Cela dit, avec un grand nombre d’acteurs qui s’efforcent déjà de tenir les promesses de l’IA conversationnelle et de nombreux autres qui s’apprêtent à la lancer, on peut affirmer sans risque de se tromper que la course à l’IA est loin d’être terminée. À mesure que les modèles sous-jacents s’améliorent et que les capacités s’accroissent, notamment la capacité des chatbots à fournir des réponses plus naturelles et pertinentes avec un minimum d’hallucinations, l’écart entre ces acteurs devrait se réduire, ce qui permettra de repousser encore plus loin les limites de l’IA.

Pour son premier anniversaire, ChatGPT reste le leader de la catégorie dans le domaine de l’IA. Il sera toutefois intéressant de voir comment il maintiendra cette position dans les années à venir et évoluera vers une IA sûre et responsable pour tous.