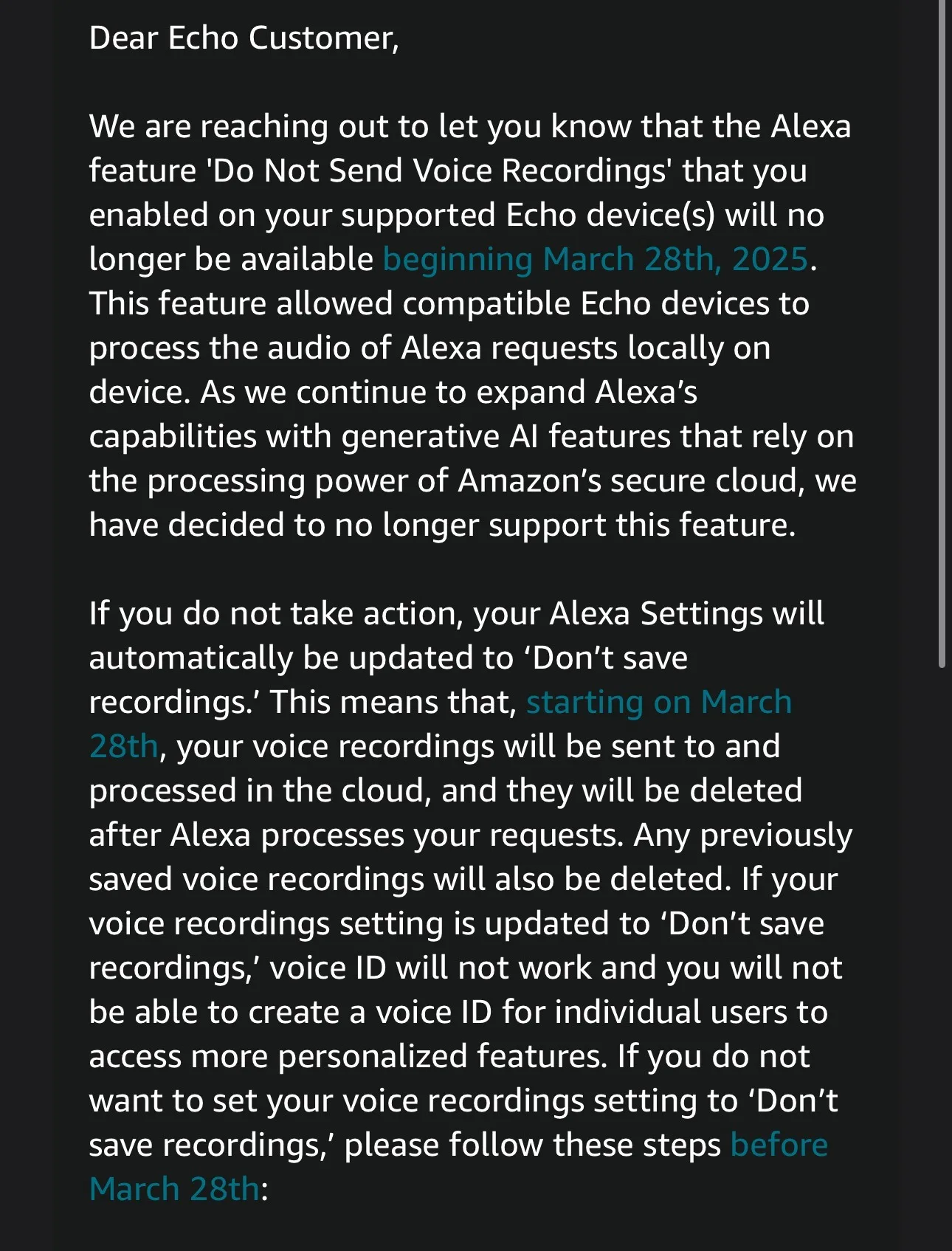

Amazon s’apprête à supprimer une fonctionnalité essentielle de confidentialité d’Alexa. Dès le 28 mars, les utilisateurs d’Echo perdront l’option « Ne pas envoyer les enregistrements vocaux », ce qui signifie que toutes les interactions avec Alexa seront envoyées aux serveurs d’Amazon, sans possibilité de s’y opposer.

Dans un e-mail adressé aux utilisateurs d’Alexa, Amazon justifie cette décision par l’intégration croissante de l’IA générative dans son assistant vocal : « Nous souhaitons vous informer que la fonction “Ne pas envoyer les enregistrements vocaux” ne sera plus disponible à partir du 28 mars. Alors que nous continuons à étendre les capacités d’Alexa avec des fonctionnalités d’IA générative, nous avons décidé de ne plus prendre en charge cette option ».

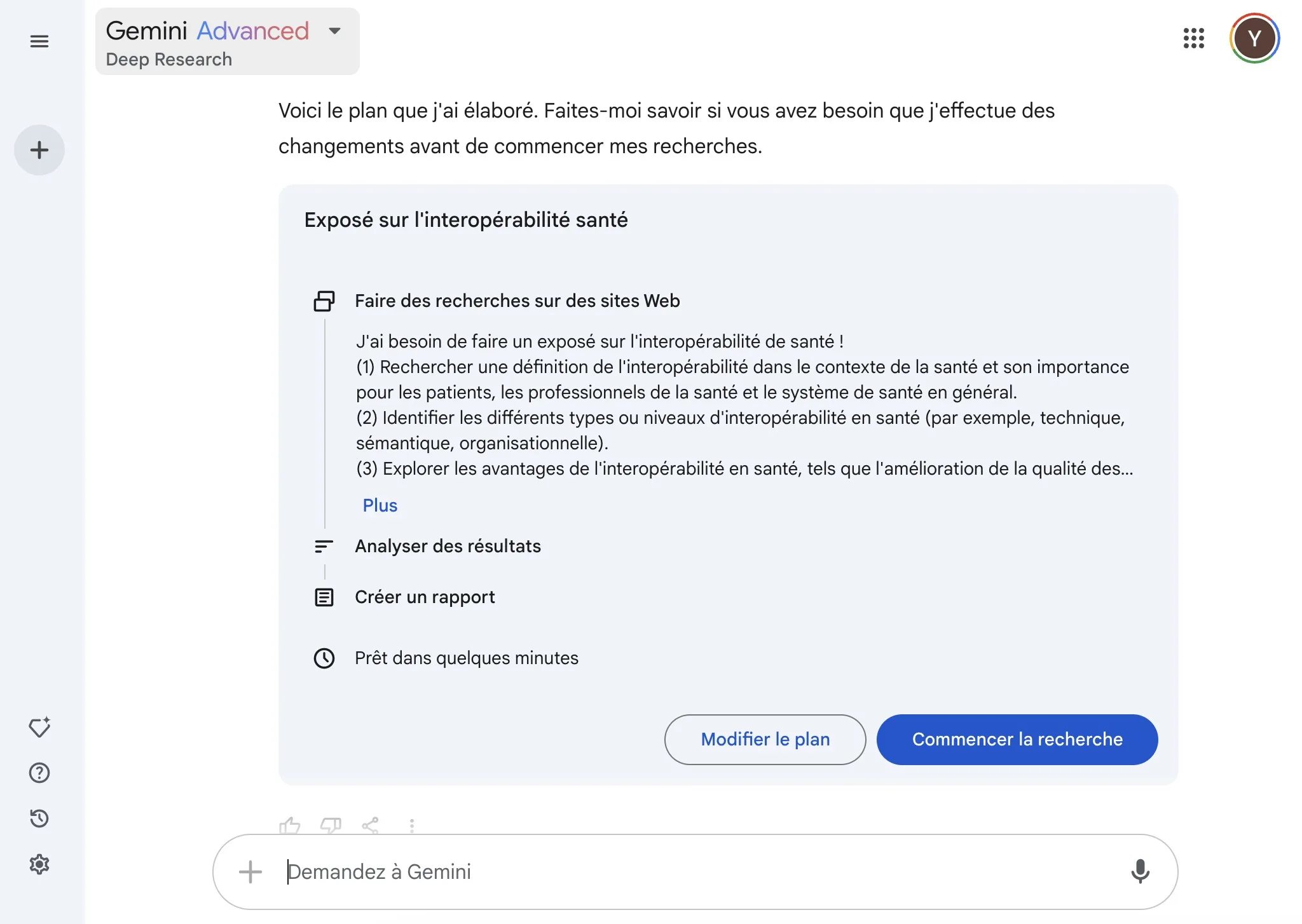

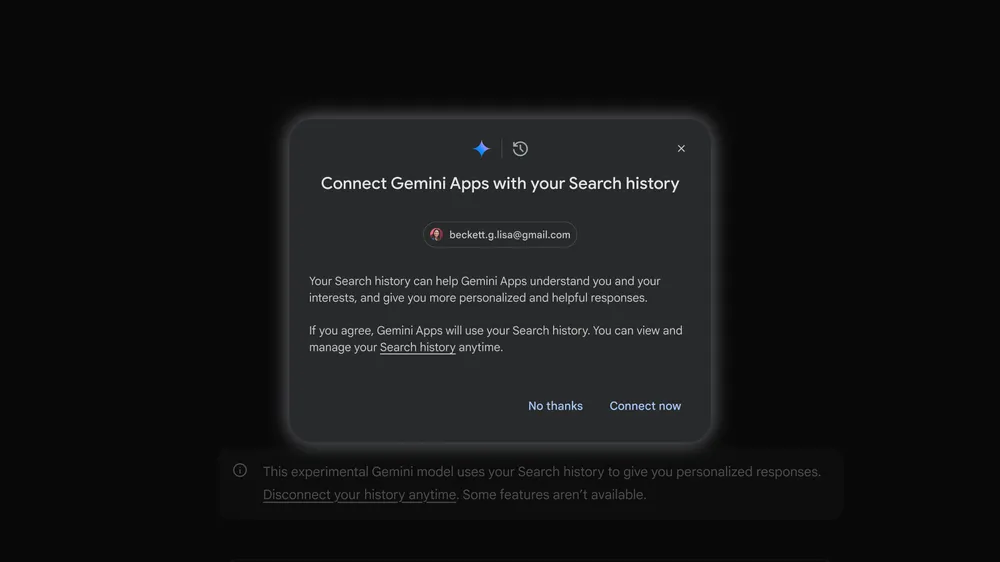

Autrement dit, Amazon veut exploiter ces enregistrements pour entraîner son modèle d’IA, notamment Alexa+, sa toute première IA conversationnelle basée sur un LLM (Large Language Model).

Aucune option pour refuser, sauf arrêter d’utiliser Alexa

Contrairement à d’autres services d’IA comme ChatGPT, Gemini ou Perplexity, qui permettent à leurs utilisateurs de désactiver la collecte de données, Amazon impose ce changement sans alternative. Si vous souhaitez utiliser Alexa après le 28 mars, vous devrez accepter que vos enregistrements vocaux soient systématiquement envoyés et traités par Amazon.

Amazon assure que ces requêtes seront chiffrées et stockées dans son cloud sécurisé, mais cela n’atténue pas l’inquiétude des utilisateurs soucieux de leur vie privée.

Amazon mise tout sur Alexa+

Cette annonce s’inscrit dans la stratégie d’Amazon pour relancer Alexa, dont l’adoption a été plus compliquée que prévu ces dernières années. Avec Alexa+, l’entreprise cherche à concurrencer les assistants dopés à l’IA comme Google Gemini et Microsoft Copilot.

Cependant, cette suppression d’une option clé de confidentialité risque de créer un effet inverse en incitant les utilisateurs soucieux de leur vie privée à abandonner complètement Alexa.

Alexa devrait-elle continuer à offrir une option de désactivation des enregistrements vocaux ? Partagez votre avis dans les commentaires !