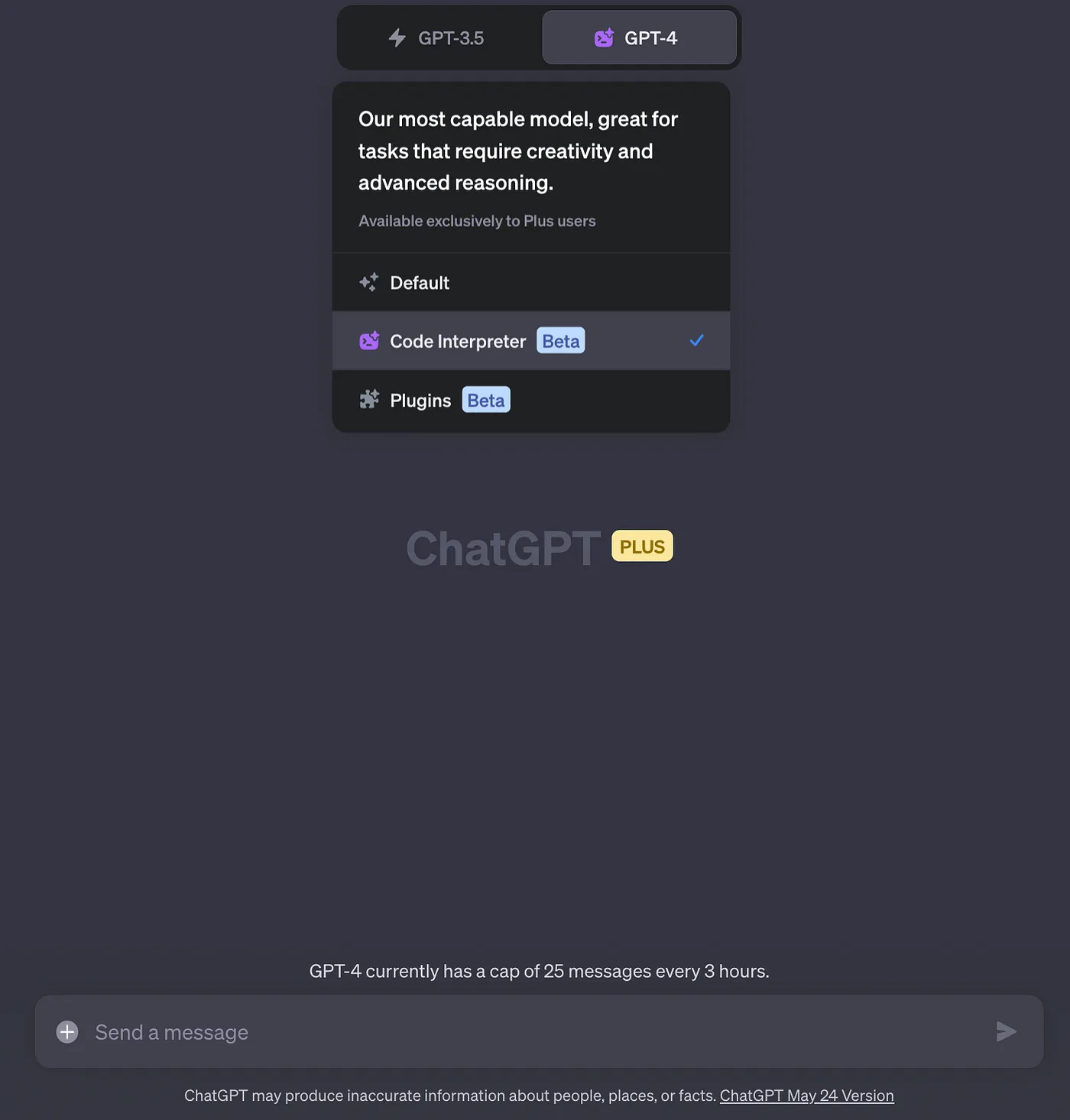

OpenAI a finalement ajouté Code Interpreter à ChatGPT, la fonctionnalité la plus attendue qui ouvre la porte à tant de possibilités. Après les Plugins ChatGPT, les gens attendaient Code Interpreter, qui est maintenant sorti de la version Alpha et disponible en Beta pour les utilisateurs de ChatGPT Plus.

Mais qu’est-ce que ChatGPT Code Interpreter et comment fonctionne-t-il ? Pour en savoir plus, lisez la suite.

Qu’est-ce que Code Interpreter dans ChatGPT ?

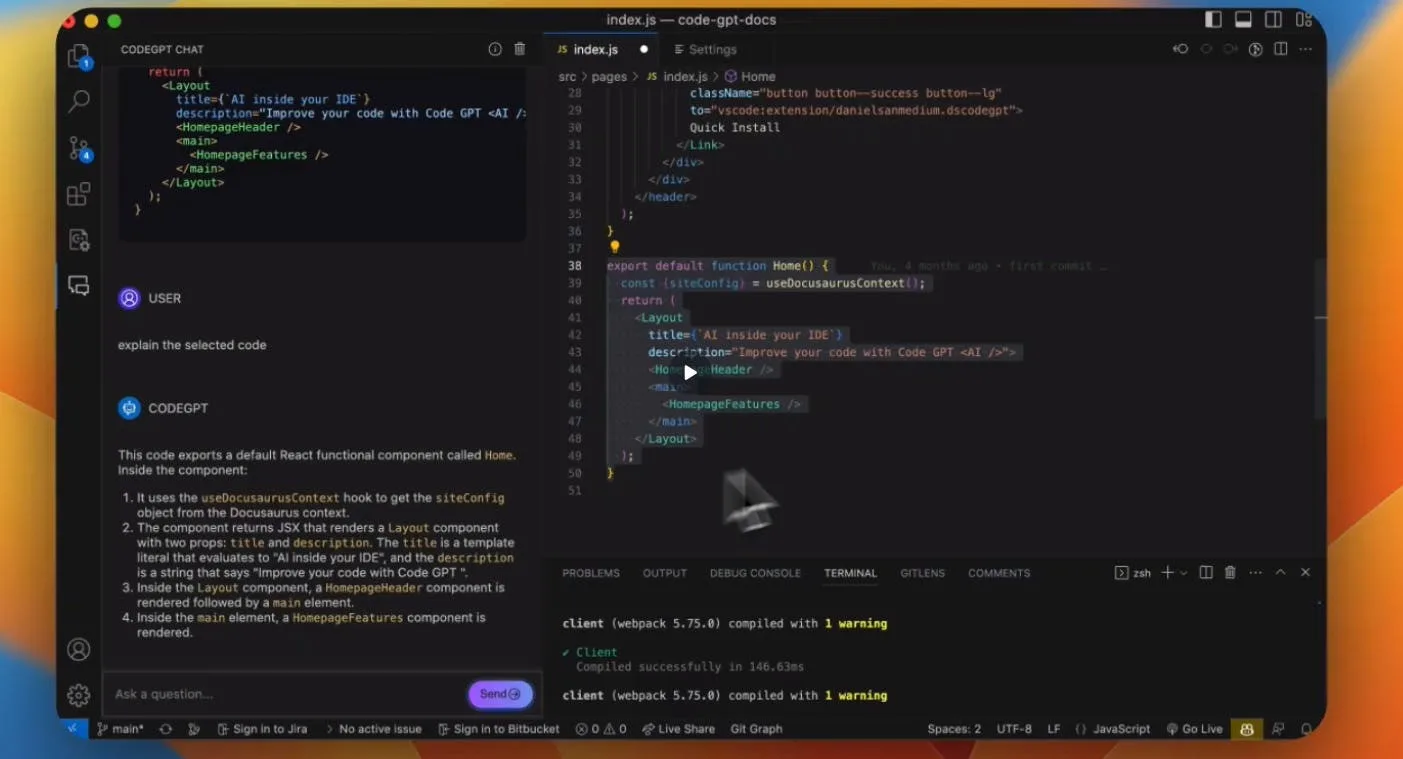

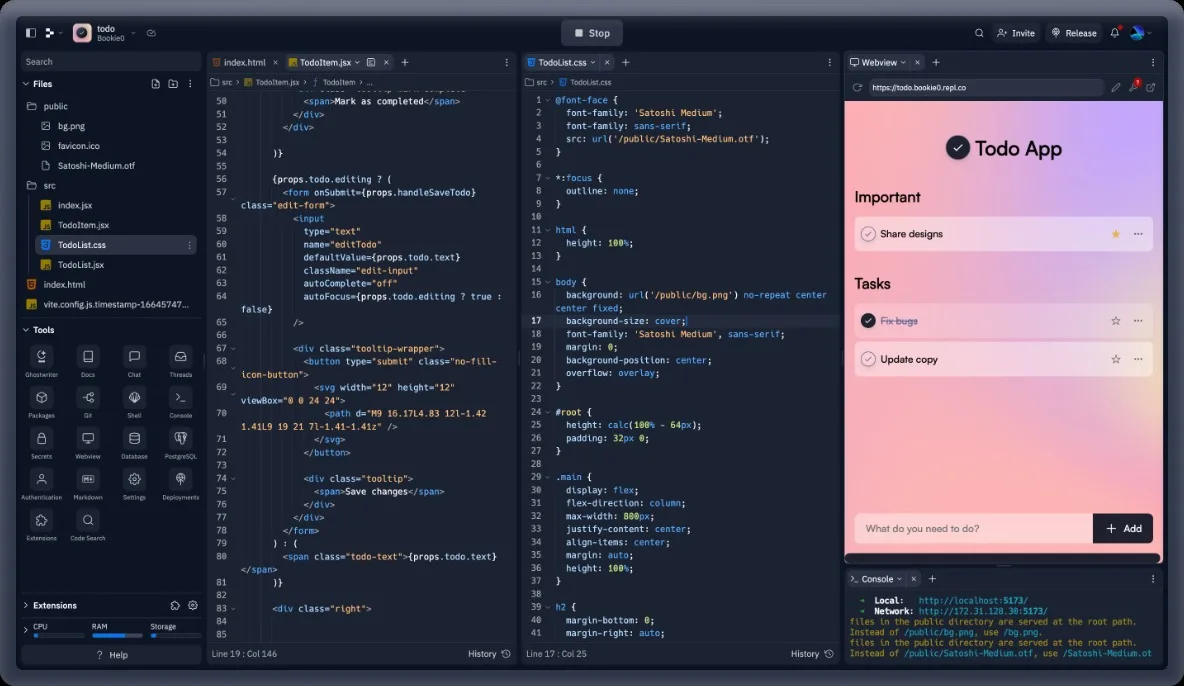

Code Interpreter est la dernière fonctionnalité de ChatGPT (en particulier, avec le modèle GPT-4) qui vous permet d’exécuter du code Python dans un environnement de travail réel. Il s’agit essentiellement d’un environnement Python en bac à sable dans lequel vous pouvez exécuter du code Python pour effectuer n’importe quelle tâche. Cela peut sembler être une fonctionnalité conçue pour les développeurs, mais elle peut également aider les utilisateurs généraux dans de nombreuses tâches.

Par exemple, vous pouvez demander à Code Interpreter dans ChatGPT de convertir un fichier PDF à l’aide de l’OCR, de découper un fichier vidéo ou d’en changer le format, de résoudre un problème mathématique, d’effectuer une analyse et une visualisation de données, de créer des graphiques, des diagrammes, et bien d’autres choses encore. En conséquence, Code Interpreter vous permet de télécharger directement des fichiers locaux vers ChatGPT dans de multiples formats.

Code Interpreter offre également un espace disque temporaire pour télécharger vos fichiers. Il prend en charge une grande variété de formats de fichiers, y compris des formats populaires tels que TXT, PDF, DOC, DOCX, JPEG, PNG, MP4, AVI, CSV, JSON, XML, XLS, XLSX, CPP, PY, HTML, PDF, DB, SQLite, et bien d’autres encore. Il ne s’agit pas d’une liste exhaustive, mais d’une représentation populaire des formats de fichiers dans diverses catégories. Vous pouvez consulter la liste complète dans le tweet ci-dessous.

ChatGPT Code Interpreter can access over 300 python packages.

Here’s the complete list — with a short description of each generated by ChatGPT pic.twitter.com/tSza0EXJGj

— Gavriel Cohen (@Gavriel_Cohen) July 9, 2023

En termes simples, avec Code Interpreter dans ChatGPT, vous avez accès à un ordinateur à l’intérieur du chatbot avec des ressources de calcul et de l’espace disque. Vous pouvez faire à peu près tout ce que vous voulez grâce au langage naturel. Cela dit, n’oubliez pas que vous ne pouvez pas installer de bibliothèques Python par vous-même. Il s’agit d’un environnement en bac à sable, protégé par un pare-feu et préinstallé avec plus de 300 bibliothèques et paquets.

Comment fonctionne Code Interpreter dans ChatGPT ?

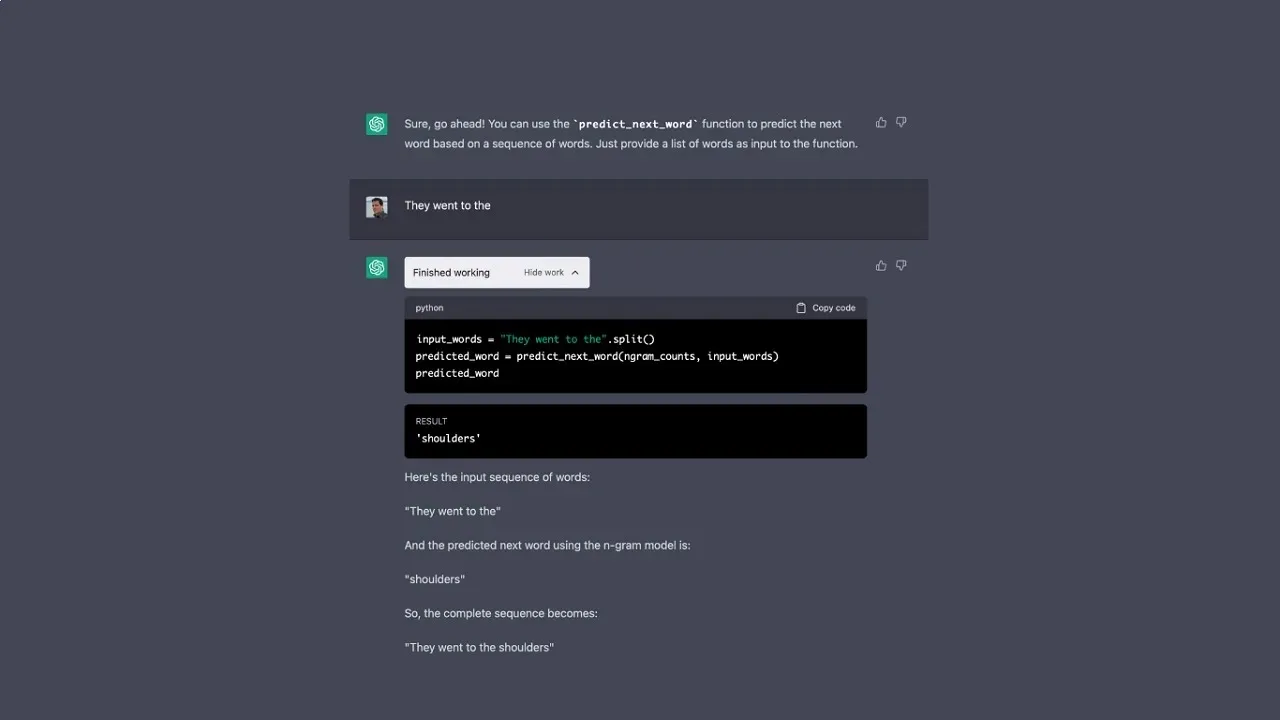

Comme mentionné ci-dessus, Code Interpreter exécute du code Python pour effectuer une tâche dans l’interface de ChatGPT. Par exemple, si vous lui demandez de rendre un PDF basé sur une image consultable en utilisant l’OCR, il crée un script Python personnalisé à la volée et l’exécute à ce moment-là. Vous n’avez qu’à télécharger votre fichier PDF, et il se chargera de tout dans le backend. Vous pouvez vérifier toutes les bibliothèques qu’il utilise, où il se bloque, etc.

OpenAI n’a pas mentionné la taille limite des fichiers pour Code Interpreter. Beaucoup ont suggéré qu’il pouvait traiter des fichiers de moins de 100 Mo, mais j’ai téléchargé un fichier PDF de 170 Mo et cela a fonctionné sans problème. Vous pouvez l’essayer par vous-même et vérifier s’il traite bien les gros fichiers. Cela dit, les fichiers téléchargés sont supprimés lorsque vous quittez la session de chat.

Qui peut accéder à Code Interpreter dans ChatGPT ?

Code Interpreter n’est pas disponible dans la version gratuite de ChatGPT. Vous devez vous abonner à ChatGPT Plus (20 dollars par mois) et passer au modèle GPT-4 pour pouvoir l’utiliser. À partir de cette semaine, OpenAI met Code Interpreter à la disposition de tous les utilisateurs payants, il est donc probable que vous l’obteniez dans quelques jours.