Zoom continue d’évoluer avec une mise à jour majeure de son AI Companion, qui deviendra « agentique » dès la fin du mois. Cette nouvelle capacité permettra à l’IA de réaliser automatiquement des tâches pour les utilisateurs, notamment la planification de réunions de suivi, la génération de documents et la création de clips vidéo.

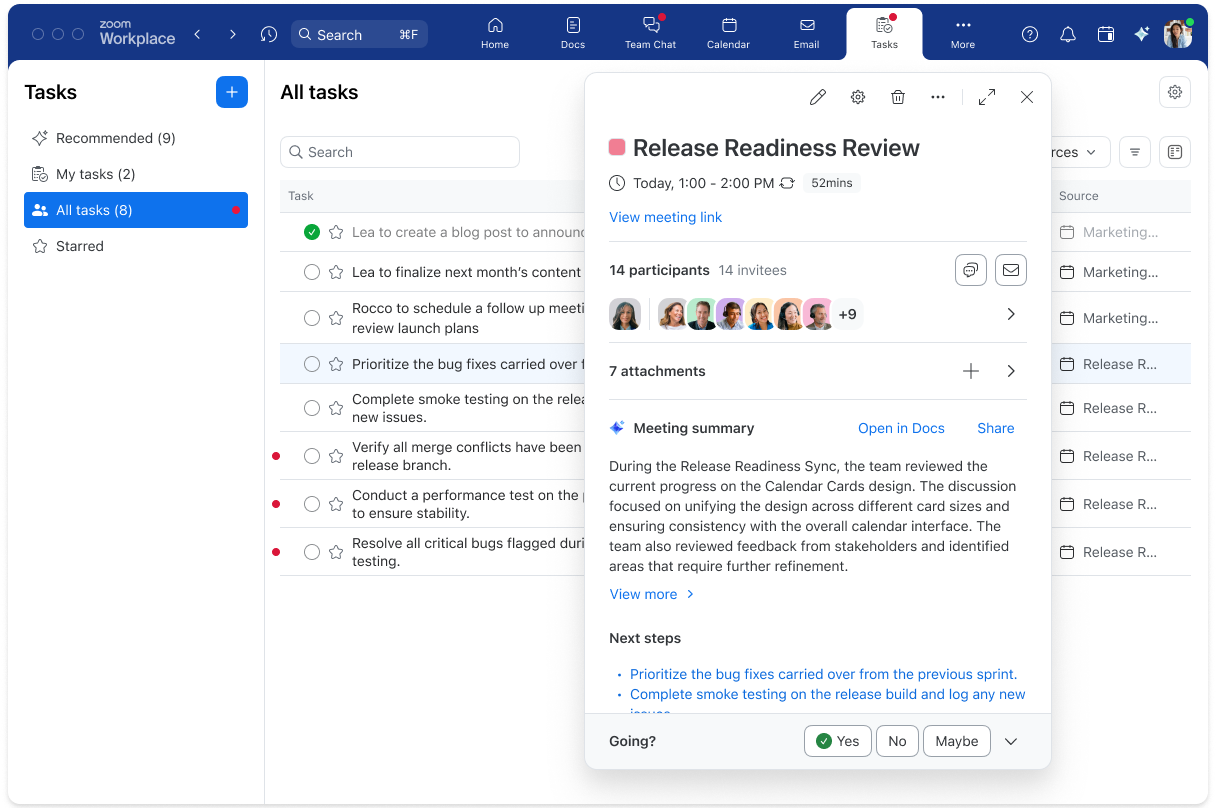

Les utilisateurs de Zoom Workplace auront accès à ces nouvelles fonctionnalités via un onglet dédié aux tâches, où ils pourront déléguer des actions à l’IA. Parmi les principales nouveautés :

- Planification automatique de réunions de suivi

- Génération de documents à partir des réunions

- Création de clips vidéo récapitulatifs

Ces améliorations s’inscrivent dans la vision de Smita Hashim, Chief Product Officer chez Zoom : « Nous voyons l’IA s’intégrer dans chaque produit et interaction pour aider les utilisateurs à être plus efficaces ».

Nouveaux outils d’IA pour améliorer la productivité dans Zoom

Zoom ne s’arrête pas là et introduira bientôt d’autres fonctionnalités alimentées par l’IA :

- Un nouvel enregistreur vocal pour Zoom Workplace (avril 2024) : Il enregistrera, transcrira et résumera automatiquement les réunions en personne via l’application mobile.

- Notes en temps réel pour Zoom Meetings et Phone (mai 2024) : Cette fonctionnalité générera des résumés en direct pendant les appels et réunions, facilitant le suivi des discussions.

Bonne nouvelle : ces nouvelles fonctions IA seront gratuites pour les utilisateurs de Zoom Workplace.

Zoom lance un compagnon IA personnalisé à 12 dollars/mois

En mai, Zoom proposera également un abonnement premium à 12 dollars/mois, baptisé Custom AI Companion. Cette option inclura :

- Un avatar IA personnalisé, généré à partir de votre image, qui pourra envoyer des messages à votre équipe.

- Des modèles d’avatars génériques, accessibles gratuitement pour tous les utilisateurs.

Zoom veut s’imposer comme un leader de l’IA en entreprise

Avec cette intégration poussée de l’IA, Zoom ne se contente pas d’ajouter des fonctionnalités : elle cherche à révolutionner la collaboration en ligne. L’automatisation des tâches et les résumés intelligents pourraient bien changer la façon dont les professionnels utilisent la plateforme.

Reste à voir si ces innovations suffiront à concurrencer des outils comme Microsoft Teams et Google Meet, qui intègrent eux aussi des solutions d’IA avancées.